Hi,

I currently have a problem which should not be a problem at all.

I have added a LCX container to my proxmox and wanted to mount a ZFS storage to it.

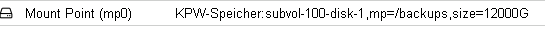

So that I can then build a Samba share over it. I then added the following as a mount point.

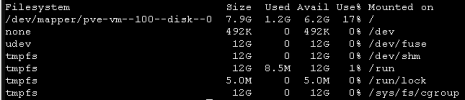

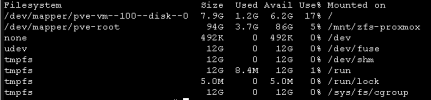

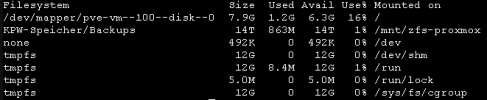

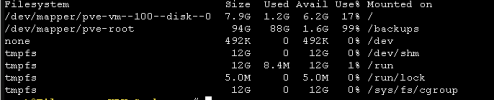

But the result in the container looks like this.

Now where does the /dev/mapper/pve-root come from?

Shouldn't it have said : kpw-storage/subvol-100-disk-1

My ProxMox Config looks like this.

/etc/pve/lxc/100.conf

arch: amd64

cores: 2

features: mount=nfs;cifs,nesting=1

hostname: Fileserver-KPW-Garbsen

memory: 1024

mp0: KPW-Speicher:subvol-100-disk-1,mp=/backups,size=12000G

net0: name=eth0,bridge=vmbr0,firewall=1,hwaddr=C6:00:00:00:00:00:00,ip=dhcp,type=veth

onboot: 1

ostype: debian

parent: Start

rootfs: local-lvm:vm-100-disk-0,size=8G

swap: 1024

Of course the drive was already full after two backups, that's when I first noticed this error.

What did I do wrong? How can I correct this?

I am very grateful for every tip.

Greetings

Tigger30926

I currently have a problem which should not be a problem at all.

I have added a LCX container to my proxmox and wanted to mount a ZFS storage to it.

So that I can then build a Samba share over it. I then added the following as a mount point.

But the result in the container looks like this.

Now where does the /dev/mapper/pve-root come from?

Shouldn't it have said : kpw-storage/subvol-100-disk-1

My ProxMox Config looks like this.

/etc/pve/lxc/100.conf

arch: amd64

cores: 2

features: mount=nfs;cifs,nesting=1

hostname: Fileserver-KPW-Garbsen

memory: 1024

mp0: KPW-Speicher:subvol-100-disk-1,mp=/backups,size=12000G

net0: name=eth0,bridge=vmbr0,firewall=1,hwaddr=C6:00:00:00:00:00:00,ip=dhcp,type=veth

onboot: 1

ostype: debian

parent: Start

rootfs: local-lvm:vm-100-disk-0,size=8G

swap: 1024

Of course the drive was already full after two backups, that's when I first noticed this error.

What did I do wrong? How can I correct this?

I am very grateful for every tip.

Greetings

Tigger30926