[SOLVED] LXC HD Größe

- Thread starter DocMAX

- Start date

You are using an out of date browser. It may not display this or other websites correctly.

You should upgrade or use an alternative browser.

You should upgrade or use an alternative browser.

Hi,

könntest du mal bitte die Ausgabe von

Ich nehme an dein ZFS pool (ausgehend vom "zpool" Namen) ist ~2.7TB groß?

Da ich es gerade ausprobiert habe (frischer LXC auf einem ZFS pool) und nicht so nachstellen konnte.

könntest du mal bitte die Ausgabe von

pveversion -v und cat /etc/pve/storage.cfg posten?Ich nehme an dein ZFS pool (ausgehend vom "zpool" Namen) ist ~2.7TB groß?

Da ich es gerade ausprobiert habe (frischer LXC auf einem ZFS pool) und nicht so nachstellen konnte.

Anbei die Ausgaben:

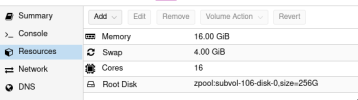

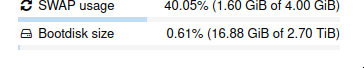

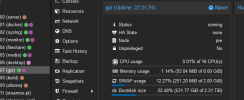

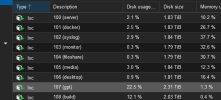

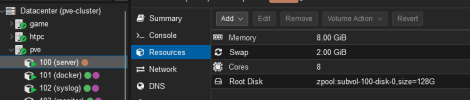

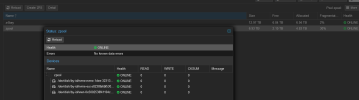

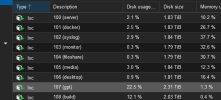

Stelle gerade fest dass alle meine LXC komische disk sizes anzeigen. Weiss nicht wo PVE das her hat...

Sind auf jedenfall nicht die Größen, die ich angegeben habe beim Erstellen (z.B. 128G, 256G, 512G)

z.B.:

Zpool:

Stelle gerade fest dass alle meine LXC komische disk sizes anzeigen. Weiss nicht wo PVE das her hat...

Sind auf jedenfall nicht die Größen, die ich angegeben habe beim Erstellen (z.B. 128G, 256G, 512G)

z.B.:

Zpool:

Code:

root@pve:~# pveversion -v

proxmox-ve: 8.1.0 (running kernel: 6.5.11-7-pve)

pve-manager: 8.1.4 (running version: 8.1.4/ec5affc9e41f1d79)

proxmox-kernel-helper: 8.1.0

proxmox-kernel-6.5: 6.5.11-8

proxmox-kernel-6.5.11-8-pve-signed: 6.5.11-8

proxmox-kernel-6.5.11-7-pve-signed: 6.5.11-7

ceph: 17.2.7-pve2

ceph-fuse: 17.2.7-pve2

corosync: 3.1.7-pve3

criu: 3.17.1-2

glusterfs-client: 10.3-5

ifupdown: residual config

ifupdown2: 3.2.0-1+pmx8

libjs-extjs: 7.0.0-4

libknet1: 1.28-pve1

libproxmox-acme-perl: 1.5.0

libproxmox-backup-qemu0: 1.4.1

libproxmox-rs-perl: 0.3.3

libpve-access-control: 8.0.7

libpve-apiclient-perl: 3.3.1

libpve-common-perl: 8.1.0

libpve-guest-common-perl: 5.0.6

libpve-http-server-perl: 5.0.5

libpve-network-perl: 0.9.5

libpve-rs-perl: 0.8.8

libpve-storage-perl: 8.0.5

libspice-server1: 0.15.1-1

lvm2: 2.03.16-2

lxc-pve: 5.0.2-4

lxcfs: 5.0.3-pve4

novnc-pve: 1.4.0-3

proxmox-backup-client: 3.1.4-1

proxmox-backup-file-restore: 3.1.4-1

proxmox-kernel-helper: 8.1.0

proxmox-mail-forward: 0.2.3

proxmox-mini-journalreader: 1.4.0

proxmox-offline-mirror-helper: 0.6.4

proxmox-widget-toolkit: 4.1.3

pve-cluster: 8.0.5

pve-container: 5.0.8

pve-docs: 8.1.3

pve-edk2-firmware: 4.2023.08-3

pve-firewall: 5.0.3

pve-firmware: 3.9-1

pve-ha-manager: 4.0.3

pve-i18n: 3.2.0

pve-qemu-kvm: 8.1.5-2

pve-xtermjs: 5.3.0-3

pve-zsync: 2.3.0

qemu-server: 8.0.10

smartmontools: 7.3-pve1

spiceterm: 3.3.0

swtpm: 0.8.0+pve1

vncterm: 1.8.0

zfsutils-linux: 2.2.2-pve1

root@pve:~# cat /etc/pve/storage.cfg

dir: local

path /var/lib/vz

content vztmpl

prune-backups keep-all=1

shared 0

zfspool: zpool

pool zpool

content rootdir,images

mountpoint /zpool

nodes pve

sparse 1

nfs: zpool-nfs

export /zpool/nfs

path /mnt/pve/zpool-nfs

server pve

content rootdir,images,iso

options soft

prune-backups keep-all=1

pbs: pbs-z4bay

datastore z4bay

server pve

content backup

fingerprint 1c:5a:6d:58:0e:c9:2c:23:d4:e4:2f:b2:e7:e6:94:52:a3:1f:85:8b:3a:3f:a5:58:9b:9e:da:b5:38:14:9c:67

prune-backups keep-all=1

username root@pamAttachments

Last edited:

Hm. Hast du sonst irgendwas verändert, z.B. third-party Skripte o.ä. laufen lassen?

Könntest du noch bitte die Ausgabe von

Könntest du noch bitte die Ausgabe von

pct df 100 und zfs list posten? Das wären noch interessante Informationen.

Code:

root@pve:~# zfs list -r zpool

NAME USED AVAIL REFER MOUNTPOINT

zpool 4.43T 1.75T 152K /zpool

zpool/data 3.09T 1.75T 2.12T /mnt/pve/data

zpool/nfs 258G 1.75T 258G /zpool/nfs

zpool/subvol-100-disk-0 40.3G 1.75T 39.9G /zpool/subvol-100-disk-0

zpool/subvol-101-disk-0 46.5G 1.75T 46.4G /zpool/subvol-101-disk-0

zpool/subvol-102-disk-0 55.2G 1.75T 55.2G /zpool/subvol-102-disk-0

zpool/subvol-103-disk-0 5.98G 1.75T 5.42G /zpool/subvol-103-disk-0

zpool/subvol-104-disk-0 8.44G 1.75T 6.39G /zpool/subvol-104-disk-0

zpool/subvol-105-disk-0 55.9G 1.75T 55.9G /zpool/subvol-105-disk-0

zpool/subvol-106-disk-0 17.3G 1.75T 17.3G /zpool/subvol-106-disk-0

zpool/subvol-107-disk-0 542G 1.75T 542G /zpool/subvol-107-disk-0

zpool/subvol-108-disk-0 252G 1.75T 252G /zpool/subvol-108-disk-0

zpool/subvol-109-disk-0 9.66G 246G 9.66G /zpool/subvol-109-disk-0

zpool/vm-113-disk-0 172M 1.75T 172M -

zpool/vm-113-disk-1 336M 1.75T 336M -

zpool/vm-113-disk-2 661M 1.75T 661M -

zpool/vm-113-disk-3 171M 1.75T 171M -

zpool/vm-113-disk-4 3.88G 1.75T 3.88G -

zpool/vm-201-disk-0 5.70G 1.75T 5.70G -

zpool/vm-207-disk-0 156K 1.75T 156K -

zpool/vm-207-disk-1 22.3G 1.75T 22.3G -

zpool/vm-208-disk-0 208K 1.75T 132K -

zpool/vm-208-disk-1 42.2G 1.75T 38.3G -

root@pve:~# pct df 100 [13/13]

MP Volume Size Used Avail Use% Path

rootfs zpool:subvol-100-disk-0 1.8T 39.9G 1.8T 0.0 /Also ich habe mal die Subvol aus einem Backup per zfs send/recv wiederhergestellt. Ich weiss nicht ob PVE vielleicht damit ein Problem hat. Woher nimmt PVE sich denn überhaupt die Größenangabe?

109 habe ich glaube ich nachträglich angelegt, was "246G" zeigt. Hatte ich mit 256G angelegt. Kann man die größen evtl. nachtäglich nochmal ändern?

Hat "zfs set quota" etwas damit zu tun?

Last edited:

Im Prinzip wird einWoher nimmt PVE sich denn überhaupt die Größenangabe?

df /proc/$pid/root gemacht, wobei $pid der init-Prozess im Container ist.Aber das klingt nach dem root-cause. Alle subvolumes haben die Größe des pools (in dem Fall, ~1.7TB).Also ich habe mal die Subvol aus einem Backup per zfs send/recv wiederhergestellt.

Hast du eben die subvolumes damals einfach per

zfs recv wieder hergestellt? Und wie die configs?Das Wichtige, die in dem Fall die Volume-Größe bestimmt, ist die

refquota dataset property. Du kannst dass auch mal anschauen mit zfs list -o name,refquota.Du kannst das jetzt fixen indem du manuall für sämtliche

zpool/vm-*-disk-* datasets diese property mit der richtigen Größe setzt, mit zfs set refquota=<x>G zpool/vm-<vmid>-disk-<n>.Perfekt!

Dann bitte noch den Thread als SOLVED markieren (1. Post bearbeiten, da sollte ein Dropdown beim Titel-Feld sein), dann können ihn andere in Zukunft leichter finden

Dann bitte noch den Thread als SOLVED markieren (1. Post bearbeiten, da sollte ein Dropdown beim Titel-Feld sein), dann können ihn andere in Zukunft leichter finden