Hallo,

ich bin noch relativer Anfänger mit Proxmox, habe mit einigen VMs und Containern erste Gehversuche gemacht, mein ursprüngliches bare metal installiertes Linuxsystem mit Veeam in eine VM migriert, etc. etc.

Mein nächstes Projekt ist jetzt eine VM mit einem Veeam VBR Server, eine VM mit Ubuntu die mein NAS als imutable Backup Repository einbindet und auf Dateiebene mache VMs sichert.

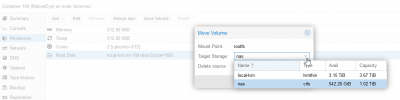

Als Newbie habe ich bei der Installation von Proxmox allerdings alles erstmal in das große local-lvm Volume geworfen und kann die virtual disks der VMs nun nicht mehr einfach so mit Veeam abgreifen und sichern.

Mein Ansatz war jetzt folgender: Alle VMs und Container aus dem local-lvm raus, dieses löschen, den Speicher "local" erweitern (da nur 100GB groß) und die VMs und Container dortin migrieren. Bei den VMs kann ich ja einfach sagen das ich die Disk verschieben möchte und ich konnte sie auch alle (bis auf eine VM wegen der Größe) auf mein NAS (was ich dafür temporär per CIFS angebunden habe) verschieben. Die andere VM sichere ich per Backup und wollte sie per Restore zurück holen (in der Disk selbst ist nicht der komplette Platz verbraucht, daher passt wenigstens das Backup auf den Server). Hier bitte schreien, wenn jemand einen Denkfehler entdeckt!

Mein eigentliches Problem sind aber meine beiden LXC Container. Ich kann sie nicht von local-lvm zu local verschieben, am Ende erhalte ich nach dem Verschieben eine RAW Datei von der ich nicht starten kann. Backup und Restore funktionieren ebenso wenig wie das Konvertieren der RAW Datei. Mir ist klar, dass das eine block- das andere dateibasiert ist, ich hätte nur erwartet, dass das entsprechend konvertiert wird, oder es hier Möglichkeiten git, konnte aber nirgends etwas finden.

Habe ich eine Chance die Container auf dateibasierten Speicher zu bringen, oder muss ich die neu aufsetzen?

ich bin noch relativer Anfänger mit Proxmox, habe mit einigen VMs und Containern erste Gehversuche gemacht, mein ursprüngliches bare metal installiertes Linuxsystem mit Veeam in eine VM migriert, etc. etc.

Mein nächstes Projekt ist jetzt eine VM mit einem Veeam VBR Server, eine VM mit Ubuntu die mein NAS als imutable Backup Repository einbindet und auf Dateiebene mache VMs sichert.

Als Newbie habe ich bei der Installation von Proxmox allerdings alles erstmal in das große local-lvm Volume geworfen und kann die virtual disks der VMs nun nicht mehr einfach so mit Veeam abgreifen und sichern.

Mein Ansatz war jetzt folgender: Alle VMs und Container aus dem local-lvm raus, dieses löschen, den Speicher "local" erweitern (da nur 100GB groß) und die VMs und Container dortin migrieren. Bei den VMs kann ich ja einfach sagen das ich die Disk verschieben möchte und ich konnte sie auch alle (bis auf eine VM wegen der Größe) auf mein NAS (was ich dafür temporär per CIFS angebunden habe) verschieben. Die andere VM sichere ich per Backup und wollte sie per Restore zurück holen (in der Disk selbst ist nicht der komplette Platz verbraucht, daher passt wenigstens das Backup auf den Server). Hier bitte schreien, wenn jemand einen Denkfehler entdeckt!

Mein eigentliches Problem sind aber meine beiden LXC Container. Ich kann sie nicht von local-lvm zu local verschieben, am Ende erhalte ich nach dem Verschieben eine RAW Datei von der ich nicht starten kann. Backup und Restore funktionieren ebenso wenig wie das Konvertieren der RAW Datei. Mir ist klar, dass das eine block- das andere dateibasiert ist, ich hätte nur erwartet, dass das entsprechend konvertiert wird, oder es hier Möglichkeiten git, konnte aber nirgends etwas finden.

Habe ich eine Chance die Container auf dateibasierten Speicher zu bringen, oder muss ich die neu aufsetzen?