Nach einem Stromausfall durch den Orkan "Sabine" starten die LXC-Container nicht mehr. Proxmox 6.1-5 an sich inkl. Weboberfläche scheint komplett zu funktionieren. Die Container liegen alle in zwei ZFS-Dateisystemen, einmal gespiegelt und einmal ohne extras.

Die Fehlermeldung bei allen 10 Containern lautet:

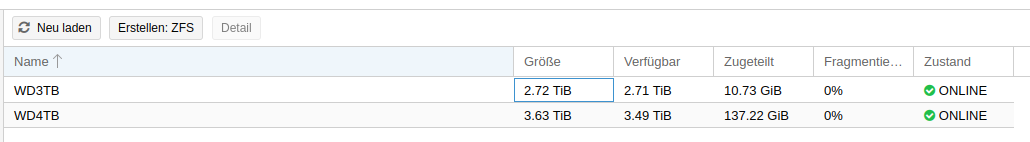

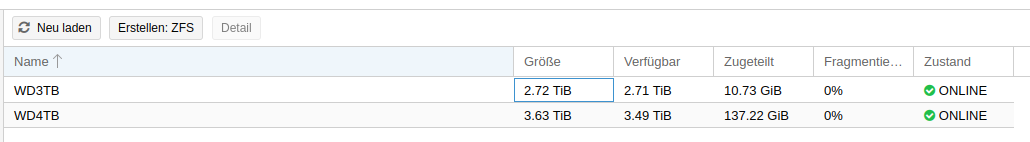

ZFS scheint laut Webübersicht ok zu sein:

zpool status:

Was ist der nächste logische Schritt? Ich denke ein Art fsck wäre sinnvoll ...

Bin für jeden Hinweis dankbar!

Die Fehlermeldung bei allen 10 Containern lautet:

Code:

timed out waiting for client

TASK ERROR: command '/usr/bin/termproxy 5900 --path /vms/102 --perm VM.Console -- /usr/bin/dtach -A /var/run/dtach/vzctlconsole102 -r winch -z lxc-console -n 102 -e -1' failed: exit code 4ZFS scheint laut Webübersicht ok zu sein:

zpool status:

Code:

root@proxmox1:~# zpool status -v

pool: WD3TB

state: ONLINE

scan: scrub repaired 0B in 0 days 00:03:25 with 0 errors on Sun Feb 9 00:27:26 2020

config:

NAME STATE READ WRITE CKSUM

WD3TB ONLINE 0 0 0

wwn-0x50014ee2bc21eeec ONLINE 0 0 0

errors: No known data errors

pool: WD4TB

state: ONLINE

scan: scrub repaired 0B in 0 days 00:36:51 with 0 errors on Sun Feb 9 01:00:55 2020

config:

NAME STATE READ WRITE CKSUM

WD4TB ONLINE 0 0 0

mirror-0 ONLINE 0 0 0

wwn-0x50014ee209a03a05 ONLINE 0 0 0

wwn-0x50014ee211ce4311 ONLINE 0 0 0

errors: No known data errorsWas ist der nächste logische Schritt? Ich denke ein Art fsck wäre sinnvoll ...

Bin für jeden Hinweis dankbar!

Last edited: