Hallo,

eine Anfängerfrage zu LXC Containern:

Ich habe ein Proxmox, 6.3-6, auf dem zwei LXC Container laufen, ein Proxmox Backup Server auf Debian installiert, ein zweites Debian für URBackup.

(OT: wer zfs rocks kennt, kennt gorb das Setup ;-)

Der Backup-Mini Server hat eine SSD auf der sowohl das Proxmox, als auch die Container installiert sind.

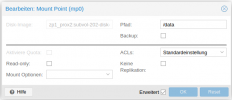

Zusätzlich läuft eine 4 TB NAS Festplatte, von der jeder Container LVM-thin mäßig eine große virtuelle Disk, als Moint Point zugewiesen bekommt.

Folgendermaßen sieht das innerhalb des Containers aus:

Von den Containern wurden vzdumps erzeugt, zB. per:

Dabei WICHTIG: die zweite Festplatte des Containers, in Proxmox der zugewiesene Mount Point, hat die Option "Backup = deaktiviert"

Natürlich wird bei diesem vzdump die zweite Festplatte NICHT mitgesichert und soll nicht mitgesichert werden.

PROBLEM:

Zu Testzwecken habe ich das letzte vzdump des Container heute wieder hergestellt.

Das war es dann mit allen bisherigen Sicherungen. Beim Wiederherstellen wurde vom Container ALLES gelöscht, also auch die zweite Festplatte = Moint Point und somit auch alle darauf liegenden Daten. Die aber im vzdump gar nicht enthalten waren... :-(

siehe Ausgabe unten.

Frage:

Wie sieht hier die sauber funktionierende Lösung aus?

Also die, bei der es möglich ist, nur das System bzw. die virtuelle Systemfestplatte zu sichern und wieder herzustellen, ohne die virtuelle zweite Festplatte zu "removen", sondern die "alte" zweite Festplatte mit allen darauf befindlichen Daten wieder per Moint Point in das wiederhergestellte System einbinden zu können?

Grüße,

maxprox

eine Anfängerfrage zu LXC Containern:

Ich habe ein Proxmox, 6.3-6, auf dem zwei LXC Container laufen, ein Proxmox Backup Server auf Debian installiert, ein zweites Debian für URBackup.

(OT: wer zfs rocks kennt, kennt gorb das Setup ;-)

Der Backup-Mini Server hat eine SSD auf der sowohl das Proxmox, als auch die Container installiert sind.

Zusätzlich läuft eine 4 TB NAS Festplatte, von der jeder Container LVM-thin mäßig eine große virtuelle Disk, als Moint Point zugewiesen bekommt.

Folgendermaßen sieht das innerhalb des Containers aus:

Code:

19:31root@pbs~# df -hT

Filesystem Type Size Used Avail Use% Mounted on

/dev/mapper/pve-vm--100--disk--0 ext4 14G 2.3G 11G 18% /

/dev/mapper/thinpool4t-vm--100--disk--0 ext4 2.5T 17G 2.4T 1% /srv/pbspoolVon den Containern wurden vzdumps erzeugt, zB. per:

Code:

vzdump 100 --mode stop --compress zstd --dumpdir /srv/dumpool/Natürlich wird bei diesem vzdump die zweite Festplatte NICHT mitgesichert und soll nicht mitgesichert werden.

PROBLEM:

Zu Testzwecken habe ich das letzte vzdump des Container heute wieder hergestellt.

Code:

pct restore 100 /var/lib/vz/dump/vzdump-lxc-100-2021_04_05-14_51_48.tar.zst --storage local-lvmsiehe Ausgabe unten.

Frage:

Wie sieht hier die sauber funktionierende Lösung aus?

Also die, bei der es möglich ist, nur das System bzw. die virtuelle Systemfestplatte zu sichern und wieder herzustellen, ohne die virtuelle zweite Festplatte zu "removen", sondern die "alte" zweite Festplatte mit allen darauf befindlichen Daten wieder per Moint Point in das wiederhergestellte System einbinden zu können?

Grüße,

maxprox

Code:

## pct restore Ausgabe:

recovering backed-up configuration from 'local:backup/vzdump-lxc-100-2021_04_05-14_51_48.tar.zst'

Logical volume "vm-100-disk-1" created.

Creating filesystem with 3670016 4k blocks and 917504 inodes

Filesystem UUID: eb30a014-899d-4c4d-9a9c-b97c33d4fdeb

Superblock backups stored on blocks:

32768, 98304, 163840, 229376, 294912, 819200, 884736, 1605632, 2654208

WARNING: You have not turned on protection against thin pools running out of space.

WARNING: Set activation/thin_pool_autoextend_threshold below 100 to trigger automatic extension of thin pools before they get full.

Logical volume "vm-100-disk-2" created.

WARNING: Sum of all thin volume sizes (<2.55 TiB) exceeds the size of thin pool pve/data and the size of whole volume group (<223.07 GiB).

Creating filesystem with 672661504 4k blocks and 168165376 inodes

Filesystem UUID: 38039d89-86cf-4098-a675-9a4e700d3289

Superblock backups stored on blocks:

32768, 98304, 163840, 229376, 294912, 819200, 884736, 1605632, 2654208,

4096000, 7962624, 11239424, 20480000, 23887872, 71663616, 78675968,

102400000, 214990848, 512000000, 550731776, 644972544

Logical volume "vm-100-disk-0" successfully removed

Logical volume "vm-100-disk-0" successfully removed

restoring 'local:backup/vzdump-lxc-100-2021_04_05-14_51_48.tar.zst' now..

extracting archive '/var/lib/vz/dump/vzdump-lxc-100-2021_04_05-14_51_48.tar.zst'

tar: ./var/spool/postfix/dev/random: Cannot mknod: Operation not permitted

tar: ./var/spool/postfix/dev/urandom: Cannot mknod: Operation not permitted

Total bytes read: 2366556160 (2.3GiB, 297MiB/s)

tar: Exiting with failure status due to previous errors

Logical volume "vm-100-disk-1" successfully removed

Logical volume "vm-100-disk-2" successfully removed

TASK ERROR: unable to restore CT 100 - command 'lxc-usernsexec -m u:0:100000:65536 -m g:0:100000:65536 -- tar xpf - --zstd --totals --one-file-system -p --sparse --numeric-owner --acls --xattrs '--xattrs-include=user.*' '--xattrs-include=security.capability' '--warning=no-file-ignored' '--warning=no-xattr-write' -C /var/lib/lxc/100/rootfs --skip-old-files --anchored --exclude './dev/*'' failed: exit code 2

Last edited: