Moin,

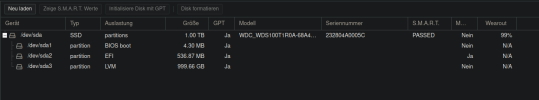

In der Weboberfläche wird mir angezeigt das anscheinen das Verzeichnis /dev/nvme0n1p3 zu 97% ausgelastet wird. Ist das normal oder liegt ein Fehler vor in meiner Proxmox Installation? Bisher habe ich keine Probleme bemerkt.

In der Weboberfläche wird mir angezeigt das anscheinen das Verzeichnis /dev/nvme0n1p3 zu 97% ausgelastet wird. Ist das normal oder liegt ein Fehler vor in meiner Proxmox Installation? Bisher habe ich keine Probleme bemerkt.

proxmox-ve: 6.3-1 (running kernel: 5.4.78-2-pve)

pve-manager: 6.3-3 (running version: 6.3-3/eee5f901)

pve-kernel-5.4: 6.3-3

pve-kernel-helper: 6.3-3

pve-kernel-5.4.78-2-pve: 5.4.78-2

pve-kernel-5.4.78-1-pve: 5.4.78-1

pve-kernel-5.4.73-1-pve: 5.4.73-1

pve-kernel-5.4.65-1-pve: 5.4.65-1

pve-kernel-5.4.34-1-pve: 5.4.34-2

ceph-fuse: 12.2.11+dfsg1-2.1+b1

corosync: 3.0.4-pve1

criu: 3.11-3

glusterfs-client: 5.5-3

ifupdown: 0.8.35+pve1

ksm-control-daemon: 1.3-1

libjs-extjs: 6.0.1-10

libknet1: 1.16-pve1

libproxmox-acme-perl: 1.0.7

libproxmox-backup-qemu0: 1.0.2-1

libpve-access-control: 6.1-3

libpve-apiclient-perl: 3.1-3

libpve-common-perl: 6.3-2

libpve-guest-common-perl: 3.1-3

libpve-http-server-perl: 3.1-1

libpve-storage-perl: 6.3-3

libqb0: 1.0.5-1

libspice-server1: 0.14.2-4~pve6+1

lvm2: 2.03.02-pve4

lxc-pve: 4.0.3-1

lxcfs: 4.0.3-pve3

novnc-pve: 1.1.0-1

proxmox-backup-client: 1.0.6-1

proxmox-mini-journalreader: 1.1-1

proxmox-widget-toolkit: 2.4-3

pve-cluster: 6.2-1

pve-container: 3.3-2

pve-docs: 6.3-1

pve-edk2-firmware: 2.20200531-1

pve-firewall: 4.1-3

pve-firmware: 3.1-3

pve-ha-manager: 3.1-1

pve-i18n: 2.2-2

pve-qemu-kvm: 5.1.0-7

pve-xtermjs: 4.7.0-3

qemu-server: 6.3-2

smartmontools: 7.1-pve2

spiceterm: 3.1-1

vncterm: 1.6-2

zfsutils-linux: 0.8.5-pve1

pve-manager: 6.3-3 (running version: 6.3-3/eee5f901)

pve-kernel-5.4: 6.3-3

pve-kernel-helper: 6.3-3

pve-kernel-5.4.78-2-pve: 5.4.78-2

pve-kernel-5.4.78-1-pve: 5.4.78-1

pve-kernel-5.4.73-1-pve: 5.4.73-1

pve-kernel-5.4.65-1-pve: 5.4.65-1

pve-kernel-5.4.34-1-pve: 5.4.34-2

ceph-fuse: 12.2.11+dfsg1-2.1+b1

corosync: 3.0.4-pve1

criu: 3.11-3

glusterfs-client: 5.5-3

ifupdown: 0.8.35+pve1

ksm-control-daemon: 1.3-1

libjs-extjs: 6.0.1-10

libknet1: 1.16-pve1

libproxmox-acme-perl: 1.0.7

libproxmox-backup-qemu0: 1.0.2-1

libpve-access-control: 6.1-3

libpve-apiclient-perl: 3.1-3

libpve-common-perl: 6.3-2

libpve-guest-common-perl: 3.1-3

libpve-http-server-perl: 3.1-1

libpve-storage-perl: 6.3-3

libqb0: 1.0.5-1

libspice-server1: 0.14.2-4~pve6+1

lvm2: 2.03.02-pve4

lxc-pve: 4.0.3-1

lxcfs: 4.0.3-pve3

novnc-pve: 1.1.0-1

proxmox-backup-client: 1.0.6-1

proxmox-mini-journalreader: 1.1-1

proxmox-widget-toolkit: 2.4-3

pve-cluster: 6.2-1

pve-container: 3.3-2

pve-docs: 6.3-1

pve-edk2-firmware: 2.20200531-1

pve-firewall: 4.1-3

pve-firmware: 3.1-3

pve-ha-manager: 3.1-1

pve-i18n: 2.2-2

pve-qemu-kvm: 5.1.0-7

pve-xtermjs: 4.7.0-3

qemu-server: 6.3-2

smartmontools: 7.1-pve2

spiceterm: 3.1-1

vncterm: 1.6-2

zfsutils-linux: 0.8.5-pve1

fdisk -l

Disk /dev/loop0: 50 GiB, 53687091200 bytes, 104857600 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 512 bytes

I/O size (minimum/optimal): 512 bytes / 512 bytes

Disk /dev/nvme0n1: 465.8 GiB, 500107862016 bytes, 976773168 sectors

Disk model: Samsung SSD 970 EVO 500GB

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 512 bytes

I/O size (minimum/optimal): 512 bytes / 512 bytes

Disklabel type: gpt

Disk identifier: 847FEC37-83DC-4E1D-A72D-C577421BE247

Device Start End Sectors Size Type

/dev/nvme0n1p1 34 2047 2014 1007K BIOS boot

/dev/nvme0n1p2 2048 1050623 1048576 512M EFI System

/dev/nvme0n1p3 1050624 976773134 975722511 465.3G Linux LVM

Disk /dev/sda: 238.5 GiB, 256060514304 bytes, 500118192 sectors

Disk model: M4-CT256M4SSD2

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 512 bytes

I/O size (minimum/optimal): 512 bytes / 512 bytes

Disk /dev/sdb: 931.5 GiB, 1000204886016 bytes, 1953525168 sectors

Disk model: TOSHIBA MQ02ABF1

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 4096 bytes

I/O size (minimum/optimal): 4096 bytes / 4096 bytes

Disklabel type: gpt

Disk identifier: 1340AA31-D12B-4660-A7E6-49783817F463

Device Start End Sectors Size Type

/dev/sdb1 2048 1953525134 1953523087 931.5G Linux filesystem

Disk /dev/mapper/pve-swap: 8 GiB, 8589934592 bytes, 16777216 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 512 bytes

I/O size (minimum/optimal): 512 bytes / 512 bytes

Disk /dev/mapper/pve-root: 96 GiB, 103079215104 bytes, 201326592 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 512 bytes

I/O size (minimum/optimal): 512 bytes / 512 bytes

Disk /dev/mapper/pve-vm--103--disk--0: 10 GiB, 10737418240 bytes, 20971520 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 512 bytes

I/O size (minimum/optimal): 65536 bytes / 65536 bytes

Disk /dev/mapper/pve-vm--101--disk--0: 8 GiB, 8589934592 bytes, 16777216 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 512 bytes

I/O size (minimum/optimal): 65536 bytes / 65536 bytes

Disk /dev/mapper/pve-vm--100--disk--0: 8 GiB, 8589934592 bytes, 16777216 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 512 bytes

I/O size (minimum/optimal): 65536 bytes / 65536 bytes

Disk /dev/mapper/pve-vm--104--disk--0: 28 GiB, 30064771072 bytes, 58720256 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 512 bytes

I/O size (minimum/optimal): 65536 bytes / 65536 bytes

Disk /dev/mapper/sdadisk: 238.5 GiB, 256043737088 bytes, 500085424 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 512 bytes

I/O size (minimum/optimal): 512 bytes / 512 bytes

Disk /dev/loop0: 50 GiB, 53687091200 bytes, 104857600 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 512 bytes

I/O size (minimum/optimal): 512 bytes / 512 bytes

Disk /dev/nvme0n1: 465.8 GiB, 500107862016 bytes, 976773168 sectors

Disk model: Samsung SSD 970 EVO 500GB

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 512 bytes

I/O size (minimum/optimal): 512 bytes / 512 bytes

Disklabel type: gpt

Disk identifier: 847FEC37-83DC-4E1D-A72D-C577421BE247

Device Start End Sectors Size Type

/dev/nvme0n1p1 34 2047 2014 1007K BIOS boot

/dev/nvme0n1p2 2048 1050623 1048576 512M EFI System

/dev/nvme0n1p3 1050624 976773134 975722511 465.3G Linux LVM

Disk /dev/sda: 238.5 GiB, 256060514304 bytes, 500118192 sectors

Disk model: M4-CT256M4SSD2

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 512 bytes

I/O size (minimum/optimal): 512 bytes / 512 bytes

Disk /dev/sdb: 931.5 GiB, 1000204886016 bytes, 1953525168 sectors

Disk model: TOSHIBA MQ02ABF1

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 4096 bytes

I/O size (minimum/optimal): 4096 bytes / 4096 bytes

Disklabel type: gpt

Disk identifier: 1340AA31-D12B-4660-A7E6-49783817F463

Device Start End Sectors Size Type

/dev/sdb1 2048 1953525134 1953523087 931.5G Linux filesystem

Disk /dev/mapper/pve-swap: 8 GiB, 8589934592 bytes, 16777216 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 512 bytes

I/O size (minimum/optimal): 512 bytes / 512 bytes

Disk /dev/mapper/pve-root: 96 GiB, 103079215104 bytes, 201326592 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 512 bytes

I/O size (minimum/optimal): 512 bytes / 512 bytes

Disk /dev/mapper/pve-vm--103--disk--0: 10 GiB, 10737418240 bytes, 20971520 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 512 bytes

I/O size (minimum/optimal): 65536 bytes / 65536 bytes

Disk /dev/mapper/pve-vm--101--disk--0: 8 GiB, 8589934592 bytes, 16777216 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 512 bytes

I/O size (minimum/optimal): 65536 bytes / 65536 bytes

Disk /dev/mapper/pve-vm--100--disk--0: 8 GiB, 8589934592 bytes, 16777216 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 512 bytes

I/O size (minimum/optimal): 65536 bytes / 65536 bytes

Disk /dev/mapper/pve-vm--104--disk--0: 28 GiB, 30064771072 bytes, 58720256 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 512 bytes

I/O size (minimum/optimal): 65536 bytes / 65536 bytes

Disk /dev/mapper/sdadisk: 238.5 GiB, 256043737088 bytes, 500085424 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 512 bytes

I/O size (minimum/optimal): 512 bytes / 512 bytes

config {

checks=1

abort_on_errors=0

profile_dir="/etc/lvm/profile"

}

local {

}

dmeventd {

mirror_library="libdevmapper-event-lvm2mirror.so"

snapshot_library="libdevmapper-event-lvm2snapshot.so"

thin_library="libdevmapper-event-lvm2thin.so"

}

activation {

checks=0

udev_sync=1

udev_rules=1

verify_udev_operations=0

retry_deactivation=1

missing_stripe_filler="error"

use_linear_target=1

reserved_stack=64

reserved_memory=8192

process_priority=-18

raid_region_size=2048

readahead="auto"

raid_fault_policy="warn"

mirror_image_fault_policy="remove"

mirror_log_fault_policy="allocate"

snapshot_autoextend_threshold=100

snapshot_autoextend_percent=20

thin_pool_autoextend_threshold=100

thin_pool_autoextend_percent=20

vdo_pool_autoextend_threshold=100

use_mlockall=0

monitoring=1

polling_interval=15

activation_mode="degraded"

}

global {

umask=63

test=0

units="r"

si_unit_consistency=1

suffix=1

activation=1

proc="/proc"

etc="/etc"

wait_for_locks=1

locking_dir="/run/lock/lvm"

prioritise_write_locks=1

abort_on_internal_errors=0

metadata_read_only=0

mirror_segtype_default="raid1"

raid10_segtype_default="raid10"

sparse_segtype_default="thin"

event_activation=1

use_lvmlockd=0

system_id_source="none"

use_lvmpolld=1

notify_dbus=1

}

shell {

history_size=100

}

backup {

backup=1

backup_dir="/etc/lvm/backup"

archive=1

archive_dir="/etc/lvm/archive"

retain_min=10

retain_days=30

}

log {

verbose=0

silent=0

syslog=1

overwrite=0

level=0

indent=1

command_names=0

prefix=" "

activation=0

debug_classes=["memory","devices","io","activation","allocation","metadata","cache","locking","lvmpolld","dbus"]

}

allocation {

maximise_cling=1

use_blkid_wiping=1

wipe_signatures_when_zeroing_new_lvs=1

mirror_logs_require_separate_pvs=0

cache_pool_metadata_require_separate_pvs=0

thin_pool_metadata_require_separate_pvs=0

}

devices {

dir="/dev"

scan="/dev"

obtain_device_list_from_udev=1

external_device_info_source="none"

global_filter=["r|/dev/zd.*|","r|/dev/mapper/pve-.*|","r|/dev/sdb*|","r|/dev/mapper/.*-(vm|base)--[0-9]+--disk--[0-9]+|"]

sysfs_scan=1

scan_lvs=1

multipath_component_detection=1

md_component_detection=1

fw_raid_component_detection=0

md_chunk_alignment=1

data_alignment_detection=1

data_alignment=0

data_alignment_offset_detection=1

ignore_suspended_devices=0

ignore_lvm_mirrors=1

require_restorefile_with_uuid=1

pv_min_size=2048

issue_discards=1

allow_changes_with_duplicate_pvs=0

}

checks=1

abort_on_errors=0

profile_dir="/etc/lvm/profile"

}

local {

}

dmeventd {

mirror_library="libdevmapper-event-lvm2mirror.so"

snapshot_library="libdevmapper-event-lvm2snapshot.so"

thin_library="libdevmapper-event-lvm2thin.so"

}

activation {

checks=0

udev_sync=1

udev_rules=1

verify_udev_operations=0

retry_deactivation=1

missing_stripe_filler="error"

use_linear_target=1

reserved_stack=64

reserved_memory=8192

process_priority=-18

raid_region_size=2048

readahead="auto"

raid_fault_policy="warn"

mirror_image_fault_policy="remove"

mirror_log_fault_policy="allocate"

snapshot_autoextend_threshold=100

snapshot_autoextend_percent=20

thin_pool_autoextend_threshold=100

thin_pool_autoextend_percent=20

vdo_pool_autoextend_threshold=100

use_mlockall=0

monitoring=1

polling_interval=15

activation_mode="degraded"

}

global {

umask=63

test=0

units="r"

si_unit_consistency=1

suffix=1

activation=1

proc="/proc"

etc="/etc"

wait_for_locks=1

locking_dir="/run/lock/lvm"

prioritise_write_locks=1

abort_on_internal_errors=0

metadata_read_only=0

mirror_segtype_default="raid1"

raid10_segtype_default="raid10"

sparse_segtype_default="thin"

event_activation=1

use_lvmlockd=0

system_id_source="none"

use_lvmpolld=1

notify_dbus=1

}

shell {

history_size=100

}

backup {

backup=1

backup_dir="/etc/lvm/backup"

archive=1

archive_dir="/etc/lvm/archive"

retain_min=10

retain_days=30

}

log {

verbose=0

silent=0

syslog=1

overwrite=0

level=0

indent=1

command_names=0

prefix=" "

activation=0

debug_classes=["memory","devices","io","activation","allocation","metadata","cache","locking","lvmpolld","dbus"]

}

allocation {

maximise_cling=1

use_blkid_wiping=1

wipe_signatures_when_zeroing_new_lvs=1

mirror_logs_require_separate_pvs=0

cache_pool_metadata_require_separate_pvs=0

thin_pool_metadata_require_separate_pvs=0

}

devices {

dir="/dev"

scan="/dev"

obtain_device_list_from_udev=1

external_device_info_source="none"

global_filter=["r|/dev/zd.*|","r|/dev/mapper/pve-.*|","r|/dev/sdb*|","r|/dev/mapper/.*-(vm|base)--[0-9]+--disk--[0-9]+|"]

sysfs_scan=1

scan_lvs=1

multipath_component_detection=1

md_component_detection=1

fw_raid_component_detection=0

md_chunk_alignment=1

data_alignment_detection=1

data_alignment=0

data_alignment_offset_detection=1

ignore_suspended_devices=0

ignore_lvm_mirrors=1

require_restorefile_with_uuid=1

pv_min_size=2048

issue_discards=1

allow_changes_with_duplicate_pvs=0

}

lvm> lvs

LV VG Attr LSize Pool Origin Data% Meta% Move Log Cpy%Sync Convert

data pve twi-aotz-- <338.36g 9.10 0.89

root pve -wi-ao---- 96.00g

swap pve -wi-ao---- 8.00g

vm-100-disk-0 pve Vwi-aotz-- 8.00g data 67.88

vm-101-disk-0 pve Vwi-a-tz-- 8.00g data 11.75

vm-103-disk-0 pve Vwi-aotz-- 10.00g data 78.88

vm-104-disk-0 pve Vwi-aotz-- 28.00g data 59.07

LV VG Attr LSize Pool Origin Data% Meta% Move Log Cpy%Sync Convert

data pve twi-aotz-- <338.36g 9.10 0.89

root pve -wi-ao---- 96.00g

swap pve -wi-ao---- 8.00g

vm-100-disk-0 pve Vwi-aotz-- 8.00g data 67.88

vm-101-disk-0 pve Vwi-a-tz-- 8.00g data 11.75

vm-103-disk-0 pve Vwi-aotz-- 10.00g data 78.88

vm-104-disk-0 pve Vwi-aotz-- 28.00g data 59.07

du -sh /*

0 /bin

298M /boot

43M /dev

5.0M /etc

1.3M /home

0 /lib

0 /lib32

0 /lib64

0 /libx32

16K /lost+found

4.0K /media

309G /mnt

4.0K /opt

du: cannot access '/proc/8521/task/8521/fd/4': No such file or directory

du: cannot access '/proc/8521/task/8521/fdinfo/4': No such file or directory

du: cannot access '/proc/8521/fd/3': No such file or directory

du: cannot access '/proc/8521/fdinfo/3': No such file or directory

0 /proc

8.3M /root

11M /run

0 /sbin

4.0K /srv

0 /sys

32K /tmp

3.6G /usr

30G /var

0 /bin

298M /boot

43M /dev

5.0M /etc

1.3M /home

0 /lib

0 /lib32

0 /lib64

0 /libx32

16K /lost+found

4.0K /media

309G /mnt

4.0K /opt

du: cannot access '/proc/8521/task/8521/fd/4': No such file or directory

du: cannot access '/proc/8521/task/8521/fdinfo/4': No such file or directory

du: cannot access '/proc/8521/fd/3': No such file or directory

du: cannot access '/proc/8521/fdinfo/3': No such file or directory

0 /proc

8.3M /root

11M /run

0 /sbin

4.0K /srv

0 /sys

32K /tmp

3.6G /usr

30G /var