Hallo zusammen,

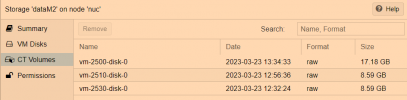

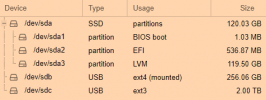

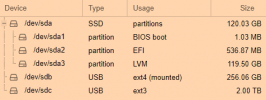

ich bin Proxmox-Anfänger und betreibe Proxmox auf einem Intel NUC. Aktuell ist intern eine SSD verbaut (sda), auf der Proxmox und auch alle VM und CT liegen.

sdb ist eine externe SSD für Backups und sdc ist als Laufwerk für Openmediavault vorgesehen.

Intern ist noch ein M.2 Slot frei, da würde ich gern eine 250 GB nvme ssd m.2 einbauen.

Dahin möchte ich dann alle VM und CT von sda verschieben.

Wie geht man da vor?

M2 einbauen - und dann?

Vielen Dank

Selter

ich bin Proxmox-Anfänger und betreibe Proxmox auf einem Intel NUC. Aktuell ist intern eine SSD verbaut (sda), auf der Proxmox und auch alle VM und CT liegen.

sdb ist eine externe SSD für Backups und sdc ist als Laufwerk für Openmediavault vorgesehen.

Intern ist noch ein M.2 Slot frei, da würde ich gern eine 250 GB nvme ssd m.2 einbauen.

Dahin möchte ich dann alle VM und CT von sda verschieben.

Wie geht man da vor?

M2 einbauen - und dann?

Vielen Dank

Selter