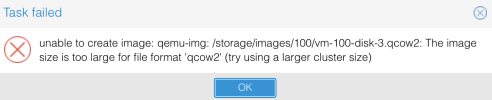

Hi, ich will einfach nur eine qcow2 jenseits der 20 TB erstellen, aber irgendwann gibt es den Fehler siehe Screenshot. Wenn ich eine 10TB erstelle und die nach und nach vergrößere so, dass ich auf z. B. 30 TB komme, hört die VM trotzdem irgendwann auf zu arbeiten: close device failed: Input/output error

Das Storage - normales Raid5 - arbeitet trotzdem klaglos

Was ist hier falsch?

Grüße Michael

Das Storage - normales Raid5 - arbeitet trotzdem klaglos

Was ist hier falsch?

Grüße Michael