Hallo zusammen,

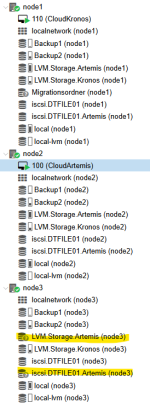

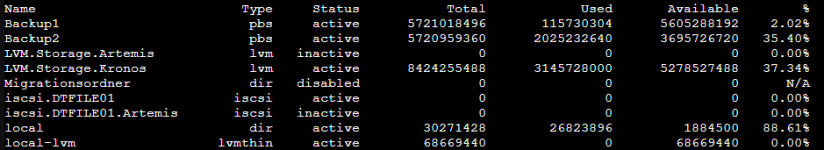

wir wollen von ESXi auf Proxmox wechseln und sind gerade am ausloten mit der vorhergehenden Serverhardware(2x Dell Poweredge R630)

Da auf der ME5 genügend Anschlüße vorhanden sind haben wir die 2 alten Server auch direkt an die SAN gehängt.

Verkabelung redundant pro Server je ein Kabel auf Controller A und B. wie lt. Doku von Dell.

Verbunden mit 25 Gb/s lt. ME5 und ethtool auf Proxmox

An der Proxmox-Installation habe ich noch nichts gemacht, keine Konfigs geändert oder dergleichen.

Habe nur die IP Adressen bei den NICs eingetragen die die Gegenstücke zur ME5 bieten.

Auszug aus Interfaces

Wenn ich nun das Target verbinden will scheint es sofort im Auswahlfenster auf. Aber sobald ich es anwähle und auf okey gehe läuft das Rad und er geht in einen Connection Error.

Auf der ME5 schlägt der Proxmox mit seiner Initator ID auf aber selbst wenn ich die Verbindung nochmal aufbauen will kommt nur Connection Error.

Proxmox legt zwar die Verbindung an, ich bekomme aber nur in 1 von 10 Fällen vielleicht eine LUN präsentiert.

Meist einfach nur Connection Error.

Ping geht ohne Probleme.

traceroute schlägt fehl und traceroute auf tcp bringt hohe Latenz.

Das Problem besteht auf beiden Servern!

Einmal ist eine Broadcom BCM57414 10/25 GB verbaut

und beim 2ten Server ein Intel XX710-DA2

fw info folgt.

Die in Produktiven Betrieb befindlichen Server mit BCM57414 Karte und ESXi haben weder bei Traceroute noch bei Ping Probleme.

Leider finde ich nirgends was passendes im Web... ich hoffe hier kann man mir helfen!

Edit: Auszug Interfaces richtig gestellt.

wir wollen von ESXi auf Proxmox wechseln und sind gerade am ausloten mit der vorhergehenden Serverhardware(2x Dell Poweredge R630)

Da auf der ME5 genügend Anschlüße vorhanden sind haben wir die 2 alten Server auch direkt an die SAN gehängt.

Verkabelung redundant pro Server je ein Kabel auf Controller A und B. wie lt. Doku von Dell.

Verbunden mit 25 Gb/s lt. ME5 und ethtool auf Proxmox

An der Proxmox-Installation habe ich noch nichts gemacht, keine Konfigs geändert oder dergleichen.

Habe nur die IP Adressen bei den NICs eingetragen die die Gegenstücke zur ME5 bieten.

Auszug aus Interfaces

Code:

auto enp129s0f0np0

iface enp129s0f0np0 inet static

address 10.10.30.110/24

mtu 9000

#iSCSI A

auto enp129s0f1np1

iface enp129s0f1np1 inet static

address 10.10.31.110/24

mtu 9000

#iSCSI BWenn ich nun das Target verbinden will scheint es sofort im Auswahlfenster auf. Aber sobald ich es anwähle und auf okey gehe läuft das Rad und er geht in einen Connection Error.

Auf der ME5 schlägt der Proxmox mit seiner Initator ID auf aber selbst wenn ich die Verbindung nochmal aufbauen will kommt nur Connection Error.

Proxmox legt zwar die Verbindung an, ich bekomme aber nur in 1 von 10 Fällen vielleicht eine LUN präsentiert.

Meist einfach nur Connection Error.

Ping geht ohne Probleme.

traceroute schlägt fehl und traceroute auf tcp bringt hohe Latenz.

Code:

root@PROX01:~# traceroute -T -p 3260 10.10.30.100

traceroute to 10.10.30.100 (10.10.30.100), 30 hops max, 60 byte packets

1 10.10.30.100 (10.10.30.100) 5.606 ms 5.859 ms *

root@PROX01:~# traceroute -T -p 3260 10.10.30.100

traceroute to 10.10.30.100 (10.10.30.100), 30 hops max, 60 byte packets

1 10.10.30.100 (10.10.30.100) 5.168 ms 5.488 ms *

root@PROX01:~# ping 10.10.30.100

PING 10.10.30.100 (10.10.30.100) 56(84) bytes of data.

64 bytes from 10.10.30.100: icmp_seq=1 ttl=64 time=0.147 ms

64 bytes from 10.10.30.100: icmp_seq=2 ttl=64 time=0.055 ms

64 bytes from 10.10.30.100: icmp_seq=3 ttl=64 time=0.071 ms

64 bytes from 10.10.30.100: icmp_seq=4 ttl=64 time=0.051 ms

64 bytes from 10.10.30.100: icmp_seq=5 ttl=64 time=0.087 msDas Problem besteht auf beiden Servern!

Einmal ist eine Broadcom BCM57414 10/25 GB verbaut

Code:

root@PROX02:~# ethtool -i enp129s0f0np0

driver: bnxt_en

version: 6.8.12-4-pve

firmware-version: 220.0.59.0/pkg 22.00.08.30

expansion-rom-version:

bus-info: 0000:81:00.0

supports-statistics: yes

supports-test: yes

supports-eeprom-access: yes

supports-register-dump: yes

supports-priv-flags: nound beim 2ten Server ein Intel XX710-DA2

fw info folgt.

Die in Produktiven Betrieb befindlichen Server mit BCM57414 Karte und ESXi haben weder bei Traceroute noch bei Ping Probleme.

Leider finde ich nirgends was passendes im Web... ich hoffe hier kann man mir helfen!

Edit: Auszug Interfaces richtig gestellt.

Last edited: