Moin,

ich komme immer wieder auf diese Frage und daher wollte ich sie jetzt hier einfach mal stellen.

Aktueller Stand:

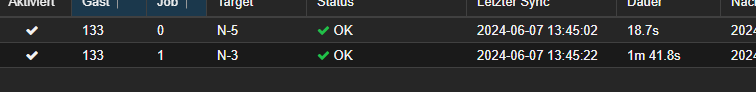

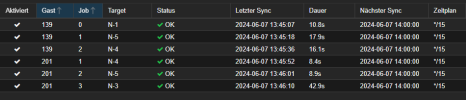

Ich habe 5 Proxmox Nodes mit jeweils einer 2 TB NVMe SSD, wo aktuell ein ZFS drauf liegt und die Nodes replizieren sich untereinander (jede VM hat 2 Replizierungs Targets) alle 15 Minuten die VMs.

1 Gigabit Netzwerk zwsichen den Nodes

Zwecks Automatisierungen werden gelegentlich Nodes heruntergefahren/neugestartet für Updates oder Wartungen.

Das läuft an sich Ok, nur dauert das manchmal schon etwas, bis alles migriert ist, sollte ich mal einen Node herunterfahren müssen.

Nun kam mir der Gedanke, mit einem sich im Netzwerk befindlichen NFS Share müsste ich nicht replizieren, verliere dadurch aber Redundanz. Auch müsste ich dann ein zusätzliches Gerät dauerhaft mitlaufen lassen, was wieder Strom kostet.

Dadurch kam mir dann Ceph generell erstmal als eine Lösung beider Themen vor. Nur lese ich hier immer, dass ich dafür relativ viel Netzwerk und Schreibleistung brauche. Ich möchte ich meine SSDs langfristig nicht schneller killen als nötig und mir auch nicht mehr Probleme machen als aktuell schon, daher wollte ich einfach mal fragen:

Macht Ceph hier Sinn? Wenn nicht, was dann?

LG

ich komme immer wieder auf diese Frage und daher wollte ich sie jetzt hier einfach mal stellen.

Aktueller Stand:

Ich habe 5 Proxmox Nodes mit jeweils einer 2 TB NVMe SSD, wo aktuell ein ZFS drauf liegt und die Nodes replizieren sich untereinander (jede VM hat 2 Replizierungs Targets) alle 15 Minuten die VMs.

1 Gigabit Netzwerk zwsichen den Nodes

Zwecks Automatisierungen werden gelegentlich Nodes heruntergefahren/neugestartet für Updates oder Wartungen.

Das läuft an sich Ok, nur dauert das manchmal schon etwas, bis alles migriert ist, sollte ich mal einen Node herunterfahren müssen.

Nun kam mir der Gedanke, mit einem sich im Netzwerk befindlichen NFS Share müsste ich nicht replizieren, verliere dadurch aber Redundanz. Auch müsste ich dann ein zusätzliches Gerät dauerhaft mitlaufen lassen, was wieder Strom kostet.

Dadurch kam mir dann Ceph generell erstmal als eine Lösung beider Themen vor. Nur lese ich hier immer, dass ich dafür relativ viel Netzwerk und Schreibleistung brauche. Ich möchte ich meine SSDs langfristig nicht schneller killen als nötig und mir auch nicht mehr Probleme machen als aktuell schon, daher wollte ich einfach mal fragen:

Macht Ceph hier Sinn? Wenn nicht, was dann?

LG