Hallo,

wegen Ausfall eines PCs und der Problematik, dass man immer mehr zu sinnlosen Updates gezwungen wird, wo hinterher weniger funktioniert wie vorher, möchte ich es endlich in Angriff nehmen fast komplett auf Proxmox umzusteigen, so dass ich bei Updates leichter experimentieren kann und bei Hardwaredefekt nur Proxmox installieren muss, statt dutzende Programme. Aktuell habe ich Proxmox nur auf meinem Laptop und das als Produktivsystem, weswegen Experimente aktuell nicht drin sind. Das möchte ich ändern und frage daher nach ein paar Anregungen, wie ich mein Homelab richtig aufbaue.

Verwendungszweck

- Office

- Mikrocontrollerprogrammierung (STM32 mit CubeMX, Eclipse, Putty, ...)

- Multimedia (Youtube in FullHD)

- Gaming (10 Jahre alte Spiele, brauche also nicht die Beste Leistung. Aktuell Skyrim und Dirt4.0. Aber NVIDIA Surround mit 3+1 Monitoren, G25 Lenkrad und diversen Joysticks und Gamepads. Viel über Steam.)

- Teamviewer (beide Richtungen)

- NAS (Fotos, Dokumente, ...)

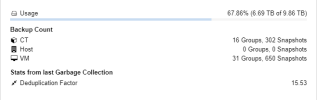

- Backup NAS + VMs + Promox Hosts

- Experimente mit neuer Software, Programmen, ... ohne Angst haben zu müssen schon wieder mein Produktivsystem zu zerschießen

Ausgangssituation

Mein Laptop ist der zentrale Punkt, weil ich meine Daten nicht auf eine Cloud legen möchte, aber dennoch von Unterwegs drauf zugreifen möchte läuft eine VM mit Openmediavault. Das soll auch so bleiben. Die Daten des NAS werden auf einen separaten Einplatinenrechner mit Openmediavault Backup NAS gesichert. Aktuell nur Inkrementell. Mit Journal hatte ich mal experimentiert. Das Backup NAS ist vom Strom und Netzwerk getrennt, wenn ich keine Sicherung mache.

Ich habe bereits 2 physisch getrennte 1 GBit/s Netzwerke laufen. Das eine ist Internet, wo auch wirklich nur der Internetverkehr drüber läuft. Die Organisation macht der Internet Router. Das andere ist das interne Netzwerk. Das NAS und ein paar Elektronikgeräte hängen im internen Netzwerk, alle PCs in beiden. Der Laptop ist so eingerichtet, dass er bei Bedarf als Gateway und DHCP Server für das interne Netz arbeiten kann. Z.B. um Unterwegs einem anderen Laptop über Smartphone Internet zu geben.

Laptop

Nutzungskonzept

Laptop mit Proxmox, NAS in der VM und Backup NAS läuft für mich super und bleibt so.

Werde ich schon für Proxmox auf dem Laptop belächelt, wird es jetzt abstrus. Eigentlich hätte ich gern, dass nicht in Computern gedacht wird (meine Tastatur, meine Daten, meine Anwendung, mein Monitor), sondern, dass nur noch entscheidend ist auf welchem Monitor welche Anwendung läuft. Egal welcher PC und wo das im Hintergrund läuft. Und das ohne HA Cluster oder ähnliches. Gut Wunschdenken, aber ich hoffe man versteht mein Konzept.

Praktische Umsetzung wird eher in die Richtung

Speicher- und Backupkonzept

Ich habe bereits einiges recherchiert, aber die Möglichkeiten und Stolperfallen sind einfach zu vielfältig.

Ich würde gern ZFS mit RAID1 gegen Rotten Bit einsetzen. Zumindest bei den PCs wo es möglich und sinnvoll ist.

Laut diesen Tests bringt RAID 1 mit LZ4 Komprimierung mehr Lesegeschwindigkeit. https://calomel.org/zfs_raid_speed_capacity.html

Ob Enterprise SSDs notwendig sind, darüber wird gestritten, wie hier https://blog.erben.sk/2022/03/08/do-not-use-consumer-ssd-with-zfs-for-virtualization/

ich würde versuchen auf gebrauchte Enterprise SSDs zu gehen, aber wenn ich die vorhandenen Laufwerke nutzen könnte (gerade die 2 TB Festplatten), dann wäre das auch nicht schlecht.

Laptop

Auf dem Laptop habe ich Proxmox mit ext4 installiert. ZFS wäre zwar sinnvoll für das NAS in der VM wegen Datenintegrität, aber weil der RAM mit 8 GB eh oft schon knapp ist mit den VMs macht das keinen Sinn. Eine Zweite SSD einbauen wäre nur mit basteln über USB2.0 möglich oder eine µSD Karte. Ich müsste mich hier darauf verlassen, dass ich durch Journal + inkrementelles Backup entsprechend weit zurück gehen kann, um meine Daten wieder herzustellen. Beim NAS kein Problem, weil ich nur einzelne Dateien zurückholen muss. Beim Host und VMs stelle ich es mir schwierig vor, wenn irgendwo ein Rotten Bit ist und ich aus zwei Backupversionen eine machen muss.

Workstation1

Sollten diese mit ZFS oder anderem Dateisystem formatiert werden? Ich habe verschiedene Aussagen dazu gelesen.

RAID1 oder nicht?

Genügt ein PC mit Singlecore und 2 GB DDR1 für Homelab Anforderungen? Laut Systemanforderungen ist das knapp unter den Mindestanforderungen.

Backup

Beim Proxmox Backup Server weiß ich noch gar nicht so richtig. Viele installieren diesen als VM auf den Proxmox Servern. Dann würden die Festplatten permanent laufen. Bei SAS Platten doch etwas nervend. Mir wäre es lieber, wenn die Workstations/PCs lokal das Backup auf die SSDs machen. Fullbackup manuell, bevor oder nachdem ich Änderungen vornehme und Snapshot automatisch täglich (zumindest wenn der PC läuft. Sobald PC und PBS laufen, wird das lokale Backup übertragen, egal ob Fullbackup oder Snapshot. Dadurch müsste übers Netzwerk nur übertragen werden, was neu ist und die Festplatten laufen nicht unnötig die ganze Zeit. Kann man sicher etwas mit Script machen.

Evtl. möchte ich bei 3 Verwandten externe Instanzen einrichten, damit diese auf meinen Backupserver und ich auf deren Backupserver sichern kann. Alles zusammen schätze ich aktuelle 0,5 bis 3 TB für VMs und Daten. Datenzuwachs pro Jahr vielleicht 20 GB, hauptsächlich durch Fotos und Dokumente. Fullbackups würde ich per externer HDD übertragen und nur die Inkrementellen Backups per Internet. Aber wie kann man bei den Backups differenzieren, weil die PCs/Workstation Inkrementellen Backups (Snapshots) beziehen sich auf den letzten Fullbackup und Fullbackup per 1 MBit/s Upload übertragen ...?

Alternativ 4 Minibackupserver aus alter Hardware und gebrauchten Enterprise HDDs, die beim nächsten Besuch spätestens alle 6 Monate untereinander getauscht werden. Sobald der PBS im Netzwerk ist, werden vom Client alle Backups synchronisiert, die noch nicht auf dem PBS sind. Bzw. per externer Festplatte, aber da ist wieder die Frage wie stark sich Rotten Bits auswirken. Irgendwo soll es auch bezahlbar bleiben.

Es geht hier erst mal nur ums Konzept, damit ich mich nicht irgendwo verrenne, was sowieso nicht funktioniert. Bei konkreten Problemen würde ich ein extra Thema aufmachen, wenn ich nicht weiter komme. Die Enterprise SSDs/HDDs müssen auch noch gekauft werden. Für andere Vorschläge bin ich offen. Im Anhang ist auch noch ein Schema. Im Voraus schon mal Danke.

wegen Ausfall eines PCs und der Problematik, dass man immer mehr zu sinnlosen Updates gezwungen wird, wo hinterher weniger funktioniert wie vorher, möchte ich es endlich in Angriff nehmen fast komplett auf Proxmox umzusteigen, so dass ich bei Updates leichter experimentieren kann und bei Hardwaredefekt nur Proxmox installieren muss, statt dutzende Programme. Aktuell habe ich Proxmox nur auf meinem Laptop und das als Produktivsystem, weswegen Experimente aktuell nicht drin sind. Das möchte ich ändern und frage daher nach ein paar Anregungen, wie ich mein Homelab richtig aufbaue.

Verwendungszweck

- Office

- Mikrocontrollerprogrammierung (STM32 mit CubeMX, Eclipse, Putty, ...)

- Multimedia (Youtube in FullHD)

- Gaming (10 Jahre alte Spiele, brauche also nicht die Beste Leistung. Aktuell Skyrim und Dirt4.0. Aber NVIDIA Surround mit 3+1 Monitoren, G25 Lenkrad und diversen Joysticks und Gamepads. Viel über Steam.)

- Teamviewer (beide Richtungen)

- NAS (Fotos, Dokumente, ...)

- Backup NAS + VMs + Promox Hosts

- Experimente mit neuer Software, Programmen, ... ohne Angst haben zu müssen schon wieder mein Produktivsystem zu zerschießen

Ausgangssituation

Mein Laptop ist der zentrale Punkt, weil ich meine Daten nicht auf eine Cloud legen möchte, aber dennoch von Unterwegs drauf zugreifen möchte läuft eine VM mit Openmediavault. Das soll auch so bleiben. Die Daten des NAS werden auf einen separaten Einplatinenrechner mit Openmediavault Backup NAS gesichert. Aktuell nur Inkrementell. Mit Journal hatte ich mal experimentiert. Das Backup NAS ist vom Strom und Netzwerk getrennt, wenn ich keine Sicherung mache.

Ich habe bereits 2 physisch getrennte 1 GBit/s Netzwerke laufen. Das eine ist Internet, wo auch wirklich nur der Internetverkehr drüber läuft. Die Organisation macht der Internet Router. Das andere ist das interne Netzwerk. Das NAS und ein paar Elektronikgeräte hängen im internen Netzwerk, alle PCs in beiden. Der Laptop ist so eingerichtet, dass er bei Bedarf als Gateway und DHCP Server für das interne Netz arbeiten kann. Z.B. um Unterwegs einem anderen Laptop über Smartphone Internet zu geben.

Laptop

- Panasonic Toughbook CF-20, Dualcore (Core m5-6Y57), 8 GB RAM, 1 TB SATA SSD

- Proxmox

- VM Openmediavault NAS

- Office und Multimedia direkt auf dem Host

- und ein paar anderen VMs die gelegentlich genutzt werden

- Odroid HC1, Octacore ARM, 2 GB RAM, 1 TB SATA SSD (Crucial MX500)

- Openmediavault

- Tyan S2915-E, 2x Sixcore (Opteron 8439 SE), 64 GB RAM, GTX960

- 6x SATA2, 8x SAS1, PCIe1 2x16, 2x8

- Aktuell Windows 7 Programmierung und Gaming

- Kein PCIe Passtrough, daher nicht geeignet für Gaming VM, daher ist auf dem weg:

- HP Z840, 2x Octacore (Xeon E5-2667-v4), 128 GB RAM, RTX2080

- 6x SATA3, 8x SAS2, PCIe3 3x16, 2x8, 1x4, 1x1

- NVMe Boot, aber kein M.2 oder U.2 Slot

- Intel DQ35JO, Quadcore (C2Q Q9xxx), 8 GB RAM, GTX260

- Aktuell Windows 7 Programmierung und Gaming

- Defekt, vermutlich Kondensator auf Mainboard, werde ich bei Gelegenheit reparieren bzw. habe ich noch 2 Stk. K9N Neo MSI-7260 oder 1 Stk. GA-G31M-ES2L (nur 4 GB RAM)

- 6x SATA2 und PCIe2 x16

- K9N Neo MSI-7260, Dualcore (A64x2 AM2 3800+), kein RAM

- Habe leider keinen RAM und 25 € für 8 GB DDR2 ausgeben, wenn es bei Ebay Sets mit i5 und 16 GB DDR3 für 40 € gibt, weiß nicht

- 4x SATA1 und PCIe1 x16

- GA-8S649MF, Singlecore (P4 Presscott 3,6 Ghz), 2 GB RAM (max)

- PC ist fertig montiert und hat genug Platz für 10 bis 16 Stk. 3,5" Festplatten

- Leider auf 2 GB RAM beschränkt

- 4x SATA1 und PCIe1 x16

- Odroid XU4, Octacore ARM, 2 GB RAM, 64 GB EMMC

- 2x 1 TB SATA (Crucial MX500)

- 1x 500 GB SATA (Crucial MX300)

- 1x 240 GB SATA (Crucial BX500)

- 1x 256 GB SATA (Crucial BX100)

- 1x 256 GB SATA M.2 (Samsung MZNLN256HCHP)

- 2x 2 TB SATA HDD (Seagate SV35)

- 1x 2 TB SATA HDD (Seagate ST2000)

- 1x 500 GB HDD (Hitachi HD725050GLA)

- Diverse 80 bis 320 GB SATA HDDs in 2,5" und 3,5"

- TP-Link TL-SG116, 16x 1GBit/s für internes Netzwerk

- TP-Link TL-SG108, 8x 1GBit/s für internes Netzwerk

- Haufenweise ältere Hardware, die nicht in Frage kommt, also nicht wundern, wenn im Laufe des Themas plötzlich Hardware auftaucht ;-)

Nutzungskonzept

Laptop mit Proxmox, NAS in der VM und Backup NAS läuft für mich super und bleibt so.

Werde ich schon für Proxmox auf dem Laptop belächelt, wird es jetzt abstrus. Eigentlich hätte ich gern, dass nicht in Computern gedacht wird (meine Tastatur, meine Daten, meine Anwendung, mein Monitor), sondern, dass nur noch entscheidend ist auf welchem Monitor welche Anwendung läuft. Egal welcher PC und wo das im Hintergrund läuft. Und das ohne HA Cluster oder ähnliches. Gut Wunschdenken, aber ich hoffe man versteht mein Konzept.

Praktische Umsetzung wird eher in die Richtung

- Daten liegen weiterhin auf dem Laptop, damit ich unterwegs und von jedem PC drauf zugreifen kann. Für die Programmierung kopiere ich zur Zeit händisch, weil Eclipse keine Netzwerkspeicher zulässt. Git habe ich hin und wieder benutzt. Vermutlich werde ich es darüber lösen.

- VMs liegen auf den jeweiligen Proxmox

ServernWorkstations/PCs, weil der Aufwand für zentralen Speicher zu hoch wird- Redundanz, damit die andere Workstation bzw. PCs weiter funktionieren bei Hardwaredefekt

- Laptop ist auf 1 GBit/s begrenzt und für alle PCs schnellere Netzwerkkarten und neuer Switch wird einfach zu teuer

- Letzten Endes wäre es für die beiden Workstations und damit kein Verhältnis Aufwand zu Nutzen. ich bin jedoch nicht abgeneigt die beiden Workstations per gebrauchten Infinibandkarten zu verbinden und damit etwas zu experimentieren.

- Jeder der Proxmox Rechner (außer Laptop wegen Geschwindigkeit und Workstation1 wegen fehlendem PCIe Passtrough) bekommt eine VM, wo die Grafikkarte durchgereicht wird und Monitore direkt angeschlossen werden. Das wird vermutlich die Gaming VM mit Steam OS oder Debian mit Proton werden, weil dort die GPU Beschleunigung gebraucht wird. Von dort aus kann ich per Spice auf die anderen VMs, wie z.B. Programmierung zugreifen, welche nur einen flüssigen Desktop benötigen, aber keine GPU Beschleunigung. Im Zweifel kommt in die Workstation2 für diesen Zweck eine alte Grafikkarte, wie GT 710 oder 7100 GS. Was ich nicht möchte, ist auf dem einen Monitor Gaming und auf dem anderen Programmierung. Alle sollen für alles herhalten und trotzdem getrennte VMs, um die Software zu isolieren.

- Beamer und Fernseher bekommen Ultralowpower PCs. Odroid XU4, Raspberry 4, oder ähnliches. Diese können sich per Spice auf jede VM oder per Moonlight/Sunshine auf die VM mit Grafikkarte schalten. Dadurch kann ich zumindest diese beiden Monitore nutzen, um möglichst einfach auf jede VM und performant auf die Gaming VM zugreifen zu können.

Speicher- und Backupkonzept

Ich habe bereits einiges recherchiert, aber die Möglichkeiten und Stolperfallen sind einfach zu vielfältig.

Ich würde gern ZFS mit RAID1 gegen Rotten Bit einsetzen. Zumindest bei den PCs wo es möglich und sinnvoll ist.

Laut diesen Tests bringt RAID 1 mit LZ4 Komprimierung mehr Lesegeschwindigkeit. https://calomel.org/zfs_raid_speed_capacity.html

Ob Enterprise SSDs notwendig sind, darüber wird gestritten, wie hier https://blog.erben.sk/2022/03/08/do-not-use-consumer-ssd-with-zfs-for-virtualization/

ich würde versuchen auf gebrauchte Enterprise SSDs zu gehen, aber wenn ich die vorhandenen Laufwerke nutzen könnte (gerade die 2 TB Festplatten), dann wäre das auch nicht schlecht.

Laptop

Auf dem Laptop habe ich Proxmox mit ext4 installiert. ZFS wäre zwar sinnvoll für das NAS in der VM wegen Datenintegrität, aber weil der RAM mit 8 GB eh oft schon knapp ist mit den VMs macht das keinen Sinn. Eine Zweite SSD einbauen wäre nur mit basteln über USB2.0 möglich oder eine µSD Karte. Ich müsste mich hier darauf verlassen, dass ich durch Journal + inkrementelles Backup entsprechend weit zurück gehen kann, um meine Daten wieder herzustellen. Beim NAS kein Problem, weil ich nur einzelne Dateien zurückholen muss. Beim Host und VMs stelle ich es mir schwierig vor, wenn irgendwo ein Rotten Bit ist und ich aus zwei Backupversionen eine machen muss.

Workstation1

- Durch fehlendes Bifurcation und fehlendes NVMe Boot wäre der Aufwand für NVMe SSD zu hoch.

- Host + VMs

- gebrauchte 2x 480 GB Samsung PM863 Enterprise SSD SATA3

- ZFS RAID1, ohne Deduplikation, mit LZ4

- evtl. Backup

- SAS Controller auf Mainboard

- Delock 90092 PCIe x16 zu 4x U.2 https://www.delock.de/produkt/90092/merkmale.html

- Host + VMs

- gebrauchte 2x 2 TB PM983 oder2x 2TB Intel P4510 (was ist besser?) Enterprise NVMe im U.2 Format

- ZFS RAID1, ohne Deduplikation, mit LZ4

- Gaming VM

- System: auf Proxmox Pool wie die anderen VMs, wegen Backup

- Spiele: vorhandene 1 TB SSD durchreichen ohne Backup

- evtl. Backup

- SAS Controller auf Mainboard

- Host + VMs

- vorhandene Consumer SSDs SATA

- vorhandene 3x 2 TB Consumer HDD SATA oder SAS HBA mit 3x 3 bis 12 TB gebrauchte Enterprise SAS HDD

Sollten diese mit ZFS oder anderem Dateisystem formatiert werden? Ich habe verschiedene Aussagen dazu gelesen.

RAID1 oder nicht?

Genügt ein PC mit Singlecore und 2 GB DDR1 für Homelab Anforderungen? Laut Systemanforderungen ist das knapp unter den Mindestanforderungen.

Backup

Beim Proxmox Backup Server weiß ich noch gar nicht so richtig. Viele installieren diesen als VM auf den Proxmox Servern. Dann würden die Festplatten permanent laufen. Bei SAS Platten doch etwas nervend. Mir wäre es lieber, wenn die Workstations/PCs lokal das Backup auf die SSDs machen. Fullbackup manuell, bevor oder nachdem ich Änderungen vornehme und Snapshot automatisch täglich (zumindest wenn der PC läuft. Sobald PC und PBS laufen, wird das lokale Backup übertragen, egal ob Fullbackup oder Snapshot. Dadurch müsste übers Netzwerk nur übertragen werden, was neu ist und die Festplatten laufen nicht unnötig die ganze Zeit. Kann man sicher etwas mit Script machen.

Evtl. möchte ich bei 3 Verwandten externe Instanzen einrichten, damit diese auf meinen Backupserver und ich auf deren Backupserver sichern kann. Alles zusammen schätze ich aktuelle 0,5 bis 3 TB für VMs und Daten. Datenzuwachs pro Jahr vielleicht 20 GB, hauptsächlich durch Fotos und Dokumente. Fullbackups würde ich per externer HDD übertragen und nur die Inkrementellen Backups per Internet. Aber wie kann man bei den Backups differenzieren, weil die PCs/Workstation Inkrementellen Backups (Snapshots) beziehen sich auf den letzten Fullbackup und Fullbackup per 1 MBit/s Upload übertragen ...?

Alternativ 4 Minibackupserver aus alter Hardware und gebrauchten Enterprise HDDs, die beim nächsten Besuch spätestens alle 6 Monate untereinander getauscht werden. Sobald der PBS im Netzwerk ist, werden vom Client alle Backups synchronisiert, die noch nicht auf dem PBS sind. Bzw. per externer Festplatte, aber da ist wieder die Frage wie stark sich Rotten Bits auswirken. Irgendwo soll es auch bezahlbar bleiben.

Es geht hier erst mal nur ums Konzept, damit ich mich nicht irgendwo verrenne, was sowieso nicht funktioniert. Bei konkreten Problemen würde ich ein extra Thema aufmachen, wenn ich nicht weiter komme. Die Enterprise SSDs/HDDs müssen auch noch gekauft werden. Für andere Vorschläge bin ich offen. Im Anhang ist auch noch ein Schema. Im Voraus schon mal Danke.