Moin zusammen,

ich habe ein seltsames Phänomen mit meinen proxmox hosts.

Beide Hosts im Cluster haben jeweils lokalen ZFS Storage mit 10 SATA Intel Enterprise SSDs im ZFS Raid-Z2 bzw. Raid-Z1.

Beide proxmox sind jeweils mit 2x10GBit/s LACP am Switch angebunden, zusätzlich haben die beiden Hosts noch 2x10GBit/s dedizierte Netzwerkkarten für die Replikation.

Perfomance ist soweit auch alles im grünen Bereich, außer ich kopiere große Dateien innerhalb der VMs oder zwischen den beiden Hosts.

Dann springt das I/O delay auf 40-50-60% hoch und einzelne VMs fangen an Netzwerkverbindungen zu trennen oder sich komplett aufzuhängen.

Also es geht dann schon Richtung freezen der hosts, auch das WebUI reagiert dann sehr verzögert, jetzt hatte ich heute die ersten beschädigten User Profile Disks unserer RDS Farm, die ich aus dem Backup zurückspielen musste. Beim Zurückkopieren der UPDs aus dem Backup fliegen dann ständig andere User raus, wir sprechen hier von Kopiervorgängen mit 20-30GB großen UPD VHDX Files, das kann doch nicht sein, dass sowas den kompletten Server crasht.

=> Was mir in dem Zusammenhang aufgefallen ist - kopiere ich große Files "von außerhalb", also nicht innerhalb einer VM auf den hosts oder zwischen den beiden proxmox, sondern z.B. per SFTP auf die ZFS pools, dann tritt das nicht auf. Also ich kann da ~500GB VHDX rüber kopieren, laufen durchgehend nahe am 10Gbit/s Netzwerklimit, I/O delay bleibt bei unter 1% und keine VMs werden abgeschossen.

Ich bin jetzt recht frisch bei pve dabei, so eigentlich echt begeistert und zufrieden, aber das Problem muss ich irgendwie identifizieren und lösen. Ich kann so nicht mal eine Live-Migration zwischen den beiden hosts für Wartungsarbeiten durchführen, weil es mir dann reihenweise unsere User aus dem System wirft.

Wo kann ich anfangen mit der Fehlersuche? Über Tipps wäre ich sehr dankbar. Sagt mir welche Infos ich für die Fehlersuche mitteilen müsste, dann sammle ich diese.

Edit:

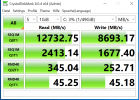

Das sieht alles nach sehr geringen Werte aus? Die SSDs hängen an einem Adaptec SmartRaid Controller, der im HBA Modus läuft (das kann der out of the box, habe nicht irgendwie eine spezielle fw geflasht o.ä., neueste oirignal fw habe ich allerdings eingespielt).

ich habe ein seltsames Phänomen mit meinen proxmox hosts.

Beide Hosts im Cluster haben jeweils lokalen ZFS Storage mit 10 SATA Intel Enterprise SSDs im ZFS Raid-Z2 bzw. Raid-Z1.

Beide proxmox sind jeweils mit 2x10GBit/s LACP am Switch angebunden, zusätzlich haben die beiden Hosts noch 2x10GBit/s dedizierte Netzwerkkarten für die Replikation.

Perfomance ist soweit auch alles im grünen Bereich, außer ich kopiere große Dateien innerhalb der VMs oder zwischen den beiden Hosts.

Dann springt das I/O delay auf 40-50-60% hoch und einzelne VMs fangen an Netzwerkverbindungen zu trennen oder sich komplett aufzuhängen.

Also es geht dann schon Richtung freezen der hosts, auch das WebUI reagiert dann sehr verzögert, jetzt hatte ich heute die ersten beschädigten User Profile Disks unserer RDS Farm, die ich aus dem Backup zurückspielen musste. Beim Zurückkopieren der UPDs aus dem Backup fliegen dann ständig andere User raus, wir sprechen hier von Kopiervorgängen mit 20-30GB großen UPD VHDX Files, das kann doch nicht sein, dass sowas den kompletten Server crasht.

=> Was mir in dem Zusammenhang aufgefallen ist - kopiere ich große Files "von außerhalb", also nicht innerhalb einer VM auf den hosts oder zwischen den beiden proxmox, sondern z.B. per SFTP auf die ZFS pools, dann tritt das nicht auf. Also ich kann da ~500GB VHDX rüber kopieren, laufen durchgehend nahe am 10Gbit/s Netzwerklimit, I/O delay bleibt bei unter 1% und keine VMs werden abgeschossen.

Ich bin jetzt recht frisch bei pve dabei, so eigentlich echt begeistert und zufrieden, aber das Problem muss ich irgendwie identifizieren und lösen. Ich kann so nicht mal eine Live-Migration zwischen den beiden hosts für Wartungsarbeiten durchführen, weil es mir dann reihenweise unsere User aus dem System wirft.

Wo kann ich anfangen mit der Fehlersuche? Über Tipps wäre ich sehr dankbar. Sagt mir welche Infos ich für die Fehlersuche mitteilen müsste, dann sammle ich diese.

Edit:

Code:

zpool iostat -v

capacity operations bandwidth

pool alloc free read write read write

------------------------------------------------ ----- ----- ----- ----- ----- -----

raid-z2 1.79T 6.93T 1.39K 3.18K 8.51M 44.7M

raidz1-0 1.79T 6.93T 1.39K 3.18K 8.51M 44.7M

ata-INTEL_SSDSC2KG960G8_PHYG1085058S960CGN - - 156 326 954K 4.50M

ata-INTEL_SSDSC2KG960G8_PHYG108500YN960CGN - - 129 325 788K 4.43M

ata-INTEL_SSDSC2KG960G8_PHYG1085010A960CGN - - 156 326 954K 4.50M

ata-INTEL_SSDSC2KG960G8_PHYG108504PT960CGN - - 129 325 788K 4.43M

ata-INTEL_SSDSC2KG960G8_PHYG1085047F960CGN - - 156 326 954K 4.50M

ata-INTEL_SSDSC2KG960G8_BTYG12710CPU960CGN - - 129 325 788K 4.43M

ata-INTEL_SSDSC2KG960G8_BTYG12710BJF960CGN - - 156 326 954K 4.50M

ata-INTEL_SSDSC2KG960G8_BTYG12710B6W960CGN - - 129 325 788K 4.43M

ata-INTEL_SSDSC2KG960G8_BTYG12710B60960CGN - - 156 326 954K 4.50M

ata-INTEL_SSDSC2KG960G8_PHYG126204BV960CGN - - 129 325 788K 4.43M

------------------------------------------------ ----- ----- ----- ----- ----- -----

rpool 298G 590G 25 44 797K 1.73M

mirror-0 298G 590G 25 44 797K 1.73M

ata-INTEL_SSDSC2KG960G8_PHYG1085010V960CGN-part3 - - 12 22 398K 885K

ata-INTEL_SSDSC2KG960G8_PHYG103101KP960CGN-part3 - - 12 22 399K 885K

------------------------------------------------ ----- ----- ----- ----- ----- -----Das sieht alles nach sehr geringen Werte aus? Die SSDs hängen an einem Adaptec SmartRaid Controller, der im HBA Modus läuft (das kann der out of the box, habe nicht irgendwie eine spezielle fw geflasht o.ä., neueste oirignal fw habe ich allerdings eingespielt).

Last edited: