Hallo zusammen. Ich bin ein absoluter Neuling in Sachen Proxmox, aber vom bisherigen System und den Möglichkeiten begeistert.

Das System läuft mit folgenden VM´s: opnSense, fhem, omada Controller, 3CX Telefonanlage und dem Problemkind, einem Windows Server.

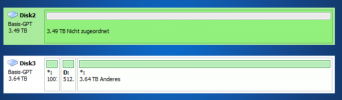

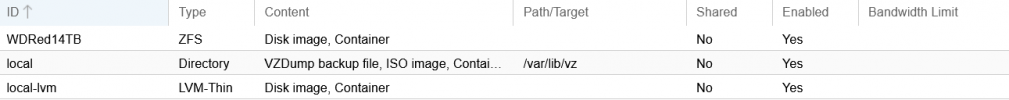

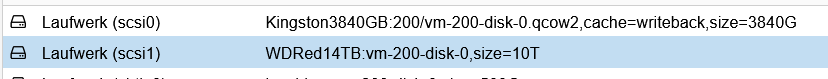

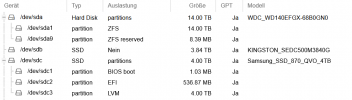

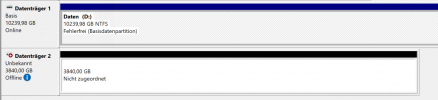

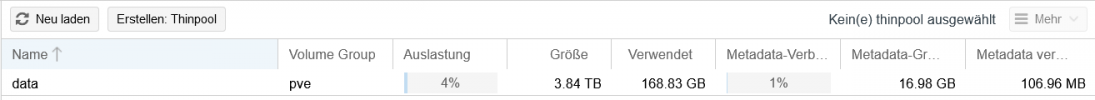

Wenn hier größere Mengen drauf kopiert werden, steht das komplette Netzwerk (Glasfaser Inhouse Verkabelung). Es ist eine WD Red verbaut (Datenablage). Die VM´s selber liegen auf einer SSD.

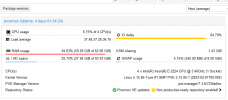

Ich hänge mal einen Screenshot an. Was mich wundert, ist dass die Swap Größe sich nicht ändert. Würde es nicht schneller werden, wenn z. B. auf der SSD ausgelagert werden würde. Von der Windows Seite aus kopiert er mit "anständigen" Werten, Dann bricht er plötzlich auf 0 MB/sek ein, wartet ein paar Sekunden, wieder mit guten Werten weiter usw.

Der IO delay Wert liegt beim kopieren bei ca. 70-80%.

CPU BOGOMIPS: 27199.24

REGEX/SECOND: 4527835

HD SIZE: 93.93 GB (/dev/mapper/pve-root)

BUFFERED READS: 426.11 MB/sec

AVERAGE SEEK TIME: 0.09 ms

FSYNCS/SECOND: 124.30

DNS EXT: 82.24 ms

DNS INT: 22.36 ms (klein.local)

Könnt ihr mir evtl. ein paar Tips geben, was ich machen könnte?

Mar 07 19:29:05 proxmox zed[1881644]: eid=65 class=deadman pool='WDRed14TB' vdev=ata-WDC_WD140EFGX-68B0GN0_Y5KUDWRC-part1 size=8192 offset=6909186076672 priority=3 err=0 flags=0x184880 delay=352541105ms bookmark=216:1:0:251604636

Mar 07 19:29:05 proxmox zed[1881646]: eid=66 class=deadman pool='WDRed14TB' vdev=ata-WDC_WD140EFGX-68B0GN0_Y5KUDWRC-part1 size=8192 offset=6909186068480 priority=3 err=0 flags=0x184880 delay=352541097ms bookmark=216:1:0:251604635

Mar 07 19:29:05 proxmox zed[1881648]: eid=67 class=deadman pool='WDRed14TB' vdev=ata-WDC_WD140EFGX-68B0GN0_Y5KUDWRC-part1 size=8192 offset=6909186060288 priority=3 err=0 flags=0x184880 delay=352541088ms bookmark=216:1:0:251604634

Mar 07 19:29:05 proxmox zed[1881650]: eid=68 class=deadman pool='WDRed14TB' vdev=ata-WDC_WD140EFGX-68B0GN0_Y5KUDWRC-part1 size=8192 offset=6909186052096 priority=3 err=0 flags=0x184880 delay=352541080ms bookmark=216:1:0:251604633

Mar 07 19:30:06 proxmox zed[1882633]: eid=70 class=deadman pool='WDRed14TB' vdev=ata-WDC_WD140EFGX-68B0GN0_Y5KUDWRC-part1 size=8192 offset=6909329080320 priority=3 err=0 flags=0x184880 delay=352602540ms bookmark=216:1:0:251763541

Mar 07 19:30:06 proxmox zed[1882635]: eid=72 class=deadman pool='WDRed14TB' vdev=ata-WDC_WD140EFGX-68B0GN0_Y5KUDWRC-part1 size=8192 offset=6909329063936 priority=3 err=0 flags=0x184880 delay=352602524ms bookmark=216:1:0:251763539

Mar 07 19:30:06 proxmox zed[1882631]: eid=69 class=deadman pool='WDRed14TB' vdev=ata-WDC_WD140EFGX-68B0GN0_Y5KUDWRC-part1 size=8192 offset=6909329088512 priority=3 err=0 flags=0x184880 delay=352602549ms bookmark=216:1:0:251763542

Mar 07 19:30:06 proxmox zed[1882637]: eid=71 class=deadman pool='WDRed14TB' vdev=ata-WDC_WD140EFGX-68B0GN0_Y5KUDWRC-part1 size=8192 offset=6909329072128 priority=3 err=0 flags=0x184880 delay=352602532ms bookmark=216:1:0:251763540

Mar 07 19:31:08 proxmox zed[1885975]: eid=74 class=deadman pool='WDRed14TB' vdev=ata-WDC_WD140EFGX-68B0GN0_Y5KUDWRC-part1 size=8192 offset=6909565890560 priority=3 err=0 flags=0x184880 delay=352663979ms bookmark=216:1:0:251930175

Mar 07 19:31:08 proxmox zed[1885974]: eid=73 class=deadman pool='WDRed14TB' vdev=ata-WDC_WD140EFGX-68B0GN0_Y5KUDWRC-part1 size=8192 offset=6909565898752 priority=3 err=0 flags=0x184880 delay=352663987ms bookmark=216:1:0:251930176

Mar 07 19:31:08 proxmox zed[1885978]: eid=76 class=deadman pool='WDRed14TB' vdev=ata-WDC_WD140EFGX-68B0GN0_Y5KUDWRC-part1 size=8192 offset=6909565874176 priority=3 err=0 flags=0x184880 delay=352663962ms bookmark=216:1:0:251930173

Mar 07 19:31:08 proxmox zed[1885979]: eid=75 class=deadman pool='WDRed14TB' vdev=ata-WDC_WD140EFGX-68B0GN0_Y5KUDWRC-part1 size=8192 offset=6909565882368 priority=3 err=0 flags=0x184880 delay=352663970ms bookmark=216:1:0:251930174

Mar 07 19:32:09 proxmox zed[1887258]: eid=77 class=deadman pool='WDRed14TB' vdev=ata-WDC_WD140EFGX-68B0GN0_Y5KUDWRC-part1 size=8192 offset=6909727395840 priority=3 err=0 flags=0x184880 delay=352725417ms bookmark=216:1:0:251949893

Das System läuft mit folgenden VM´s: opnSense, fhem, omada Controller, 3CX Telefonanlage und dem Problemkind, einem Windows Server.

Wenn hier größere Mengen drauf kopiert werden, steht das komplette Netzwerk (Glasfaser Inhouse Verkabelung). Es ist eine WD Red verbaut (Datenablage). Die VM´s selber liegen auf einer SSD.

Ich hänge mal einen Screenshot an. Was mich wundert, ist dass die Swap Größe sich nicht ändert. Würde es nicht schneller werden, wenn z. B. auf der SSD ausgelagert werden würde. Von der Windows Seite aus kopiert er mit "anständigen" Werten, Dann bricht er plötzlich auf 0 MB/sek ein, wartet ein paar Sekunden, wieder mit guten Werten weiter usw.

Der IO delay Wert liegt beim kopieren bei ca. 70-80%.

CPU BOGOMIPS: 27199.24

REGEX/SECOND: 4527835

HD SIZE: 93.93 GB (/dev/mapper/pve-root)

BUFFERED READS: 426.11 MB/sec

AVERAGE SEEK TIME: 0.09 ms

FSYNCS/SECOND: 124.30

DNS EXT: 82.24 ms

DNS INT: 22.36 ms (klein.local)

Könnt ihr mir evtl. ein paar Tips geben, was ich machen könnte?

Mar 07 19:29:05 proxmox zed[1881644]: eid=65 class=deadman pool='WDRed14TB' vdev=ata-WDC_WD140EFGX-68B0GN0_Y5KUDWRC-part1 size=8192 offset=6909186076672 priority=3 err=0 flags=0x184880 delay=352541105ms bookmark=216:1:0:251604636

Mar 07 19:29:05 proxmox zed[1881646]: eid=66 class=deadman pool='WDRed14TB' vdev=ata-WDC_WD140EFGX-68B0GN0_Y5KUDWRC-part1 size=8192 offset=6909186068480 priority=3 err=0 flags=0x184880 delay=352541097ms bookmark=216:1:0:251604635

Mar 07 19:29:05 proxmox zed[1881648]: eid=67 class=deadman pool='WDRed14TB' vdev=ata-WDC_WD140EFGX-68B0GN0_Y5KUDWRC-part1 size=8192 offset=6909186060288 priority=3 err=0 flags=0x184880 delay=352541088ms bookmark=216:1:0:251604634

Mar 07 19:29:05 proxmox zed[1881650]: eid=68 class=deadman pool='WDRed14TB' vdev=ata-WDC_WD140EFGX-68B0GN0_Y5KUDWRC-part1 size=8192 offset=6909186052096 priority=3 err=0 flags=0x184880 delay=352541080ms bookmark=216:1:0:251604633

Mar 07 19:30:06 proxmox zed[1882633]: eid=70 class=deadman pool='WDRed14TB' vdev=ata-WDC_WD140EFGX-68B0GN0_Y5KUDWRC-part1 size=8192 offset=6909329080320 priority=3 err=0 flags=0x184880 delay=352602540ms bookmark=216:1:0:251763541

Mar 07 19:30:06 proxmox zed[1882635]: eid=72 class=deadman pool='WDRed14TB' vdev=ata-WDC_WD140EFGX-68B0GN0_Y5KUDWRC-part1 size=8192 offset=6909329063936 priority=3 err=0 flags=0x184880 delay=352602524ms bookmark=216:1:0:251763539

Mar 07 19:30:06 proxmox zed[1882631]: eid=69 class=deadman pool='WDRed14TB' vdev=ata-WDC_WD140EFGX-68B0GN0_Y5KUDWRC-part1 size=8192 offset=6909329088512 priority=3 err=0 flags=0x184880 delay=352602549ms bookmark=216:1:0:251763542

Mar 07 19:30:06 proxmox zed[1882637]: eid=71 class=deadman pool='WDRed14TB' vdev=ata-WDC_WD140EFGX-68B0GN0_Y5KUDWRC-part1 size=8192 offset=6909329072128 priority=3 err=0 flags=0x184880 delay=352602532ms bookmark=216:1:0:251763540

Mar 07 19:31:08 proxmox zed[1885975]: eid=74 class=deadman pool='WDRed14TB' vdev=ata-WDC_WD140EFGX-68B0GN0_Y5KUDWRC-part1 size=8192 offset=6909565890560 priority=3 err=0 flags=0x184880 delay=352663979ms bookmark=216:1:0:251930175

Mar 07 19:31:08 proxmox zed[1885974]: eid=73 class=deadman pool='WDRed14TB' vdev=ata-WDC_WD140EFGX-68B0GN0_Y5KUDWRC-part1 size=8192 offset=6909565898752 priority=3 err=0 flags=0x184880 delay=352663987ms bookmark=216:1:0:251930176

Mar 07 19:31:08 proxmox zed[1885978]: eid=76 class=deadman pool='WDRed14TB' vdev=ata-WDC_WD140EFGX-68B0GN0_Y5KUDWRC-part1 size=8192 offset=6909565874176 priority=3 err=0 flags=0x184880 delay=352663962ms bookmark=216:1:0:251930173

Mar 07 19:31:08 proxmox zed[1885979]: eid=75 class=deadman pool='WDRed14TB' vdev=ata-WDC_WD140EFGX-68B0GN0_Y5KUDWRC-part1 size=8192 offset=6909565882368 priority=3 err=0 flags=0x184880 delay=352663970ms bookmark=216:1:0:251930174

Mar 07 19:32:09 proxmox zed[1887258]: eid=77 class=deadman pool='WDRed14TB' vdev=ata-WDC_WD140EFGX-68B0GN0_Y5KUDWRC-part1 size=8192 offset=6909727395840 priority=3 err=0 flags=0x184880 delay=352725417ms bookmark=216:1:0:251949893