Hallo,

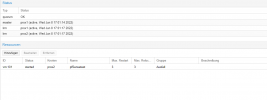

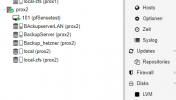

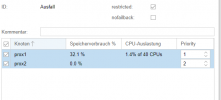

ich habe 3 Knoten wovon einer ein Debian mit quorum ist. Die VM 101 liegt auf prox2. Wenn der Knoten ausfällt landet die VM zwar auf prox1 wird aber nicht gestartet,

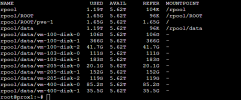

da wohl die disk-0 nicht gefunden wurde. Auch taucht diese nicht auf, per zfs list auf prox1.

Was mache ich falsch ?

VG

ich habe 3 Knoten wovon einer ein Debian mit quorum ist. Die VM 101 liegt auf prox2. Wenn der Knoten ausfällt landet die VM zwar auf prox1 wird aber nicht gestartet,

da wohl die disk-0 nicht gefunden wurde. Auch taucht diese nicht auf, per zfs list auf prox1.

Was mache ich falsch ?

VG

Code:

J

Jun 08 17:08:09 prox1 pve-ha-lrm[3302017]: Task 'UPID:prox1:00326285:00252A78:62A0BA5F:qmstart:101:root@pam:' still active, waiting

Jun 08 17:08:14 prox1 pve-ha-lrm[3302017]: Task 'UPID:prox1:00326285:00252A78:62A0BA5F:qmstart:101:root@pam:' still active, waiting

Jun 08 17:08:19 prox1 pve-ha-lrm[3302017]: Task 'UPID:prox1:00326285:00252A78:62A0BA5F:qmstart:101:root@pam:' still active, waiting

Jun 08 17:08:24 prox1 pve-ha-lrm[3302017]: Task 'UPID:prox1:00326285:00252A78:62A0BA5F:qmstart:101:root@pam:' still active, waiting

Jun 08 17:08:29 prox1 pve-ha-lrm[3302017]: Task 'UPID:prox1:00326285:00252A78:62A0BA5F:qmstart:101:root@pam:' still active, waiting

Jun 08 17:08:34 prox1 pve-ha-lrm[3302017]: Task 'UPID:prox1:00326285:00252A78:62A0BA5F:qmstart:101:root@pam:' still active, waiting

Jun 08 17:08:39 prox1 pve-ha-lrm[3302017]: Task 'UPID:prox1:00326285:00252A78:62A0BA5F:qmstart:101:root@pam:' still active, waiting

Jun 08 17:08:44 prox1 pve-ha-lrm[3302017]: Task 'UPID:prox1:00326285:00252A78:62A0BA5F:qmstart:101:root@pam:' still active, waiting

Jun 08 17:08:49 prox1 pve-ha-lrm[3302017]: Task 'UPID:prox1:00326285:00252A78:62A0BA5F:qmstart:101:root@pam:' still active, waiting

Jun 08 17:08:54 prox1 pve-ha-lrm[3302017]: Task 'UPID:prox1:00326285:00252A78:62A0BA5F:qmstart:101:root@pam:' still active, waiting

Jun 08 17:08:59 prox1 pve-ha-lrm[3302021]: timeout: no zvol device link for 'vm-101-disk-0' found after 300 sec found.

Jun 08 17:08:59 prox1 pve-ha-lrm[3302017]: <root@pam> end task UPID:prox1:00326285:00252A78:62A0BA5F:qmstart:101:root@pam: timeout: no zvol device link for 'vm-101-disk-0' found after 300 sec found.

Jun 08 17:08:59 prox1 pve-ha-lrm[3302017]: unable to start service vm:101

Jun 08 17:09:00 prox1 pve-ha-lrm[952372]: restart policy: retry number 1 for service 'vm:101'

Jun 08 17:09:10 prox1 pve-ha-lrm[3325429]: starting service vm:101