Die üblichen Email-Ports für PMG müssen natürlich von außen erreichbar sein. Aber das Webinterface von PVE, PBS und auch PMG muss das eigentlich

nicht. Und ich würde versuchen, das auch nicht zu tun - das offene Internet ist nach wie vor "gefährlich". 2FA hin- oder her.

VPNs existieren, in wirklich vielen Geschmacksrichtungen. Ich persönlich habe mich auf handgeklöppelte Wireguard-Verbindungen eingeschossen -das ist

so einfach, dass ich verstehe, was ich da tue

Ich kann da keine komplette Anleitung zu liefern, aber die gibt es ja zuhauf.

Mein Ansatz folgt direkt

https://www.wireguard.com/quickstart/

Wireguard hatte ich schon installiert, allerdings bin ich daran gescheitert eine direkte Fritzbox<>Wireguard VM Verbindung aufzubauen.

Die Verbindung als Wireguard Client vom Rechner mit der Wireguard VM hat funktioniert, allerdings flog dann mein Arbeitsrechner Rechner aus dem Internet. Oder hab ich da nen Denkfehler, kann man das irgendwie lösen?

Du gehst da ganze gedanklich falsch an.

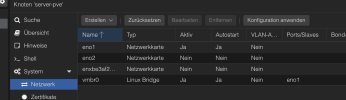

Auf dem dedizierten Server installierst Du Proxmox mit einer externen IP für vmbr0 dann baust Du intern für die VMs Dir ein eigenes privates Netzwerk auf. Und eine VM kann eine Firewall sein welche alle internen Netzwerkdevices inklusive vmbr0 bekommt und somit ein Bein zum öffentlichen Netz hat. Alles anderen VMs bekommen keinen direkten Zugang zum öffentlichen Netz.

Verwaltung der Umgebung komplett über VPN.

Danke für den Input! Das habe ich verstanden und das ergibt auch Sinn.

Wäre ich so nicht drauf gekommen. Hab Proxmox bislang immer nur in der Homelab Umgebung genutzt und stelle jetzt meinen dedizierten Server komplett auf v-Server um.

Also du meinst die initiale Proxmox VE hätte dan eine öffentliche IPv4, aber weder der Debianserver noch das darauf laufende Plesk einen öffentlichen Zugang übers Internet? Hier würde ich mich dann immer mittels Wireguard verbidnen?

Die Webseiten und Webserver die Plesk verwaltet kommen dann dennoch ins Netz? Vermutlich muss der Debianserver mit Plesk doch auch online sein? Alleine schon wegen dem Mailversand? Oder wird das alles transparent über die IP der Proxmox VE durchgereicht?

Muss ich mich nochmal einlesen.

Und kann man das auch noch im Nachhinein auf internes Netz umstellen?

Hab jetzt nämlich eine Testinstallation am laufen die so schon funktioniert. Auf der Mail Gateway tut schon seinen Dienst.

Hier sind allerdings alle VMs mit ner öffentlichen IPv4 versehen.

Hab auch bemerkt, dass ich den PBS eigentlich garnicht auf dem Webserver benötige. Ich kann ja die VMs und LXCs auch mit dem Proxmox Backup Server verbinden, der in meinem Homelab läuft und dort Backups auf mein lokales NAS über NFS ablegt, gleichzeitig aber auch den Storage auf dem dedizierten Webserver erreicht.