Hallo in die Runde,

wir sind aktuell dabei unsere VMware-Umgebung durch Proxmox zu ersetzen. So zumindest die grobe Idee. Bevor ich das aber "scharf schalte", habe ich noch zwei oder drei kleinere Fragen, die mir die Doku auch nicht abschließend beantwortet.

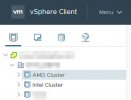

Zum einen die Frage, wie man die Hardware in sinnvolle "Unterkategorien" einteilt. Aus dem vCenter bin ich es bisher gewohnt, dass ich die Cluster (u.a.) nach verbauter CPU sortiere, so wie hier:

Lässt sich diese Darstellung oder Einteilung in Proxmox auch abbilden? Oder ist es sinnvoller, alle PVE-Hosts einem Cluster zuzuordnen und die logische Einteilung dann anders vorzunehmen? Wenn ich die Doku richtig deute, dann heißt es sinngemäß "ja, mehrere Cluster kann man machen, sollte man aber nicht". Auch wenn es so explizit da nicht steht... Ich habe es bisher auch noch nicht selbst getestet, aber stellt das Webinterface eines PVE-Hosts dann auch mehere Knoten dar, die verwaltet werden können, wenn sie einem Cluster zugeordnet sind?

Meine andere Frage zielt auf den CPU-Typ ab, mit dem man die Maschinen in einer gemischten Umgebung am besten betreibt. Im Prinzip würde es mir reichen, wenn ich die Maschinen, die bisher auf AMD Hardware liefen (alles EPYC 7001 und 7002) weiterhin nur auf AMD Hardware betreibe. Und die Intel-VMs dann eben nur auf Intel-Hardware (alles älteres Zeug, die neuste CPU müsste ein Xeon 2640 v3 sein). Grundsätzlich scheint es ja aber auch möglich, Live-Migration auch zwischen Intel und AMD machen zu können, sofern die CPU Flags passen. Das wäre natürlich eine echte Verbesserung zum jetzigen Zustand. Wenn ich meine virtuellen Maschinen aber migriere, will ich sie am besten nur einmal anfassen, alles richtig einstellen und dann in Frieden lassen.

Es handelt sich dabei um Linux- und Windows-Maschinen. Bei Linux mache ich mir keinen Kopf, aber den Windows-Kisten möchte ich nicht (im schlimmsten Fall) x-verschiedene CPUs zumuten. Oder ist die Verwendung vom CPU-Typ "Host" auch kein Problem mehr? Es sei gesagt, da ist noch ein bisschen legacy stuff (Server 2008 R2 als ältestes Beispiel) dabei...

Danke vorab für eure Unterstützung

wir sind aktuell dabei unsere VMware-Umgebung durch Proxmox zu ersetzen. So zumindest die grobe Idee. Bevor ich das aber "scharf schalte", habe ich noch zwei oder drei kleinere Fragen, die mir die Doku auch nicht abschließend beantwortet.

Zum einen die Frage, wie man die Hardware in sinnvolle "Unterkategorien" einteilt. Aus dem vCenter bin ich es bisher gewohnt, dass ich die Cluster (u.a.) nach verbauter CPU sortiere, so wie hier:

Lässt sich diese Darstellung oder Einteilung in Proxmox auch abbilden? Oder ist es sinnvoller, alle PVE-Hosts einem Cluster zuzuordnen und die logische Einteilung dann anders vorzunehmen? Wenn ich die Doku richtig deute, dann heißt es sinngemäß "ja, mehrere Cluster kann man machen, sollte man aber nicht". Auch wenn es so explizit da nicht steht... Ich habe es bisher auch noch nicht selbst getestet, aber stellt das Webinterface eines PVE-Hosts dann auch mehere Knoten dar, die verwaltet werden können, wenn sie einem Cluster zugeordnet sind?

Meine andere Frage zielt auf den CPU-Typ ab, mit dem man die Maschinen in einer gemischten Umgebung am besten betreibt. Im Prinzip würde es mir reichen, wenn ich die Maschinen, die bisher auf AMD Hardware liefen (alles EPYC 7001 und 7002) weiterhin nur auf AMD Hardware betreibe. Und die Intel-VMs dann eben nur auf Intel-Hardware (alles älteres Zeug, die neuste CPU müsste ein Xeon 2640 v3 sein). Grundsätzlich scheint es ja aber auch möglich, Live-Migration auch zwischen Intel und AMD machen zu können, sofern die CPU Flags passen. Das wäre natürlich eine echte Verbesserung zum jetzigen Zustand. Wenn ich meine virtuellen Maschinen aber migriere, will ich sie am besten nur einmal anfassen, alles richtig einstellen und dann in Frieden lassen.

Es handelt sich dabei um Linux- und Windows-Maschinen. Bei Linux mache ich mir keinen Kopf, aber den Windows-Kisten möchte ich nicht (im schlimmsten Fall) x-verschiedene CPUs zumuten. Oder ist die Verwendung vom CPU-Typ "Host" auch kein Problem mehr? Es sei gesagt, da ist noch ein bisschen legacy stuff (Server 2008 R2 als ältestes Beispiel) dabei...

Danke vorab für eure Unterstützung