Danke für Deine Geduld .. schaut es jetzt gut aus?

root@proxmox:/# lvdisplay

--- Logical volume ---

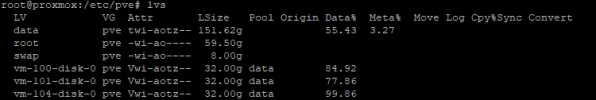

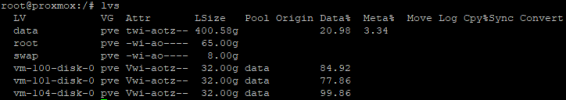

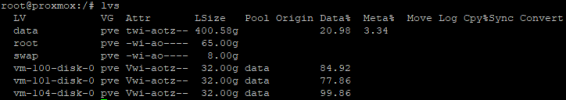

LV Name data

VG Name pve

LV UUID 6nbh2R-IGpQ-RRNT-r6b5-FFPV-JQMA-KCIoeO

LV Write Access read/write (activated read only)

LV Creation host, time proxmox, 2018-10-11 17:49:14 +0200

LV Pool metadata data_tmeta

LV Pool data data_tdata

LV Status available

# open 0

LV Size 400.58 GiB

Allocated pool data 20.98%

Allocated metadata 3.34%

Current LE 102549

Segments 1

Allocation inherit

Read ahead sectors auto

- currently set to 256

Block device 252:5

--- Logical volume ---

LV Path /dev/pve/swap

LV Name swap

VG Name pve

LV UUID p7vns2-6f6T-GpfH-b9e3-p2EM-Sd7x-S7wfpV

LV Write Access read/write

LV Creation host, time proxmox, 2018-10-11 17:49:13 +0200

LV Status available

# open 2

LV Size 8.00 GiB

Current LE 2048

Segments 1

Allocation inherit

Read ahead sectors auto

- currently set to 256

Block device 252:0

--- Logical volume ---

LV Path /dev/pve/root

LV Name root

VG Name pve

LV UUID CfH0Jf-WxjB-bEov-cI4l-gnvy-mJUJ-IZvklY

LV Write Access read/write

LV Creation host, time proxmox, 2018-10-11 17:49:13 +0200

LV Status available

# open 1

LV Size 65.00 GiB

Current LE 16640

Segments 2

Allocation inherit

Read ahead sectors auto

- currently set to 256

Block device 252:1

--- Logical volume ---

LV Path /dev/pve/vm-100-disk-0

LV Name vm-100-disk-0

VG Name pve

LV UUID EAgj1p-idTz-al04-j2P3-tWW6-yyze-GA5cyJ

LV Write Access read/write

LV Creation host, time proxmox, 2020-10-21 07:38:43 +0200

LV Pool name data

LV Status available

# open 1

LV Size 32.00 GiB

Mapped size 84.92%

Current LE 8192

Segments 1

Allocation inherit

Read ahead sectors auto

- currently set to 256

Block device 252:6

--- Logical volume ---

LV Path /dev/pve/vm-104-disk-0

LV Name vm-104-disk-0

VG Name pve

LV UUID tAiN75-uSmb-tm45-jE2Q-pmcK-GYEz-IsbeCS

LV Write Access read/write

LV Creation host, time proxmox, 2020-11-13 11:21:08 +0100

LV Pool name data

LV Status available

# open 1

LV Size 32.00 GiB

Mapped size 99.86%

Current LE 8192

Segments 1

Allocation inherit

Read ahead sectors auto

- currently set to 256

Block device 252:7

--- Logical volume ---

LV Path /dev/pve/vm-101-disk-0

LV Name vm-101-disk-0

VG Name pve

LV UUID DvYNl5-is1e-o9Ac-BzIQ-Vz5t-pPnA-Na34tP

LV Write Access read/write

LV Creation host, time proxmox, 2023-12-26 14:52:12 +0100

LV Pool name data

LV Status available

# open 1

LV Size 32.00 GiB

Mapped size 77.86%

Current LE 8192

Segments 1

Allocation inherit

Read ahead sectors auto

- currently set to 256

Block device 252:8