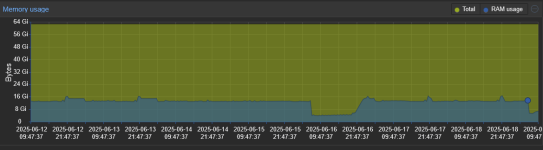

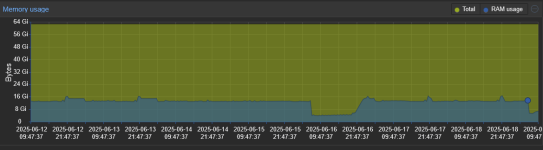

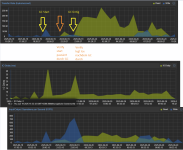

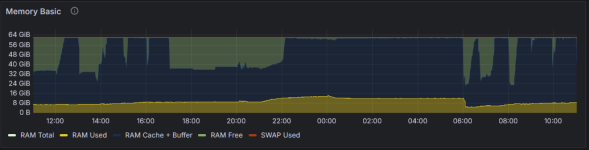

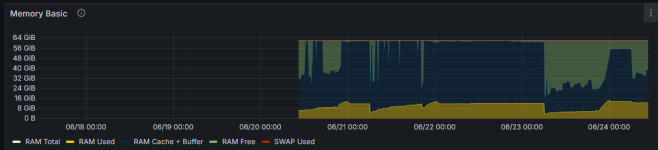

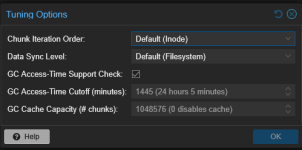

Das hat immense Auswirkungen auf die Performance vom GC

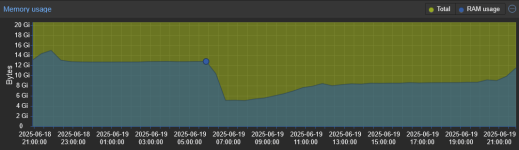

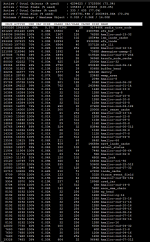

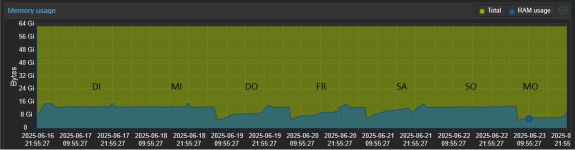

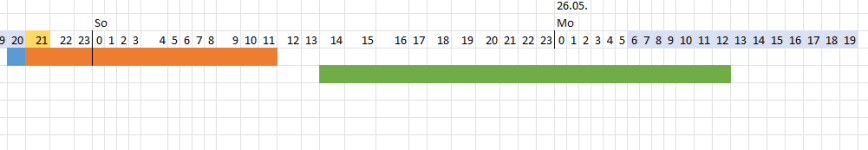

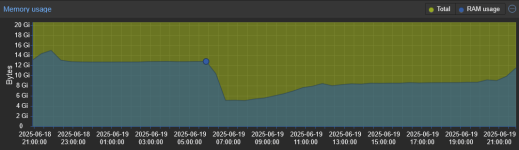

Aktueller Lauf nach der Cache/RAM-Leerung heut früh, er scheint aber gerade wieder den RAM zu befüllen ab 21:05:

Laufzeit ohne vorher gehaltenen Cache: 4% -> 24min er beschleunigt aber hintenraus:

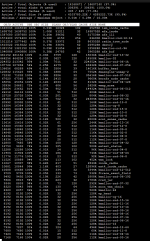

2025-06-19T21:05:01+02:00: Start GC phase1 (mark used chunks)

2025-06-19T21:05:01+02:00: marked 1% (19 of 1844 index files)

2025-06-19T21:08:12+02:00: marked 2% (37 of 1844 index files)

2025-06-19T21:16:25+02:00: marked 3% (56 of 1844 index files)

2025-06-19T21:29:13+02:00: marked 4% (74 of 1844 index files)

2025-06-19T21:56:35+02:00: marked 5% (93 of 1844 index files)

2025-06-19T21:57:45+02:00: marked 6% (111 of 1844 index files)

2025-06-19T21:58:57+02:00: marked 7% (130 of 1844 index files)

2025-06-19T22:02:50+02:00: marked 8% (148 of 1844 index files)

2025-06-19T22:06:02+02:00: marked 9% (166 of 1844 index files)

2025-06-19T22:09:32+02:00: marked 10% (185 of 1844 index files)

2025-06-19T22:15:06+02:00: marked 11% (203 of 1844 index files)

2025-06-19T22:18:45+02:00: marked 12% (222 of 1844 index files)

2025-06-19T22:24:38+02:00: marked 13% (240 of 1844 index files)

2025-06-19T22:31:49+02:00: marked 14% (259 of 1844 index files)

2025-06-19T22:36:02+02:00: marked 15% (277 of 1844 index files)

2025-06-19T22:36:15+02:00: marked 16% (296 of 1844 index files)

2025-06-19T22:43:17+02:00: marked 17% (314 of 1844 index files)

2025-06-19T22:45:05+02:00: marked 18% (332 of 1844 index files)

2025-06-19T22:46:59+02:00: marked 19% (351 of 1844 index files)

2025-06-19T22:50:49+02:00: marked 20% (369 of 1844 index files)

2025-06-19T22:53:13+02:00: marked 21% (388 of 1844 index files)

2025-06-19T23:04:08+02:00: marked 22% (406 of 1844 index files)

2025-06-19T23:09:04+02:00: marked 23% (425 of 1844 index files)

2025-06-19T23:10:05+02:00: marked 24% (443 of 1844 index files)

2025-06-19T23:10:06+02:00: marked 25% (461 of 1844 index files)

2025-06-19T23:10:08+02:00: marked 26% (480 of 1844 index files)

2025-06-19T23:11:14+02:00: marked 27% (498 of 1844 index files)

2025-06-19T23:11:43+02:00: marked 28% (517 of 1844 index files)

2025-06-19T23:11:45+02:00: marked 29% (535 of 1844 index files)

2025-06-19T23:11:46+02:00: marked 30% (554 of 1844 index files)

2025-06-19T23:12:01+02:00: marked 31% (572 of 1844 index files)

2025-06-19T23:16:40+02:00: marked 32% (591 of 1844 index files)

2025-06-19T23:17:03+02:00: marked 33% (609 of 1844 index files)

2025-06-19T23:17:11+02:00: marked 34% (627 of 1844 index files)

2025-06-19T23:17:17+02:00: marked 35% (646 of 1844 index files)

2025-06-19T23:17:39+02:00: marked 36% (664 of 1844 index files)

2025-06-19T23:20:29+02:00: marked 37% (683 of 1844 index files)

2025-06-19T23:20:39+02:00: marked 38% (701 of 1844 index files)

2025-06-19T23:20:39+02:00: marked 39% (720 of 1844 index files)

2025-06-19T23:21:25+02:00: marked 40% (738 of 1844 index files)

2025-06-19T23:21:48+02:00: marked 41% (757 of 1844 index files)

2025-06-19T23:22:01+02:00: marked 42% (775 of 1844 index files)

2025-06-19T23:22:07+02:00: marked 43% (793 of 1844 index files)

2025-06-19T23:22:16+02:00: marked 44% (812 of 1844 index files)

2025-06-19T23:22:22+02:00: marked 45% (830 of 1844 index files)

2025-06-19T23:22:56+02:00: marked 46% (849 of 1844 index files)

2025-06-19T23:23:06+02:00: marked 47% (867 of 1844 index files)

2025-06-19T23:23:30+02:00: marked 48% (886 of 1844 index files)

2025-06-19T23:23:49+02:00: marked 49% (904 of 1844 index files)

2025-06-19T23:24:11+02:00: marked 50% (922 of 1844 index files)

2025-06-19T23:24:29+02:00: marked 51% (941 of 1844 index files)

2025-06-19T23:24:34+02:00: marked 52% (959 of 1844 index files)

2025-06-19T23:24:50+02:00: marked 53% (978 of 1844 index files)

2025-06-19T23:24:52+02:00: marked 54% (996 of 1844 index files)

2025-06-19T23:24:56+02:00: marked 55% (1015 of 1844 index files)

2025-06-19T23:24:59+02:00: marked 56% (1033 of 1844 index files)

2025-06-19T23:25:09+02:00: marked 57% (1052 of 1844 index files)

2025-06-19T23:25:12+02:00: marked 58% (1070 of 1844 index files)

2025-06-19T23:25:22+02:00: marked 59% (1088 of 1844 index files)

2025-06-19T23:25:28+02:00: marked 60% (1107 of 1844 index files)

2025-06-19T23:25:39+02:00: marked 61% (1125 of 1844 index files)

2025-06-19T23:25:54+02:00: marked 62% (1144 of 1844 index files)

2025-06-19T23:26:01+02:00: marked 63% (1162 of 1844 index files)

2025-06-19T23:26:33+02:00: marked 64% (1181 of 1844 index files)

2025-06-19T23:26:46+02:00: marked 65% (1199 of 1844 index files)

2025-06-19T23:26:48+02:00: marked 66% (1218 of 1844 index files)

2025-06-19T23:27:03+02:00: marked 67% (1236 of 1844 index files)

2025-06-19T23:27:04+02:00: marked 68% (1254 of 1844 index files)

2025-06-19T23:27:16+02:00: marked 69% (1273 of 1844 index files)

2025-06-19T23:27:32+02:00: marked 70% (1291 of 1844 index files)

2025-06-19T23:27:41+02:00: marked 71% (1310 of 1844 index files)

2025-06-19T23:27:54+02:00: marked 72% (1328 of 1844 index files)

2025-06-19T23:27:58+02:00: marked 73% (1347 of 1844 index files)

2025-06-19T23:28:08+02:00: marked 74% (1365 of 1844 index files)

2025-06-19T23:28:09+02:00: marked 75% (1383 of 1844 index files)

2025-06-19T23:28:10+02:00: marked 76% (1402 of 1844 index files)

2025-06-19T23:28:18+02:00: marked 77% (1420 of 1844 index files)

2025-06-19T23:28:24+02:00: marked 78% (1439 of 1844 index files)

2025-06-19T23:28:30+02:00: marked 79% (1457 of 1844 index files)

2025-06-19T23:28:36+02:00: marked 80% (1476 of 1844 index files)

2025-06-19T23:28:37+02:00: marked 81% (1494 of 1844 index files)

2025-06-19T23:28:46+02:00: marked 82% (1513 of 1844 index files)

2025-06-19T23:29:15+02:00: marked 83% (1531 of 1844 index files)

2025-06-19T23:29:21+02:00: marked 84% (1549 of 1844 index files)

2025-06-19T23:29:25+02:00: marked 85% (1568 of 1844 index files)

2025-06-19T23:29:33+02:00: marked 86% (1586 of 1844 index files)

2025-06-19T23:29:44+02:00: marked 87% (1605 of 1844 index files)

2025-06-19T23:29:54+02:00: marked 88% (1623 of 1844 index files)

2025-06-19T23:30:11+02:00: marked 89% (1642 of 1844 index files)

2025-06-19T23:30:17+02:00: marked 90% (1660 of 1844 index files)

2025-06-19T23:30:31+02:00: marked 91% (1679 of 1844 index files)

2025-06-19T23:30:40+02:00: marked 92% (1697 of 1844 index files)

2025-06-19T23:30:48+02:00: marked 93% (1715 of 1844 index files)

2025-06-19T23:31:01+02:00: marked 94% (1734 of 1844 index files)

2025-06-19T23:31:20+02:00: marked 95% (1752 of 1844 index files)

2025-06-19T23:31:32+02:00: marked 96% (1771 of 1844 index files)

2025-06-19T23:31:43+02:00: marked 97% (1789 of 1844 index files)

2025-06-19T23:32:02+02:00: marked 98% (1808 of 1844 index files)

2025-06-19T23:32:05+02:00: marked 99% (1826 of 1844 index files)

2025-06-19T23:32:14+02:00: marked 100% (1844 of 1844 index files)

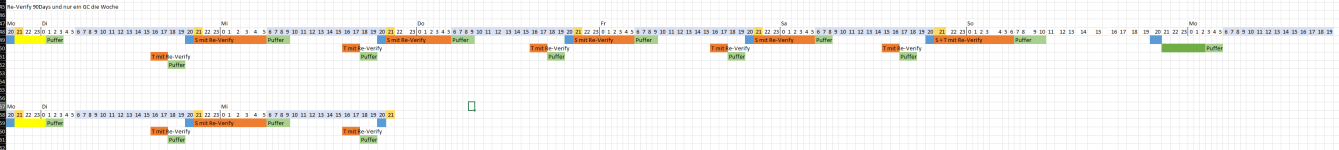

Laufzeit mit "vollem" Cache: 4% -> 5s

Komplett fertig in 37min mit 1844 Indexfiles und 15 Millionen Chunks und das mit nem "billo" HDD RAID 6 aus 8x18TB. Das ist mega!

Es scheint also möglich zu sein, in einem gewissen "Gesamtzustand des Systems", das er so schnell ist.

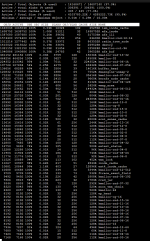

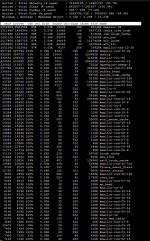

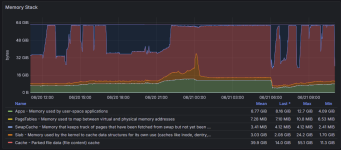

aktuelle Cachebelegung bei langsamen GC:

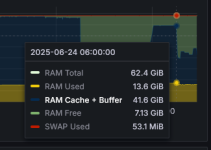

Da scheint mir sehr viel in der nähe 100% zu laufen -> ich habe Gesamt 64GB RAM -> noch ca. 40GB frei mit paar GB Puffer für Unvorhergesehenes und dem was jetzt belegt ist.

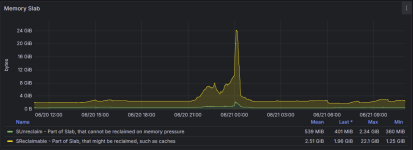

Wenn ich das hier richtig lese sind ja Gesamt nur 4GB Cache dort auslesbar -> das würde zur Grundlinie, unter die er nie groß drunterfällt passen.

Dann wird es spannend welche Prozesse da über den 4GB RAM belegen -> die werden dann vmtl. im

nicht zu sehen sein.