Hallo,

ich hab mir in einem PVE mit externen USB Platten einen ZFS Pool (raidz) zusammengestrickt. Das ganze ist jetzt nur zum testen und lernen. Ich weiß, das diese HW Konstellation suboptimal ist. Mir geht es darum den Umgang mit Devices & Storage zu lernen.

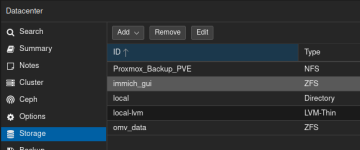

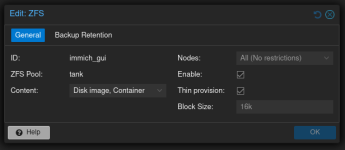

Hier mal die aktuelle Konfiguration:

Ich möchte in diesem ZFS Pool nun Nutzdaten der Container und der VM ablegen können. Z.b. soll im späteren Echtsystem in einem Container die Bilderverwaltung Immich laufen und die Bilder sollen nicht im Container sondern auf dem ZFS Pool liegen.

Um den ZFS Pool in den Container zu bekommen, könnte ich nun über die Konsole einen Mount Point für den Container setzen:

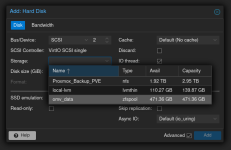

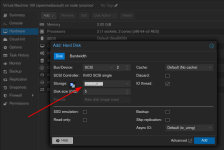

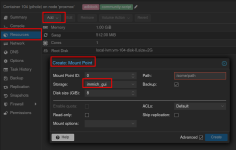

Wenn ich jetzt per UI einen Mount Point für den ZFS Pool in den Container setze, dann wird ja eine virtuelle Disk auf dem ZFS Pool angelegt. Wenn ich es richtig im Kopf habe könnte ich die z.B. mit 100 GB anlegen und die wird aber erst mit der Zeit auf 100GB anwachsen, je nach dem wie viel Platz tatsächlich benötigt wird. Das wäre OK. Ich muss halt darauf achten, das meine virtuellen Disks nicht den Gesamtplatz des ZFS Pools sprengen.

ABER: Wenn ich einzelne Verzeichnisse aus so einer virtuellen Disk Sichern möchte, dann geht das nur aus dem Container heraus. Ich müsste als in jedem Container die Backups konfigurieren und triggern. Schön wäre es ja, wenn ich das vom PVE System aus machen könnte. Dort sehe ich aber nur die komplette virtuelle Disk und nicht deren Inhalt.

Fragen:

Sind meine Ideen grundsätzlich sinnvoll? Oder bin ich bei der Nutzung eines ZFS Pools auf dem Holzweg?

Welche der beiden Varianten ist empfehlenswert? Gibt es vielleicht noch eine weitere?

ich hab mir in einem PVE mit externen USB Platten einen ZFS Pool (raidz) zusammengestrickt. Das ganze ist jetzt nur zum testen und lernen. Ich weiß, das diese HW Konstellation suboptimal ist. Mir geht es darum den Umgang mit Devices & Storage zu lernen.

Hier mal die aktuelle Konfiguration:

Bash:

root@proxmox:~# lsblk

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINTS

sda 8:0 0 298.1G 0 disk

├─sda1 8:1 0 1007K 0 part

├─sda2 8:2 0 1G 0 part /boot/efi

└─sda3 8:3 0 297.1G 0 part

├─pve-swap 252:0 0 8G 0 lvm [SWAP]

├─pve-root 252:1 0 84.3G 0 lvm /

├─pve-data_tmeta 252:2 0 1.9G 0 lvm

│ └─pve-data-tpool 252:4 0 185G 0 lvm

│ ├─pve-data 252:5 0 185G 1 lvm

│ ├─pve-vm--100--disk--0 252:6 0 8G 0 lvm

│ ├─pve-vm--101--disk--0 252:7 0 4M 0 lvm

│ ├─pve-vm--101--disk--1 252:8 0 32G 0 lvm

│ ├─pve-vm--102--disk--0 252:9 0 1G 0 lvm

│ ├─pve-vm--103--disk--0 252:10 0 8G 0 lvm

│ ├─pve-vm--104--disk--0 252:11 0 2G 0 lvm

│ └─pve-vm--106--disk--0 252:12 0 20G 0 lvm

└─pve-data_tdata 252:3 0 185G 0 lvm

└─pve-data-tpool 252:4 0 185G 0 lvm

├─pve-data 252:5 0 185G 1 lvm

├─pve-vm--100--disk--0 252:6 0 8G 0 lvm

├─pve-vm--101--disk--0 252:7 0 4M 0 lvm

├─pve-vm--101--disk--1 252:8 0 32G 0 lvm

├─pve-vm--102--disk--0 252:9 0 1G 0 lvm

├─pve-vm--103--disk--0 252:10 0 8G 0 lvm

├─pve-vm--104--disk--0 252:11 0 2G 0 lvm

└─pve-vm--106--disk--0 252:12 0 20G 0 lvm

sdb 8:16 0 232.9G 0 disk

├─sdb1 8:17 0 232.9G 0 part

└─sdb9 8:25 0 8M 0 part

sdc 8:32 0 232.9G 0 disk

├─sdc1 8:33 0 232.9G 0 part

└─sdc9 8:41 0 8M 0 part

sdd 8:48 0 232.9G 0 disk

├─sdd1 8:49 0 232.9G 0 part

└─sdd9 8:57 0 8M 0 part

sr0 11:0 1 1024M 0 rom

root@proxmox:~# zpool list

NAME SIZE ALLOC FREE CKPOINT EXPANDSZ FRAG CAP DEDUP HEALTH ALTROOT

ZFS-USB-RAID 696G 1.16M 696G - - 0% 0% 1.00x ONLINE -

root@proxmox:~# zpool status

pool: ZFS-USB-RAID

state: ONLINE

config:

NAME STATE READ WRITE CKSUM

ZFS-USB-RAID ONLINE 0 0 0

raidz1-0 ONLINE 0 0 0

sdb ONLINE 0 0 0

sdc ONLINE 0 0 0

sdd ONLINE 0 0 0

errors: No known data errors

root@proxmox:~# zfs list

NAME USED AVAIL REFER MOUNTPOINT

ZFS-USB-RAID 783K 449G 128K /ZFS-USB-RAID- sda ist für das Proxmox VE System. Ein paar Testcontainer und eine Test VM laufen da.

- sdb, sdc & sdd sind zu einem raidz ZFS Pool (ZFS-USB-RAID) verbunden.

- Der Pool ist im PVE unter /ZFS-USB-POOL gemountet.

Ich möchte in diesem ZFS Pool nun Nutzdaten der Container und der VM ablegen können. Z.b. soll im späteren Echtsystem in einem Container die Bilderverwaltung Immich laufen und die Bilder sollen nicht im Container sondern auf dem ZFS Pool liegen.

Um den ZFS Pool in den Container zu bekommen, könnte ich nun über die Konsole einen Mount Point für den Container setzen:

pct set 200 -mp0 /ZFS-USB-POOL,mp=/mnt/ZFS-USB-POOL,backup=0 Damit wäre der komplette ZFS Pool in dem Container im Zugriff. Wenn ich den gleichen ZFS Pool auch in einem anderen Container per Mount Point einbinde, dann sehen beide Container jeweils die Daten des anderen. Das würde ich gerne vermeiden.Wenn ich jetzt per UI einen Mount Point für den ZFS Pool in den Container setze, dann wird ja eine virtuelle Disk auf dem ZFS Pool angelegt. Wenn ich es richtig im Kopf habe könnte ich die z.B. mit 100 GB anlegen und die wird aber erst mit der Zeit auf 100GB anwachsen, je nach dem wie viel Platz tatsächlich benötigt wird. Das wäre OK. Ich muss halt darauf achten, das meine virtuellen Disks nicht den Gesamtplatz des ZFS Pools sprengen.

ABER: Wenn ich einzelne Verzeichnisse aus so einer virtuellen Disk Sichern möchte, dann geht das nur aus dem Container heraus. Ich müsste als in jedem Container die Backups konfigurieren und triggern. Schön wäre es ja, wenn ich das vom PVE System aus machen könnte. Dort sehe ich aber nur die komplette virtuelle Disk und nicht deren Inhalt.

Fragen:

Sind meine Ideen grundsätzlich sinnvoll? Oder bin ich bei der Nutzung eines ZFS Pools auf dem Holzweg?

Welche der beiden Varianten ist empfehlenswert? Gibt es vielleicht noch eine weitere?