Hallo

@Fabian_E

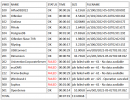

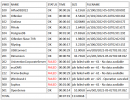

die history.log (aus history.log.1.gz) habe ich Dir angehangen.

Das Upgrade vom 26.03. könnte tatsächlich (leider) Zeitlich der Auslöser des Verhaltens sein.

Die Fehler sind nicht immer gleich, aber wiederholen sich.

Tatsächlich mach ich taglich 2 Backups. 1x 4 Uhr morgens auf den PXE Backup Server (als VM) an welche eine externe Festplatte durchgereicht ist.

Und als 2te Sicherung um 6 Uhr morgens auf eine weitere Externe HDD (Habe mal gelesen es gibt Probleme die erste Sicherung von 4 Uhr wiederherzustellen, falls es mal Probleme mit dem PXE Backup Server gibt).

Interessant finde ich das die Sicherungen völlig seltsam sporadisch gehen oder nicht gehen. Es sind ein paar Maschinen, die immer Auf die fehlschlagen, andere gehen mal und eben mal nicht.

Gern kann ich alle Logs hochladen, will euch aber nicht zuspammen. Falls gewünscht reiche ich diese aber gerne nach.

Begonnen hat es bei den VMs mit:

Code:

job failed with err -61 - No data available

job failed with err -125 - Operation canceled

Anschließend kam

Dieser bei dem CT mit der ID 104 dazu:

Code:

command 'set -o pipefail && tar cpf - --totals --one-file-system -p --sparse --numeric-owner --acls --xattrs '--xattrs-include=user.*' '--xattrs-include=security.capability' '--warning=no-file-ignored' '--warning=no-xattr-write' --one-file-system '--warning=no-file-ignored' '--directory=/mnt/pve/Intern256/dump/vzdump-lxc-104-2022_04_30-20_15_31.tmp' ./etc/vzdump/pct.conf ./etc/vzdump/pct.fw '--directory=/mnt/vzsnap0' --no-anchored '--exclude=lost+found' --anchored '--exclude=./tmp/?*' '--exclude=./var/tmp/?*' '--exclude=./var/run/?*.pid' ./ | gzip --rsyncable >/mnt/pve/Intern256/dump/vzdump-lxc-104-2022_04_30-20_15_31.tar.dat' failed: exit code 1

dieser verschwand dann wieder (von selbst)

dann hatte ich beim CT ID 106 diesen Fehler:

Code:

command '/usr/bin/proxmox-backup-client backup '--crypt-mode=none' pct.conf:/var/tmp/vzdumptmp275898_106/etc/vzdump/pct.conf root.pxar:/mnt/vzsnap0 --include-dev /mnt/vzsnap0/./ --skip-lost-and-found '--exclude=/tmp/?*' '--exclude=/var/tmp/?*' '--exclude=/var/run/?*.pid' --backup-type ct --backup-id 106 --backup-time 1651543441 --repository root@pam@192.168.0.238:ExtHDD2TB' failed: exit code 255

wo er wieder verschwand und dann auf dem CT mit ID 104 auftrat.

Dann ein Backup in welchem die CTs mit den IDs 103, 104 und 105 den Fehler

Code:

command '/usr/bin/proxmox-backup-client backup '--crypt-mode=none' pct.conf:/var/tmp/vzdumptmp3598194_103/etc/vzdump/pct.conf root.pxar:/mnt/vzsnap0 --include-dev /mnt/vzsnap0/./ --skip-lost-and-found '--exclude=/tmp/?*' '--exclude=/var/tmp/?*' '--exclude=/var/run/?*.pid' --backup-type ct --backup-id 103 --backup-time 1651629673 --repository root@pam@192.168.0.238:ExtHDD2TB' failed: exit code 255

Anschließend funktionierte das Backup von 103 und 105 wieder. ID 104 hatte wieder den Fehler:

Code:

command 'set -o pipefail && tar cpf - --totals --one-file-system -p --sparse --numeric-owner --acls --xattrs '--xattrs-include=user.*' '--xattrs-include=security.capability' '--warning=no-file-ignored' '--warning=no-xattr-write' --one-file-system '--warning=no-file-ignored' '--directory=/mnt/pve/ExtSSD512/dump/vzdump-lxc-104-2022_05_04-06_02_00.tmp' ./etc/vzdump/pct.conf ./etc/vzdump/pct.fw '--directory=/mnt/vzsnap0' --no-anchored '--exclude=lost+found' --anchored '--exclude=./tmp/?*' '--exclude=./var/tmp/?*' '--exclude=./var/run/?*.pid' ./ | zstd --rsyncable '--threads=1' >/mnt/pve/ExtSSD512/dump/vzdump-lxc-104-2022_05_04-06_02_00.tar.dat' failed: exit code 1

Die Fehler der VMs bleiben gleich über den gesamten Zeitraum.

Ist es immer diese Datei/Meldung

Code:

tar: ./var/lib/postgresql/11/main/base/16385/94466: File shrank by 6717440 bytes; padding with zeros

wenn es fehlschlägt?

Nein es ist nicht immer die gleiche Datei.

Im Backup von heute Morgen waren es folgende Meldungen:

Code:

104: 2022-05-04 06:02:00 INFO: Starting Backup of VM 104 (lxc)

104: 2022-05-04 06:02:00 INFO: status = running

104: 2022-05-04 06:02:00 INFO: CT Name: PostgresDB

104: 2022-05-04 06:02:00 INFO: including mount point rootfs ('/') in backup

104: 2022-05-04 06:02:00 INFO: backup mode: snapshot

104: 2022-05-04 06:02:00 INFO: ionice priority: 7

104: 2022-05-04 06:02:00 INFO: create storage snapshot 'vzdump'

104: 2022-05-04 06:02:01 INFO: creating vzdump archive '/mnt/pve/ExtSSD512/dump/vzdump-lxc-104-2022_05_04-06_02_00.tar.zst'

104: 2022-05-04 06:02:48 INFO: tar: ./var/lib/postgresql/11/main/base/16385/148067: File shrank by 2220032 bytes; padding with zeros

104: 2022-05-04 06:03:09 INFO: tar: ./var/lib/postgresql/11/main/base/16385/131989: File shrank by 52645888 bytes; padding with zeros

104: 2022-05-04 06:03:22 INFO: tar: ./var/lib/postgresql/11/main/base/16385/142466: File shrank by 14880768 bytes; padding with zeros

104: 2022-05-04 06:04:04 INFO: tar: ./var/lib/postgresql/11/main/base/16385/90586: File shrank by 7774208 bytes; padding with zeros

104: 2022-05-04 06:04:15 INFO: Total bytes written: 30287482880 (29GiB, 216MiB/s)

104: 2022-05-04 06:04:16 INFO: cleanup temporary 'vzdump' snapshot

104: 2022-05-04 06:04:16 ERROR: Backup of VM 104 failed - command 'set -o pipefail && tar cpf - --totals --one-file-system -p --sparse --numeric-owner --acls --xattrs '--xattrs-include=user.*' '--xattrs-include=security.capability' '--warning=no-file-ignored' '--warning=no-xattr-write' --one-file-system '--warning=no-file-ignored' '--directory=/mnt/pve/ExtSSD512/dump/vzdump-lxc-104-2022_05_04-06_02_00.tmp' ./etc/vzdump/pct.conf ./etc/vzdump/pct.fw '--directory=/mnt/vzsnap0' --no-anchored '--exclude=lost+found' --anchored '--exclude=./tmp/?*' '--exclude=./var/tmp/?*' '--exclude=./var/run/?*.pid' ./ | zstd --rsyncable '--threads=1' >/mnt/pve/ExtSSD512/dump/vzdump-lxc-104-2022_05_04-06_02_00.tar.dat' failed: exit code 1

Gibt es irgendwelche Meldungen in /var/log/syslog während die Backups laufen bzw. fehlschlagen?

Hier der Auszug aus dem Syslog im Vergleich zum Backup Log

Das geschieht beim Backup von ID 104 in der Syslog:

Code:

tail -f /var/log/syslog

May 4 22:49:01 AzProxmox pvedaemon[875]: worker 2007349 started

May 4 22:49:09 AzProxmox systemd[1]: Started Session 53627 of user root.

May 4 22:49:09 AzProxmox systemd[1]: session-53627.scope: Succeeded.

May 4 22:49:38 AzProxmox pvedaemon[1933171]: <root@pam> successful auth for user 'root@pam'

May 4 22:49:54 AzProxmox systemd[1]: Started Session 53632 of user root.

May 4 22:49:54 AzProxmox systemd[1]: session-53632.scope: Succeeded.

May 4 22:49:59 AzProxmox systemd[1]: Started Session 53633 of user root.

May 4 22:49:59 AzProxmox systemd[1]: session-53633.scope: Succeeded.

May 4 22:50:09 AzProxmox systemd[1]: Started Session 53635 of user root.

May 4 22:50:09 AzProxmox systemd[1]: session-53635.scope: Succeeded.

May 4 22:50:36 AzProxmox pvedaemon[2011225]: starting lxc termproxy UPID:AzProxmox:001EB059:024A4416:6272E71C:vncproxy:104:root@pam:

May 4 22:50:36 AzProxmox pvedaemon[1933171]: <root@pam> starting task UPID:AzProxmox:001EB059:024A4416:6272E71C:vncproxy:104:root@pam:

May 4 22:50:37 AzProxmox pvedaemon[1933794]: <root@pam> successful auth for user 'root@pam'

May 4 22:50:41 AzProxmox pvedaemon[1933171]: <root@pam> end task UPID:AzProxmox:001EB059:024A4416:6272E71C:vncproxy:104:root@pam: OK

May 4 22:50:54 AzProxmox systemd[1]: Started Session 53640 of user root.

May 4 22:50:54 AzProxmox systemd[1]: session-53640.scope: Succeeded.

May 4 22:50:56 AzProxmox pvedaemon[1933171]: <root@pam> starting task UPID:AzProxmox:001EB32A:024A4B90:6272E730:vzdump:104:root@pam:

May 4 22:50:56 AzProxmox pvedaemon[2011946]: INFO: starting new backup job: vzdump 104 --storage Prxmx-Backup-ExtHDD2TB --remove 0 --mode snapshot --node AzProxmox

May 4 22:50:56 AzProxmox pvedaemon[2011946]: INFO: Starting Backup of VM 104 (lxc)

May 4 22:50:56 AzProxmox dmeventd[450]: No longer monitoring thin pool prxmx_vg-data_lv-tpool.

May 4 22:50:56 AzProxmox lvm[450]: Monitoring thin pool prxmx_vg-data_lv-tpool.

May 4 22:50:59 AzProxmox systemd[1]: Started Session 53641 of user root.

May 4 22:50:59 AzProxmox systemd[1]: session-53641.scope: Succeeded.

May 4 22:51:01 AzProxmox pvedaemon[1933794]: worker exit

May 4 22:51:01 AzProxmox pvedaemon[875]: worker 1933794 finished

May 4 22:51:01 AzProxmox pvedaemon[875]: starting 1 worker(s)

May 4 22:51:01 AzProxmox pvedaemon[875]: worker 2012103 started

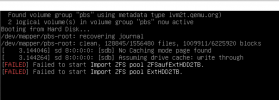

May 4 22:51:02 AzProxmox kernel: [384239.024857] blk_update_request: critical medium error, dev nvme0n1, sector 151851336 op 0x0:(READ) flags 0x80700 phys_seg 10 prio class 0

May 4 22:51:09 AzProxmox systemd[1]: Started Session 53642 of user root.

May 4 22:51:09 AzProxmox systemd[1]: session-53642.scope: Succeeded.

May 4 22:51:16 AzProxmox pvedaemon[2011946]: ERROR: Backup of VM 104 failed - command '/usr/bin/proxmox-backup-client backup '--crypt-mode=none' pct.conf:/var/tmp/vzdumptmp2011946_104/etc/vzdump/pct.conf root.pxar:/mnt/vzsnap0 --include-dev /mnt/vzsnap0/./ --skip-lost-and-found '--exclude=/tmp/?*' '--exclude=/var/tmp/?*' '--exclude=/var/run/?*.pid' --backup-type ct --backup-id 104 --backup-time 1651697456 --repository root@pam@192.168.0.238:ExtHDD2TB' failed: exit code 255

May 4 22:51:16 AzProxmox pvedaemon[2011946]: INFO: Backup job finished with errors

May 4 22:51:16 AzProxmox pvedaemon[2011946]: job errors

May 4 22:51:16 AzProxmox pvedaemon[1933171]: <root@pam> end task UPID:AzProxmox:001EB32A:024A4B90:6272E730:vzdump:104:root@pam: job errors

May 4 22:51:46 AzProxmox pvedaemon[1933171]: worker exit

May 4 22:51:46 AzProxmox pvedaemon[875]: worker 1933171 finished

May 4 22:51:46 AzProxmox pvedaemon[875]: starting 1 worker(s)

May 4 22:51:46 AzProxmox pvedaemon[875]: worker 2013922 started

Dies im Backup Log:

Code:

INFO: starting new backup job: vzdump 104 --storage Prxmx-Backup-ExtHDD2TB --remove 0 --mode snapshot --node AzProxmox

INFO: Starting Backup of VM 104 (lxc)

INFO: Backup started at 2022-05-04 22:50:56

INFO: status = running

INFO: CT Name: PostgresDB

INFO: including mount point rootfs ('/') in backup

INFO: backup mode: snapshot

INFO: ionice priority: 7

INFO: create storage snapshot 'vzdump'

WARNING: You have not turned on protection against thin pools running out of space.

WARNING: Set activation/thin_pool_autoextend_threshold below 100 to trigger automatic extension of thin pools before they get full.

Logical volume "snap_vm-104-disk-0_vzdump" created.

WARNING: Sum of all thin volume sizes (609.73 GiB) exceeds the size of thin pool prxmx_vg/data_lv and the amount of free space in volume group (414.95 GiB).

INFO: creating Proxmox Backup Server archive 'ct/104/2022-05-04T20:50:56Z'

INFO: run: /usr/bin/proxmox-backup-client backup --crypt-mode=none pct.conf:/var/tmp/vzdumptmp2011946_104/etc/vzdump/pct.conf root.pxar:/mnt/vzsnap0 --include-dev /mnt/vzsnap0/./ --skip-lost-and-found --exclude=/tmp/?* --exclude=/var/tmp/?* --exclude=/var/run/?*.pid --backup-type ct --backup-id 104 --backup-time 1651697456 --repository root@pam@192.168.0.238:ExtHDD2TB

INFO: Starting backup: ct/104/2022-05-04T20:50:56Z

INFO: Client name: AzProxmox

INFO: Starting backup protocol: Wed May 4 22:50:56 2022

INFO: Downloading previous manifest (Tue May 3 04:02:09 2022)

INFO: Upload config file '/var/tmp/vzdumptmp2011946_104/etc/vzdump/pct.conf' to 'root@pam@192.168.0.238:8007:ExtHDD2TB' as pct.conf.blob

INFO: Upload directory '/mnt/vzsnap0' to 'root@pam@192.168.0.238:8007:ExtHDD2TB' as root.pxar.didx

INFO: catalog upload error - channel closed

INFO: Error: error at "var/lib/postgresql/11/main/base/16385/129138": Input/output error (os error 5)

INFO: cleanup temporary 'vzdump' snapshot

Logical volume "snap_vm-104-disk-0_vzdump" successfully removed

ERROR: Backup of VM 104 failed - command '/usr/bin/proxmox-backup-client backup '--crypt-mode=none' pct.conf:/var/tmp/vzdumptmp2011946_104/etc/vzdump/pct.conf root.pxar:/mnt/vzsnap0 --include-dev /mnt/vzsnap0/./ --skip-lost-and-found '--exclude=/tmp/?*' '--exclude=/var/tmp/?*' '--exclude=/var/run/?*.pid' --backup-type ct --backup-id 104 --backup-time 1651697456 --repository root@pam@192.168.0.238:ExtHDD2TB' failed: exit code 255

INFO: Failed at 2022-05-04 22:51:16

INFO: Backup job finished with errors

TASK ERROR: job errors

Bitte auch mal den Thin Pool und die darunter liegende Hardware überprüfen.

Kannst Du mir sagen wie ich das mache? Leider weiß ich hier nicht wie ich das anstellen soll.

Sorry für den unglaublich vielen Text, ich hoffe Du hast überhaupt die Zeit Dir das durchzusehen.

Viele Grüße

Alexander