Hallo,

Ich habe gerade zwei Nodes mit je der aktuellen Version Proxmox Version

Ich habe bei der Installation auf dem Ethernet Adapter folgende IP Adressen vergeben PVE01 172.16.1.101 und PVE03 172.16.1.103.

Nach der Installation habe ich bei beiden Nodes ein Bond auf das LWL Interface gemacht und die IP Adressen PVE01 10.200.10.101 und PVE03 10.200.10.103 vergeben.

Ich kann beide Nodes pingen auf beiden IP Adressen.

Zusätzlich habe ich eine VM auf einem NFS Share liegen.

Bei der Live Migration erhalte ich folgende Ausgabe

Der RAM sollte doch deutlich schneller als mit rund 120MiB/s übertragen werden

Der Switch meint, dass da mehr gehen müsste

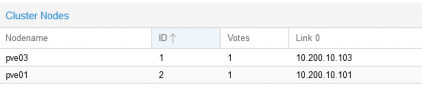

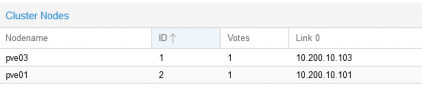

Hier die Cluster Join information

So Sieht das Netzwerksetup aus

Da ja eigentlich auch der Link für das Clustermanagement hergestellt wird, gehe ich eigentlich davon aus, dass wenn ich die Verbindung 172.16.1.103 trenne. Über das Webinterface von 172.16.1.103 auch den anderen Node steuern kann.

Dem ist nicht so. "Kein Route zum Host"

Dass das Interface selbst und die VMs nicht erreichbar sind ist klar.

Hier noch die Netzwerkmessung

Gut bei dem 10er Netz hätte ich jetzt die doppelte Geschindigkeit erwartet.

Hat jemand für mich eine Idee wo ich da ansetzten kann?

Ich habe gerade zwei Nodes mit je der aktuellen Version Proxmox Version

Ich habe bei der Installation auf dem Ethernet Adapter folgende IP Adressen vergeben PVE01 172.16.1.101 und PVE03 172.16.1.103.

Nach der Installation habe ich bei beiden Nodes ein Bond auf das LWL Interface gemacht und die IP Adressen PVE01 10.200.10.101 und PVE03 10.200.10.103 vergeben.

Ich kann beide Nodes pingen auf beiden IP Adressen.

Zusätzlich habe ich eine VM auf einem NFS Share liegen.

Bei der Live Migration erhalte ich folgende Ausgabe

Die angezeigte Geschwindigkeit erweckt in mir den Verdacht, dass die Daten über das flasche Interface geschickt werden.2022-12-23 18:22:29 starting migration of VM 116 to node 'pve01' (172.16.1.101)

2022-12-23 18:22:29 starting VM 116 on remote node 'pve01'

2022-12-23 18:22:30 start remote tunnel

2022-12-23 18:22:31 ssh tunnel ver 1

2022-12-23 18:22:31 starting online/live migration on unix:/run/qemu-server/116.migrate

2022-12-23 18:22:31 set migration capabilities

2022-12-23 18:22:31 migration downtime limit: 100 ms

2022-12-23 18:22:31 migration cachesize: 1.0 GiB

2022-12-23 18:22:31 set migration parameters

2022-12-23 18:22:31 start migrate command to unix:/run/qemu-server/116.migrate

2022-12-23 18:22:32 migration active, transferred 112.3 MiB of 8.0 GiB VM-state, 112.7 MiB/s

2022-12-23 18:22:33 migration active, transferred 224.6 MiB of 8.0 GiB VM-state, 119.2 MiB/s

2022-12-23 18:22:34 migration active, transferred 337.3 MiB of 8.0 GiB VM-state, 150.1 MiB/s

2022-12-23 18:22:35 migration active, transferred 449.3 MiB of 8.0 GiB VM-state, 115.8 MiB/s

2022-12-23 18:22:36 migration active, transferred 561.5 MiB of 8.0 GiB VM-state, 134.3 MiB/s

2022-12-23 18:22:37 migration active, transferred 669.4 MiB of 8.0 GiB VM-state, 1.2 GiB/s

2022-12-23 18:22:38 migration active, transferred 781.9 MiB of 8.0 GiB VM-state, 114.8 MiB/s

2022-12-23 18:22:39 migration active, transferred 893.5 MiB of 8.0 GiB VM-state, 115.8 MiB/s

2022-12-23 18:22:40 migration active, transferred 1005.4 MiB of 8.0 GiB VM-state, 111.7 MiB/s

2022-12-23 18:22:41 migration active, transferred 1.1 GiB of 8.0 GiB VM-state, 111.7 MiB/s

2022-12-23 18:22:42 migration active, transferred 1.2 GiB of 8.0 GiB VM-state, 111.7 MiB/s

2022-12-23 18:22:43 migration active, transferred 1.3 GiB of 8.0 GiB VM-state, 114.8 MiB/s

2022-12-23 18:22:44 migration active, transferred 1.4 GiB of 8.0 GiB VM-state, 202.3 MiB/s

2022-12-23 18:22:45 migration active, transferred 1.5 GiB of 8.0 GiB VM-state, 112.7 MiB/s

2022-12-23 18:22:46 migration active, transferred 1.6 GiB of 8.0 GiB VM-state, 114.8 MiB/s

2022-12-23 18:22:47 migration active, transferred 1.7 GiB of 8.0 GiB VM-state, 114.8 MiB/s

2022-12-23 18:22:48 migration active, transferred 1.9 GiB of 8.0 GiB VM-state, 114.9 MiB/s

2022-12-23 18:22:49 migration active, transferred 2.0 GiB of 8.0 GiB VM-state, 117.0 MiB/s

2022-12-23 18:22:50 migration active, transferred 2.1 GiB of 8.0 GiB VM-state, 114.8 MiB/s

2022-12-23 18:22:51 migration active, transferred 2.2 GiB of 8.0 GiB VM-state, 1.2 GiB/s

2022-12-23 18:22:52 migration active, transferred 2.3 GiB of 8.0 GiB VM-state, 589.4 MiB/s

2022-12-23 18:22:53 migration active, transferred 2.4 GiB of 8.0 GiB VM-state, 511.3 MiB/s

2022-12-23 18:22:54 migration active, transferred 2.5 GiB of 8.0 GiB VM-state, 116.0 MiB/s

2022-12-23 18:22:55 migration active, transferred 2.6 GiB of 8.0 GiB VM-state, 114.8 MiB/s

2022-12-23 18:22:56 migration active, transferred 2.7 GiB of 8.0 GiB VM-state, 116.0 MiB/s

2022-12-23 18:22:57 migration active, transferred 2.8 GiB of 8.0 GiB VM-state, 117.0 MiB/s

2022-12-23 18:22:58 migration active, transferred 2.9 GiB of 8.0 GiB VM-state, 111.7 MiB/s

2022-12-23 18:22:59 migration active, transferred 3.1 GiB of 8.0 GiB VM-state, 114.8 MiB/s

2022-12-23 18:23:00 migration active, transferred 3.2 GiB of 8.0 GiB VM-state, 111.7 MiB/s

2022-12-23 18:23:01 migration active, transferred 3.3 GiB of 8.0 GiB VM-state, 113.7 MiB/s

2022-12-23 18:23:02 migration active, transferred 3.4 GiB of 8.0 GiB VM-state, 112.7 MiB/s

2022-12-23 18:23:03 migration active, transferred 3.5 GiB of 8.0 GiB VM-state, 114.8 MiB/s

2022-12-23 18:23:04 migration active, transferred 3.6 GiB of 8.0 GiB VM-state, 114.8 MiB/s

2022-12-23 18:23:05 migration active, transferred 3.7 GiB of 8.0 GiB VM-state, 112.7 MiB/s

2022-12-23 18:23:07 average migration speed: 228.0 MiB/s - downtime 20 ms

2022-12-23 18:23:07 migration status: completed

2022-12-23 18:23:10 migration finished successfully (duration 00:00:41)

TASK OK

Der RAM sollte doch deutlich schneller als mit rund 120MiB/s übertragen werden

Der Switch meint, dass da mehr gehen müsste

Po1 "PVE01" connected 1 full 40G N/A

Po2 "PVE02" connected 1 full 20G N/A

Po3 "PVE03" connected 1 full 20G N/A

Hier die Cluster Join information

So Sieht das Netzwerksetup aus

Da ja eigentlich auch der Link für das Clustermanagement hergestellt wird, gehe ich eigentlich davon aus, dass wenn ich die Verbindung 172.16.1.103 trenne. Über das Webinterface von 172.16.1.103 auch den anderen Node steuern kann.

Dem ist nicht so. "Kein Route zum Host"

Dass das Interface selbst und die VMs nicht erreichbar sind ist klar.

Hier noch die Netzwerkmessung

root@pve01:~# iperf -c 10.200.10.103

------------------------------------------------------------

Client connecting to 10.200.10.103, TCP port 5001

TCP window size: 85.0 KByte (default)

------------------------------------------------------------

[ 3] local 10.200.10.101 port 39620 connected with 10.200.10.103 port 5001

[ ID] Interval Transfer Bandwidth

[ 3] 0.0000-10.0009 sec 10.9 GBytes 9.39 Gbits/sec

über das "normale" Netz kommt man mit 943Mbits/sec so ziehmlich genau auf 117MiB/sroot@pve01:~# iperf -c 172.16.1.103

------------------------------------------------------------

Client connecting to 172.16.1.103, TCP port 5001

TCP window size: 85.0 KByte (default)

------------------------------------------------------------

[ 3] local 172.16.1.101 port 59676 connected with 172.16.1.103 port 5001

[ ID] Interval Transfer Bandwidth

[ 3] 0.0000-10.0047 sec 1.10 GBytes 943 Mbits/sec

Gut bei dem 10er Netz hätte ich jetzt die doppelte Geschindigkeit erwartet.

Hat jemand für mich eine Idee wo ich da ansetzten kann?

Last edited: