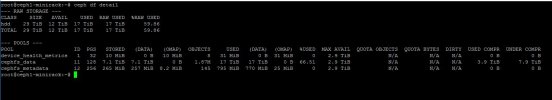

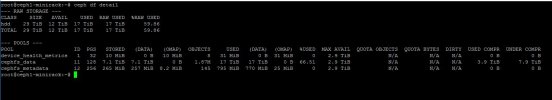

Wir haben einen "Labor" Ceph Object Storage, welcher aus einem 4x-Multinode-Server und den folgenden Node-Komponenten besteht:

Pro Node:

Der Ceph Cluster besteht aus (2x 4 TB pro Knoten) x4 = insgesamt 8 OSDs mit 32 TB Bruttokapazität.

Der cephfs_data Pool wird mit LZ4 unter aggressiv komprimiert.

Der Zugriff auf den Ceph Speicher erfolgt ausschließlich über eine "Samba-to-Ceph" VM (Debian 11 basierend) auf einem entfernten Proxmox-Knoten, der den cephfs Pool unter /ceph-data gemountet hat und ihn über Samba (als Active Directory Domain Member) für die Dateiablage als Archivsystem bereitstellt.

root@samba-to-ceph:~# tail -n 6 /etc/fstab

### ### ###

#// Mini-Rack Ceph Object Storage

172.16.100.11:6789,172.16.100.12:6789,172.16.100.13:6789,172.16.100.14:6789:/ /ceph-data ceph name=admin,secret="SECRET",noatime,acl,_netdev 0 2

### ### ###

# EOF

root@samba-to-ceph:~#

Bis zur 60%igen Poolbelegung war der SMB-Zugriff mit durchschnittlich 120-130 MB/s beim Kopieren unter einer Windows Client VM (mittels der Samba-To-Ceph-VM) performant.

Nach dem letzten Scrub scheint die gesamte Ceph-Performance jedoch stark eingebrochen zu sein!

!!!! Die Schreibleistung liegt jetzt im Bereich von 200-300 Kbit/s !!!!

Der RAM ist komplett ausgelastet (ca. 50% ist CACHED)

Auch der SWAP wird immer voller.

... nach viel Debugging ...

!!!! Um die normale Performance wiederherzustellen, half eine Bereinigung des PageCache und eine SWAP Bereinigung !!!!

root@ceph1-minirack:~#

root@ceph1-minirack:~# sync; echo 1 > /proc/sys/vm/drop_caches

root@ceph1-minirack:~#

root@ceph1-minirack:~# swapoff -a

root@ceph1-minirack:~#

root@ceph1-minirack:~# swapon /dev/zram0 -p 10

root@ceph1-minirack:~#

root@ceph1-minirack:~# free

total used free shared buff/cache available

Mem: 24656724 11893748 12400936 71968 362040 12346804

Swap: 1048572 0 1048572

root@ceph1-minirack:~#

Was wäre eine dauerhafte Lösung für dieses Phänomen?

Welche Parameter im Linux-Kernel? Proxmox? oder Ceph selbst? müssen angepasst werden?

Pro Node:

- PVE Manager Version pve-manager/7.1-7/df5740ad

- Kernel Version Linux 5.13.19-2-pve #1 SMP PVE 5.13.19-4 (Mon, 29 Nov 2021 12:10:09 +0100)

- 24 x Intel(R) Xeon(R) CPU X5675 @ 3.07GHz (2 Sockets)

- RAM usage 48.34% (11.37 GiB of 23.51 GiB)

- SWAP usage 0.00% (0 B of 1024.00 MiB) - ZRAM

- / HD space 0.07% (2.58 GiB of 3.51 TiB) - ZFS (Root)

- SATA - 2x 4 TB Ceph OSDs

- Ceph Cluster Network - 1 Gbit - 9000 MTU

- Proxmox Cluster / Ceph Mon. - 1 Gbit - 1500 MTU

Der Ceph Cluster besteht aus (2x 4 TB pro Knoten) x4 = insgesamt 8 OSDs mit 32 TB Bruttokapazität.

Der cephfs_data Pool wird mit LZ4 unter aggressiv komprimiert.

Der Zugriff auf den Ceph Speicher erfolgt ausschließlich über eine "Samba-to-Ceph" VM (Debian 11 basierend) auf einem entfernten Proxmox-Knoten, der den cephfs Pool unter /ceph-data gemountet hat und ihn über Samba (als Active Directory Domain Member) für die Dateiablage als Archivsystem bereitstellt.

root@samba-to-ceph:~# tail -n 6 /etc/fstab

### ### ###

#// Mini-Rack Ceph Object Storage

172.16.100.11:6789,172.16.100.12:6789,172.16.100.13:6789,172.16.100.14:6789:/ /ceph-data ceph name=admin,secret="SECRET",noatime,acl,_netdev 0 2

### ### ###

# EOF

root@samba-to-ceph:~#

Bis zur 60%igen Poolbelegung war der SMB-Zugriff mit durchschnittlich 120-130 MB/s beim Kopieren unter einer Windows Client VM (mittels der Samba-To-Ceph-VM) performant.

Nach dem letzten Scrub scheint die gesamte Ceph-Performance jedoch stark eingebrochen zu sein!

!!!! Die Schreibleistung liegt jetzt im Bereich von 200-300 Kbit/s !!!!

Der RAM ist komplett ausgelastet (ca. 50% ist CACHED)

Auch der SWAP wird immer voller.

... nach viel Debugging ...

!!!! Um die normale Performance wiederherzustellen, half eine Bereinigung des PageCache und eine SWAP Bereinigung !!!!

root@ceph1-minirack:~#

root@ceph1-minirack:~# sync; echo 1 > /proc/sys/vm/drop_caches

root@ceph1-minirack:~#

root@ceph1-minirack:~# swapoff -a

root@ceph1-minirack:~#

root@ceph1-minirack:~# swapon /dev/zram0 -p 10

root@ceph1-minirack:~#

root@ceph1-minirack:~# free

total used free shared buff/cache available

Mem: 24656724 11893748 12400936 71968 362040 12346804

Swap: 1048572 0 1048572

root@ceph1-minirack:~#

Was wäre eine dauerhafte Lösung für dieses Phänomen?

Welche Parameter im Linux-Kernel? Proxmox? oder Ceph selbst? müssen angepasst werden?