Hallo zusammen

ich bin aktuell am überlegen von meiner ESXi Struktur hin zu Proxmox zu wechseln.

Jedoch bin ich mir nicht ganz sicher ob dies überhaupt möglich ist....

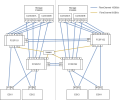

Ich habe hier eine Hochverfügbare Struktur mit 2 Storages, 4 SAN Switchen und 4 ESXi-Hosts. Alles zusammen sind via 16GBit/s FibreChannel verbunden.

Habe es hier einmal Visualisiert:

Die Linke und die Rechte Hälfte sind zudem in unterschiedlichen Gebäuden. Aber das macht ja an der Logik nichts.

Die beiden Storages sind gespiegelt. Was links drauf ist, ist auch rechts drauf und umgekehrt. Darum kümmert sich die Storage. Aktuell werden die Daten auch von über beide Storages bezogen (Aktiv - Aktiv)

Aktuell haben wir 3 LUNs angelegt welche via FibreChannel entsprechend an den Hosts ankommen.

Nun überlegen wir ob wir das ganze auch irgendwie mit Proxmox hinbekommen....

Wir hatten oder brauchen gerne folgende Funktionen:

ich bin aktuell am überlegen von meiner ESXi Struktur hin zu Proxmox zu wechseln.

Jedoch bin ich mir nicht ganz sicher ob dies überhaupt möglich ist....

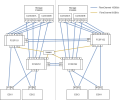

Ich habe hier eine Hochverfügbare Struktur mit 2 Storages, 4 SAN Switchen und 4 ESXi-Hosts. Alles zusammen sind via 16GBit/s FibreChannel verbunden.

Habe es hier einmal Visualisiert:

Die Linke und die Rechte Hälfte sind zudem in unterschiedlichen Gebäuden. Aber das macht ja an der Logik nichts.

Die beiden Storages sind gespiegelt. Was links drauf ist, ist auch rechts drauf und umgekehrt. Darum kümmert sich die Storage. Aktuell werden die Daten auch von über beide Storages bezogen (Aktiv - Aktiv)

Aktuell haben wir 3 LUNs angelegt welche via FibreChannel entsprechend an den Hosts ankommen.

Nun überlegen wir ob wir das ganze auch irgendwie mit Proxmox hinbekommen....

Wir hatten oder brauchen gerne folgende Funktionen:

- Snapshots

- Dateien sollen nur einmal rumliegen. Natürlich auf beiden gleichzeitig.