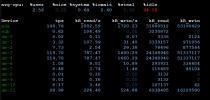

Ich komme für unseren Ceph Cluster (den HDD Teil) ebenfalls auf ca 60-80 iops.

Was ich aber nicht ganz verstehe, ist der Teil mit der Write amplification. Das macht aus meiner Sicht nur Sinn, wenn ich einen Storage habe, der redundant schreibt, oder z.B. die zu schreibenden Blockgrößen keine geraden Vielfachen der zugrundeliegenden Hardware-Blöcke sind.

Beispiel wäre eine HDD deren physical Blocksize 4096KB beträgt. Wenn man da ein VM Image drauf liegen hat, wo die VM mit einer Blocksize von 512B arbeitet, muss beim sequential write der physikalische Block im schlimmsten Fall 8x beschrieben werden, wobei das nur bei direct IO so passiert. Ansonsten wird durch NCQ und HDD Cache sowas in der Regel abgefangen und ein solcher Sektor nur einmal beschrieben. Bei random writes haut das aber richtig rein, weil der Cache in solchen Fällen sowas gar nicht abfangen kann.

Die 7MB/s sind ziemlich sicher der Anbindung via IDE geschuldet. Das wird emuliert und ist daher sehr lahm. Ansonsten, wenn das die einzige VM ist und sonst da nichts läuft außer PVE, sollte das meiner Meinung nach nicht so einen derben Unterschied machen. PVE schreibt im ganz normalen Betrieb Logs lediglich in den RAM und erzeugt ansonsten auch kaum IO auf der Festplatte. Es bleibt also mehr oder weniger eigentlich alles an IO für deine VM übrig.

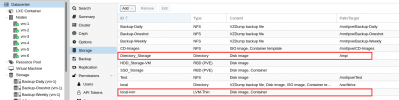

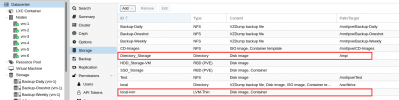

Es bleibt noch die Frage wie dein Storage bei PVE eingehängt ist. Wird das VM Disk Image auf dem Dateisystem als Datei abgelegt, oder nutzt der HDD Storage via LVM direkt die Festplatte ohne Dateisystem?

Wenn die Images als Datei im Dateisystem abgelegt werden, dann ist das ein weiteres Performance Bottleneck, denn dann hast du den Overhead des Dateisystems noch. Beispielsweise wenn es ein ZFS oder ein BTRFS ist, das für den Storage herhalten muss, dann gibt es da natürlich auch nochmal Checksummen, Logs etc. die geschrieben werden müssen. Dann kannst du tatsächlich solche Write Amplification probleme bekommen.

Ich hab dir das mal als Beispiel hier eingefügt, damit du siehst wo du das findest

LVM ist für local storage auf jeden Fall zu bevorzugen, da es ohne Umweg über ein Dateisystem die Daten direkt in ein Logical Volume auf die Festplatte schreibt. Es kann daher die Festplatte mehr oder weniger direkt nutzen und erzeugt kaum overhead.