Moin zusammen,

bin ja gerade am Proxmox testen und haben mir einen Cluster aufgebaut.

Gerade (unbeabsichtigt) mal ein desasterrecovery scenario am durchspielen - sprich einen Server unbrauchbar gemacht und neu aufsetzen müssen

Der Server ist aber nicht ausgefallen und einfach vom Netz verschwunden - ich konnte noch shutdown triggern - muss aber final dann doch hart ausschalten.

Verwundert war ich dann, dass die VMs und LXCs in einer HA Gruppe einfach in den freeze zustand fallen Erwartet hätte ich, dass diese auf eine andere Maschine Migrieren und weiter laufen zumindest die, welche CEPH als shared storage haben.

Erwartet hätte ich, dass diese auf eine andere Maschine Migrieren und weiter laufen zumindest die, welche CEPH als shared storage haben.

Das scheint aber per design nicht so zu sein. OK sei's drum aber die GUI bietet auch nicht an diese einfach forced zu migrieren (migrieren gibt es ja nur auf dem host und der ist offline). Wie ist dann das procedere, wenn man den Host nicht online bringen kann?

Ich habe dann den Host komplett neu aufgesetzt und wieder forced in den cluster eingefügt (gleicher name). Dann wurden zumindest die VMs auf dem CEPH neu gestartet.

Probleme habe ich noch mit einem local-directory storage. Zweite SSD die in allen Servern steckt und als Storage auf allen zu Verfügung gestellt wurde. Das Storage ist auch in storage.cfg drin. Aber der eigentliche mountpoint fehlt mir noch.

durch vergleich mit einem der anderen server müsste das durch

Was mich noch irritiiert hat: EIne Migration von VMs von dem Server war nicht möglich mit dem Begründung local-directory wäre nicht da. Wenn die VM dort gespeichert gewesen wäre, hätte ich es verstanden, aber die Resourcen waren alle auf dem CEPH. Warum sollte also ein wegmigrieren dann nicht gehen? Nachdem local-directory wieder online war ging MIgrieren von allen Maschinen wieder.

BTW: ja ich habe auch ein Backup - aber ich möchte das einmal manuell machen um im Fall des Falles dann auch gewappnet zu sein.

bin ja gerade am Proxmox testen und haben mir einen Cluster aufgebaut.

Gerade (unbeabsichtigt) mal ein desasterrecovery scenario am durchspielen - sprich einen Server unbrauchbar gemacht und neu aufsetzen müssen

Der Server ist aber nicht ausgefallen und einfach vom Netz verschwunden - ich konnte noch shutdown triggern - muss aber final dann doch hart ausschalten.

Verwundert war ich dann, dass die VMs und LXCs in einer HA Gruppe einfach in den freeze zustand fallen

Das scheint aber per design nicht so zu sein. OK sei's drum aber die GUI bietet auch nicht an diese einfach forced zu migrieren (migrieren gibt es ja nur auf dem host und der ist offline). Wie ist dann das procedere, wenn man den Host nicht online bringen kann?

Ich habe dann den Host komplett neu aufgesetzt und wieder forced in den cluster eingefügt (gleicher name). Dann wurden zumindest die VMs auf dem CEPH neu gestartet.

Probleme habe ich noch mit einem local-directory storage. Zweite SSD die in allen Servern steckt und als Storage auf allen zu Verfügung gestellt wurde. Das Storage ist auch in storage.cfg drin. Aber der eigentliche mountpoint fehlt mir noch.

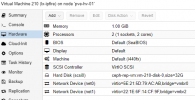

root@pve-hv-02:/media/chia-21# pvesm status

unable to activate storage 'local-directory' - directory is expected to be a mount point but is not mounted: '/mnt/pve/local-directory'

Name Type Status Total Used Available %

ceph-rep-vm rbd active 4904463834 741848538 4162615296 15.13%

local dir active 98497780 3580844 89867388 3.64%

local-directory dir inactive 0 0 0 0.00%

local-lvm lvmthin active 833396736 83339 833313396 0.01%

nfs-nas-01 nfs active 19394419712 7041923072 12352496640 36.31%

pve-hv-04-pbs-01 pbs active 9630100224 992202496 8637897728 10.30%

smb-nas-01 cifs active 19394419712 7041923072 12352496640 36.31%

durch vergleich mit einem der anderen server müsste das durch

erledigt werden - sehe ich das korrekt? oder muss ich noch an anderer Stelle nachpflegen. Zumindest scheint nach entsprechender Anpassung das System wieder zu funktionieren.root@pve-hv-01:/etc/systemd/system# cat 'mnt-pve-local\x2ddirectory.mount'

[Install]

WantedBy=multi-user.target

[Mount]

Options=defaults

Type=ext4

What=/dev/disk/by-uuid/3d9cb2aa-a5c2-4ccf-87c0-d2385a1cca73

Where=/mnt/pve/local-directory

[Unit]

Description=Mount storage 'local-directory' under /mnt/pve

Was mich noch irritiiert hat: EIne Migration von VMs von dem Server war nicht möglich mit dem Begründung local-directory wäre nicht da. Wenn die VM dort gespeichert gewesen wäre, hätte ich es verstanden, aber die Resourcen waren alle auf dem CEPH. Warum sollte also ein wegmigrieren dann nicht gehen? Nachdem local-directory wieder online war ging MIgrieren von allen Maschinen wieder.

BTW: ja ich habe auch ein Backup - aber ich möchte das einmal manuell machen um im Fall des Falles dann auch gewappnet zu sein.

Last edited: