Hallo,

ich habe ein kleines Problem, welches ich entweder nicht verstehe oder beheben kann.

Ich habe zwei ProxmoxVE Server, einen Hauptserver und einer als Notsystem, für die wichtigen VMs/LXCs.

Damit das Notsystem schnell einsatzbereit ist, kopiere ich zu unterschiedlichen Zeiten die Backups und spiele diese auf das Notsystem zurück.

Soweit funktioniert das auch alles und das ist auch nicht der Punkt über den ich diskutieren, mich rechtfertigen möchte.

Das Problem um das es geht, ist die Geschwindigkeit beim direkten Kopieren von Dateien zwischen den beiden Servern.

Wenn ich mit den Clients auf die Samba Freigaben zugreife und Dateien kopiere, dann werden die mit den richtigen Geschwindigkeiten, entsprechend der Netzwerkverbindung, kopiert. Also mit dem 2,5 Gbit Netzwerk entspricht das diesem, wie auch beim 10 Gbit, auch Iperf3 sagt, dass alles passt.

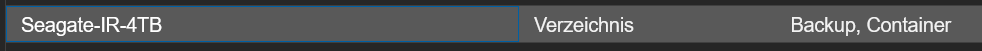

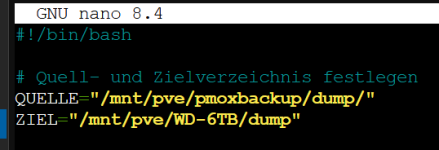

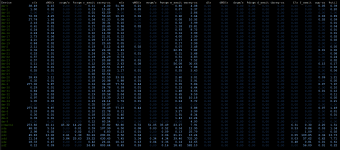

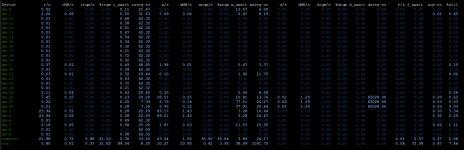

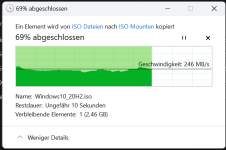

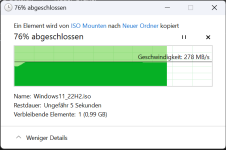

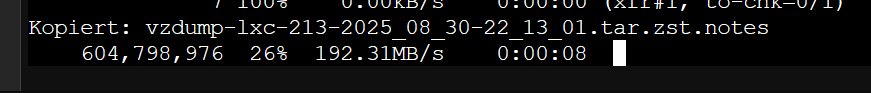

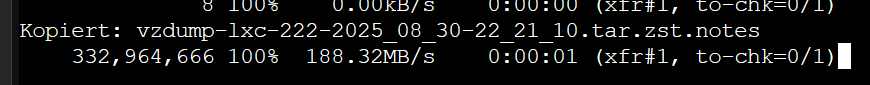

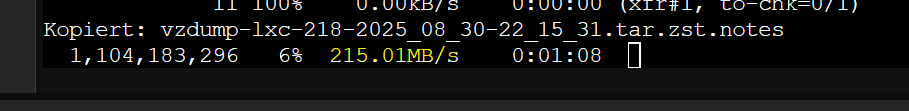

Wenn jedoch die Backups vom PVE0 (10 Gbit) auf den PVE1 (2,5 Gbit) kopiert werden, dann enspricht das nur einem 1 Gbit Netzwerk. Ich hatte auch im PVE1 eine baugleiche, vom selben Hersteller, 10 Gbit SFP Netzwerkkarte, also 10 Gbit zu 10 Gbit und trotzdem blieb es bei einer Kopiergeschwindigkeit wie auf dem Bild.

Warum werden die Daten zwischen den beiden so langsam kopiert?

Wie geschrieben, alle Geschwindigkeiten passen, nur diese Eine nicht, aber warum?

Danke.

ich habe ein kleines Problem, welches ich entweder nicht verstehe oder beheben kann.

Ich habe zwei ProxmoxVE Server, einen Hauptserver und einer als Notsystem, für die wichtigen VMs/LXCs.

Damit das Notsystem schnell einsatzbereit ist, kopiere ich zu unterschiedlichen Zeiten die Backups und spiele diese auf das Notsystem zurück.

Soweit funktioniert das auch alles und das ist auch nicht der Punkt über den ich diskutieren, mich rechtfertigen möchte.

Das Problem um das es geht, ist die Geschwindigkeit beim direkten Kopieren von Dateien zwischen den beiden Servern.

Wenn ich mit den Clients auf die Samba Freigaben zugreife und Dateien kopiere, dann werden die mit den richtigen Geschwindigkeiten, entsprechend der Netzwerkverbindung, kopiert. Also mit dem 2,5 Gbit Netzwerk entspricht das diesem, wie auch beim 10 Gbit, auch Iperf3 sagt, dass alles passt.

Wenn jedoch die Backups vom PVE0 (10 Gbit) auf den PVE1 (2,5 Gbit) kopiert werden, dann enspricht das nur einem 1 Gbit Netzwerk. Ich hatte auch im PVE1 eine baugleiche, vom selben Hersteller, 10 Gbit SFP Netzwerkkarte, also 10 Gbit zu 10 Gbit und trotzdem blieb es bei einer Kopiergeschwindigkeit wie auf dem Bild.

Warum werden die Daten zwischen den beiden so langsam kopiert?

Wie geschrieben, alle Geschwindigkeiten passen, nur diese Eine nicht, aber warum?

Danke.