Hallo zusammen,

habe folgendes Problem:

Ich habe einen ZFS Raid welches meine Filme und Serien beinhaltet. Jetzt ist es leider so, dass ich die letzte Zeit gemerkt habe das jellyfin etwas "humpelig" läuft.

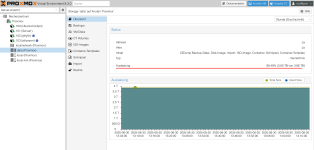

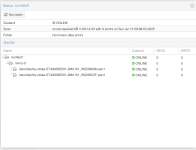

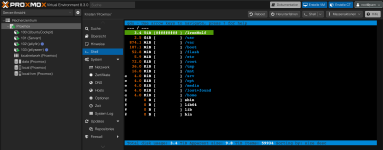

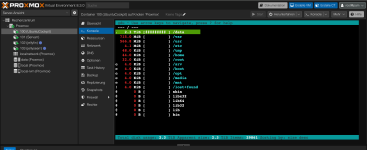

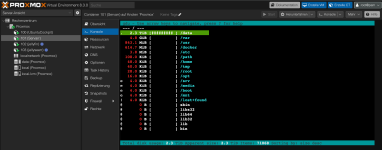

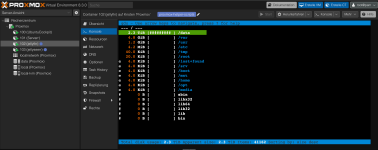

Als ich auf Proxmox nach dem möglichen Grund nachsah, fiel mir auf das die DATA HDD auf 100% voll war. Dachte ich OK Frau oder ich haben nicht aufgepasst und es mit

den Filmen und Serien etwas übertrieben...

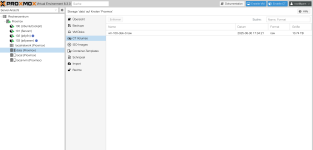

Also ein paar Serien und Filme von der Platte gelöscht. Allerdings ist diese immer noch voll laut der Proxmox Übersicht. Schaue ich allerdings speziell nach dem ZFS Pool stehen dort über 100 GB Frei.

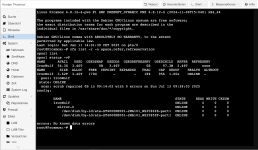

Irgendwas schreibt die DATA HDD voll und ich weiß leider nicht wie ich das herausfinden kann.

Wäre über jeden Ansatz oder Hilfestellung froh.

habe folgendes Problem:

Ich habe einen ZFS Raid welches meine Filme und Serien beinhaltet. Jetzt ist es leider so, dass ich die letzte Zeit gemerkt habe das jellyfin etwas "humpelig" läuft.

Als ich auf Proxmox nach dem möglichen Grund nachsah, fiel mir auf das die DATA HDD auf 100% voll war. Dachte ich OK Frau oder ich haben nicht aufgepasst und es mit

den Filmen und Serien etwas übertrieben...

Also ein paar Serien und Filme von der Platte gelöscht. Allerdings ist diese immer noch voll laut der Proxmox Übersicht. Schaue ich allerdings speziell nach dem ZFS Pool stehen dort über 100 GB Frei.

Irgendwas schreibt die DATA HDD voll und ich weiß leider nicht wie ich das herausfinden kann.

Wäre über jeden Ansatz oder Hilfestellung froh.