Hallo zusammen,

ich betreibe seit einer Woche erstmals 2 Proxmox-Nodes im einem Cluster und würde gern einen weiteren Node als Quorum (Raspberry Pi 3 Model B Rev 1.2) in den Verbund aufnehmen.

Dazu habe ich folgende Anleitung (auf Basis Debian Buster) umgesetzt (falls ich das richtig verstanden habe): https://pve.proxmox.com/wiki/Raspberry_Pi_as_third_node

1. /etc/corosync von Node1 auf Raspi kopiert

2. identische /etc/corosync.conf mit folgendem Inhalt auf allen 3 Geräten angelegt:

3. Restart quorum-Service

auf allen Nodes: fehlerfrei i.S.v es erfolgt keine Fehlerausgabe

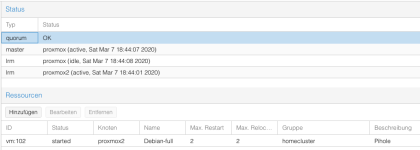

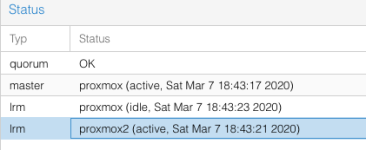

4. in der Serveransicht erscheint der neue Node auch, aber mit einem roten Kreuz

5. die /etc/hosts habe ich jeweils entsprechend angepasst

6. Bei der Fehleranalyse fällt mir auf, dass auf dem Node2 nach jedem Restart des quorum-Service der manuelle Eintrag der Node3-Parameter

gelöscht wird. Ich habe mehrfach versucht, die Nodes-Defintion hinzuzufügen, jedes Mals werden sie wieder gelöscht. Auf Nodes 1 und 3 bleiben sie erhalten. Der einzige für mich wahrnehmbare Unterschied zwischen Node1 und Node2 ist, dass ich auf Node 1 eine Subskription habe.

Woran könnte es liegen, dass ich den Raspi nicht hinzugefügt bekomme?

Hier noch ein paar Basisangaben:

Node1 :

Node 2:

Node 3:

System Node 1 und 2 identisch: ZBOX CI327 nano

Nutzlast Node 1: VM mit Centos7 und NethServer als Gateway, Firewall, Webproxy/Webfiler, LDAP, IPS,

Nutzlast Node 2: VM mit Debian Buster und Pihole als DNS-Server

Herzlichst, Marko

ich betreibe seit einer Woche erstmals 2 Proxmox-Nodes im einem Cluster und würde gern einen weiteren Node als Quorum (Raspberry Pi 3 Model B Rev 1.2) in den Verbund aufnehmen.

Dazu habe ich folgende Anleitung (auf Basis Debian Buster) umgesetzt (falls ich das richtig verstanden habe): https://pve.proxmox.com/wiki/Raspberry_Pi_as_third_node

1. /etc/corosync von Node1 auf Raspi kopiert

Code:

scp 192.168.3.200:/etc/corosync/* /etc/corosync2. identische /etc/corosync.conf mit folgendem Inhalt auf allen 3 Geräten angelegt:

Code:

logging {

debug: off

to_syslog: yes

}

nodelist {

node {

name: proxmox

nodeid: 1

quorum_votes: 1

ring0_addr: 192.168.3.200

}

node {

name: proxmox2

nodeid: 2

quorum_votes: 1

ring0_addr: 192.168.3.201

}

node {

name: proxmox3

nodeid: 3

quorum_votes: 1

ring0_addr: 192.168.3.203

}

}

quorum {

provider: corosync_votequorum

}

totem {

cluster_name: pvecluster

config_version: 2

interface {

linknumber: 0

}

ip_version: ipv4-6

secauth: on

version: 2

}3. Restart quorum-Service

Code:

systemctl restart corosync4. in der Serveransicht erscheint der neue Node auch, aber mit einem roten Kreuz

Fehler hostname lookup 'proxmox3' failed - failed to get address info for: proxmox3: Der Name oder der Dienst ist nicht bekannt (500)

5. die /etc/hosts habe ich jeweils entsprechend angepasst

Code:

root@proxmox3:/home/pi# cat /etc/hosts

127.0.0.1 localhost

::1 localhost ip6-localhost ip6-loopback

ff02::1 ip6-allnodes

ff02::2 ip6-allrouters

127.0.1.1 proxmox3

192.168.3.203 proxmox3.lan.home proxmox3

192.168.3.203 pvelocalhost

root@proxmox3:/home/pi#6. Bei der Fehleranalyse fällt mir auf, dass auf dem Node2 nach jedem Restart des quorum-Service der manuelle Eintrag der Node3-Parameter

Code:

}

node {

name: proxmox3

nodeid: 3

quorum_votes: 1

ring0_addr: 192.168.3.203

}Woran könnte es liegen, dass ich den Raspi nicht hinzugefügt bekomme?

Hier noch ein paar Basisangaben:

Node1 :

root@proxmox:~# corosync-quorumtool

Quorum information

------------------

Date: Sat Mar 7 15:05:00 2020

Quorum provider: corosync_votequorum

Nodes: 2

Node ID: 1

Ring ID: 1.118

Quorate: Yes

Votequorum information

----------------------

Expected votes: 3

Highest expected: 3

Total votes: 2

Quorum: 2

Flags: Quorate

Membership information

----------------------

Nodeid Votes Name

1 1 proxmox (local)

2 1 proxmox2

root@proxmox:~#

Quorum information

------------------

Date: Sat Mar 7 15:05:00 2020

Quorum provider: corosync_votequorum

Nodes: 2

Node ID: 1

Ring ID: 1.118

Quorate: Yes

Votequorum information

----------------------

Expected votes: 3

Highest expected: 3

Total votes: 2

Quorum: 2

Flags: Quorate

Membership information

----------------------

Nodeid Votes Name

1 1 proxmox (local)

2 1 proxmox2

root@proxmox:~#

root@proxmox2:~# corosync-quorumtool

Quorum information

------------------

Date: Sat Mar 7 15:07:15 2020

Quorum provider: corosync_votequorum

Nodes: 2

Node ID: 2

Ring ID: 1.118

Quorate: Yes

Votequorum information

----------------------

Expected votes: 3

Highest expected: 3

Total votes: 2

Quorum: 2

Flags: Quorate

Membership information

----------------------

Nodeid Votes Name

1 1 proxmox

2 1 proxmox2 (local)

root@proxmox2:~#

Quorum information

------------------

Date: Sat Mar 7 15:07:15 2020

Quorum provider: corosync_votequorum

Nodes: 2

Node ID: 2

Ring ID: 1.118

Quorate: Yes

Votequorum information

----------------------

Expected votes: 3

Highest expected: 3

Total votes: 2

Quorum: 2

Flags: Quorate

Membership information

----------------------

Nodeid Votes Name

1 1 proxmox

2 1 proxmox2 (local)

root@proxmox2:~#

root@proxmox3:/home/pi# corosync-quorumtool

Quorum information

------------------

Date: Sat Mar 7 15:08:59 2020

Quorum provider: corosync_votequorum

Nodes: 1

Node ID: 3

Ring ID: 3/36

Quorate: No

Votequorum information

----------------------

Expected votes: 3

Highest expected: 3

Total votes: 1

Quorum: 2 Activity blocked

Flags:

Membership information

----------------------

Nodeid Votes Name

3 1 proxmox3 (local)

root@proxmox3:/home/pi#

Quorum information

------------------

Date: Sat Mar 7 15:08:59 2020

Quorum provider: corosync_votequorum

Nodes: 1

Node ID: 3

Ring ID: 3/36

Quorate: No

Votequorum information

----------------------

Expected votes: 3

Highest expected: 3

Total votes: 1

Quorum: 2 Activity blocked

Flags:

Membership information

----------------------

Nodeid Votes Name

3 1 proxmox3 (local)

root@proxmox3:/home/pi#

proxmox-ve: 6.1-2 (running kernel: 5.3.18-2-pve)

pve-manager: 6.1-7 (running version: 6.1-7/13e58d5e)

pve-kernel-5.3: 6.1-5

pve-kernel-helper: 6.1-5

pve-kernel-5.3.18-2-pve: 5.3.18-2

pve-kernel-5.3.10-1-pve: 5.3.10-1

ceph-fuse: 12.2.11+dfsg1-2.1+b1

corosync: 3.0.3-pve1

criu: 3.11-3

glusterfs-client: 5.5-3

ifupdown: residual config

ifupdown2: 2.0.1-1+pve4

ksm-control-daemon: 1.3-1

libjs-extjs: 6.0.1-10

libknet1: 1.14-pve1

libpve-access-control: 6.0-6

libpve-apiclient-perl: 3.0-3

libpve-common-perl: 6.0-12

libpve-guest-common-perl: 3.0-3

libpve-http-server-perl: 3.0-4

libpve-storage-perl: 6.1-4

libqb0: 1.0.5-1

libspice-server1: 0.14.2-4~pve6+1

lvm2: 2.03.02-pve4

lxc-pve: 3.2.1-1

lxcfs: 3.0.3-pve60

novnc-pve: 1.1.0-1

proxmox-mini-journalreader: 1.1-1

proxmox-widget-toolkit: 2.1-3

pve-cluster: 6.1-4

pve-container: 3.0-19

pve-docs: 6.1-6

pve-edk2-firmware: 2.20191127-1

pve-firewall: 4.0-10

pve-firmware: 3.0-5

pve-ha-manager: 3.0-8

pve-i18n: 2.0-4

pve-qemu-kvm: 4.1.1-3

pve-xtermjs: 4.3.0-1

qemu-server: 6.1-6

smartmontools: 7.1-pve2

spiceterm: 3.1-1

vncterm: 1.6-1

zfsutils-linux: 0.8.3-pve1

root@proxmox:~#

pve-manager: 6.1-7 (running version: 6.1-7/13e58d5e)

pve-kernel-5.3: 6.1-5

pve-kernel-helper: 6.1-5

pve-kernel-5.3.18-2-pve: 5.3.18-2

pve-kernel-5.3.10-1-pve: 5.3.10-1

ceph-fuse: 12.2.11+dfsg1-2.1+b1

corosync: 3.0.3-pve1

criu: 3.11-3

glusterfs-client: 5.5-3

ifupdown: residual config

ifupdown2: 2.0.1-1+pve4

ksm-control-daemon: 1.3-1

libjs-extjs: 6.0.1-10

libknet1: 1.14-pve1

libpve-access-control: 6.0-6

libpve-apiclient-perl: 3.0-3

libpve-common-perl: 6.0-12

libpve-guest-common-perl: 3.0-3

libpve-http-server-perl: 3.0-4

libpve-storage-perl: 6.1-4

libqb0: 1.0.5-1

libspice-server1: 0.14.2-4~pve6+1

lvm2: 2.03.02-pve4

lxc-pve: 3.2.1-1

lxcfs: 3.0.3-pve60

novnc-pve: 1.1.0-1

proxmox-mini-journalreader: 1.1-1

proxmox-widget-toolkit: 2.1-3

pve-cluster: 6.1-4

pve-container: 3.0-19

pve-docs: 6.1-6

pve-edk2-firmware: 2.20191127-1

pve-firewall: 4.0-10

pve-firmware: 3.0-5

pve-ha-manager: 3.0-8

pve-i18n: 2.0-4

pve-qemu-kvm: 4.1.1-3

pve-xtermjs: 4.3.0-1

qemu-server: 6.1-6

smartmontools: 7.1-pve2

spiceterm: 3.1-1

vncterm: 1.6-1

zfsutils-linux: 0.8.3-pve1

root@proxmox:~#

System Node 1 und 2 identisch: ZBOX CI327 nano

Nutzlast Node 1: VM mit Centos7 und NethServer als Gateway, Firewall, Webproxy/Webfiler, LDAP, IPS,

Nutzlast Node 2: VM mit Debian Buster und Pihole als DNS-Server

Herzlichst, Marko

Last edited: