Hallo,

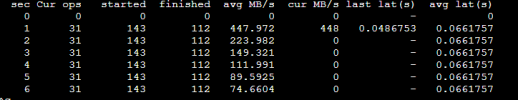

ich bin gerade dabei ein neues Ceph Cluster aufzusetzen, aber stelle da paar Probleme fest. Beim Benchmark fiel mir auf das die Werte weit weg von dem sind, was die Hardware eigentlich leisten sollte.

Zum Setup:

Drei Nodes

Epyc 7543P

512Gb RAM

Mellanox ConnectX6 100Gbit

Broadcom P225P 10/25Gbit

4x Samsung PM9A3

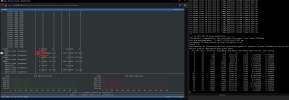

Die beiden Ports der Mellanox sind jeweils mit einem Switch verbunden per LACP-LAG. Beim Benchmark mit Rados Bench kam ich teilweise beim Schreiben nicht mal auf 200IOPS. Bei der Überprüfung mit bmon kam heraus das der OSD-Traffic den falschen Weg nimmt und zwar über den LAN-Link und 10Gbit. Das würde die schwache Performance erklären.

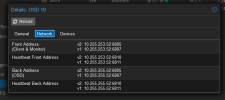

Ich hatte während der Installation über das WebGUI das Public und Storage Network gesplittet, weil wir eventuell externe Bare-Metal Hosts Zugriff auf CephFS gewären wollen und dies einfach komfortabel per VLAN Routen wollen. So sieht erstmal die Ceph-Config aus:

Cluster_network ist in diesem Fall richtigerweise das Subnetz der 100Gbit Mellanox-Karten, aber die OSD-Replication geht über das Public_Network 10.255.253.0/24...

Wenn ich Ceph richtig verstanden habe, sollte das Cluster_network eigentlich ausschließlich für den OSD-Replikation sein. Aber da geht derzeit nichts drüber, als würde es völlig ignoriert werden. Woran liegt das?

Gruß

ich bin gerade dabei ein neues Ceph Cluster aufzusetzen, aber stelle da paar Probleme fest. Beim Benchmark fiel mir auf das die Werte weit weg von dem sind, was die Hardware eigentlich leisten sollte.

Zum Setup:

Drei Nodes

Epyc 7543P

512Gb RAM

Mellanox ConnectX6 100Gbit

Broadcom P225P 10/25Gbit

4x Samsung PM9A3

Die beiden Ports der Mellanox sind jeweils mit einem Switch verbunden per LACP-LAG. Beim Benchmark mit Rados Bench kam ich teilweise beim Schreiben nicht mal auf 200IOPS. Bei der Überprüfung mit bmon kam heraus das der OSD-Traffic den falschen Weg nimmt und zwar über den LAN-Link und 10Gbit. Das würde die schwache Performance erklären.

Ich hatte während der Installation über das WebGUI das Public und Storage Network gesplittet, weil wir eventuell externe Bare-Metal Hosts Zugriff auf CephFS gewären wollen und dies einfach komfortabel per VLAN Routen wollen. So sieht erstmal die Ceph-Config aus:

Code:

[global]

auth_client_required = cephx

auth_cluster_required = cephx

auth_service_required = cephx

cluster_network = 10.255.255.50/24

mon_allow_pool_delete = true

mon_host = 10.255.253.50 10.255.253.51 10.255.253.52

ms_bind_ipv4 = true

ms_bind_ipv6 = false

osd_pool_default_min_size = 2

osd_pool_default_size = 3

public_network = 10.255.253.50/24

[client]

keyring = /etc/pve/priv/$cluster.$name.keyring

[mon.pve0]

public_addr = 10.255.253.50

[mon.pve1]

public_addr = 10.255.253.51

[mon.pve2]

public_addr = 10.255.253.52Cluster_network ist in diesem Fall richtigerweise das Subnetz der 100Gbit Mellanox-Karten, aber die OSD-Replication geht über das Public_Network 10.255.253.0/24...

Wenn ich Ceph richtig verstanden habe, sollte das Cluster_network eigentlich ausschließlich für den OSD-Replikation sein. Aber da geht derzeit nichts drüber, als würde es völlig ignoriert werden. Woran liegt das?

Gruß