Last edited:

Ceph Storage (18.2.4) bei 80%

- Thread starter fpausp

- Start date

You are using an out of date browser. It may not display this or other websites correctly.

You should upgrade or use an alternative browser.

You should upgrade or use an alternative browser.

Ich empfehle immer maximal 80%. Also würde ich bei dir langsam an die Beschaffung neuer Disks denken.Mein Ceph Storage ist momentan bei 80%, welcher Grad an Befüllung wird denn empfohlen

Ceph updatest du automatisch mit. Siehst du auch bei Ceph updates, dass dann die noch nicht geupdateten Nodes ein gelbes Kennzeichen bekommen.und wie pflegt man den Storage am Besten, oder reicht es einfach die PVEs upzudaten?

Nicht mehr als 1/3 bei 3 Nodes.welcher Grad an Befüllung wird denn empfohlen

https://florian.ca/ceph-calculator/

Naja, diese Aussage ist gar nichts wert.Nicht mehr als 1/3 bei 3 Nodes.

https://florian.ca/ceph-calculator/

Am Ende kommt es auf die Anzahl der Nodes und OSDs an.

Wenn du das so pauschal sagen willst dann wäre 66% richtig.

Wenn man bei einem 3 Node Setup mit der temporären Degradierung leben kann, wenn ein Node mal weg ist, dann reicht theoretisch die Kapazität der größten OSD.

Last edited:

Maschinen löschen hat nix mit der Poolbefüllung zu tun. OSD Nearfull ist noch nicht so schlimm, aber da sollte man sich mal alle OSDs anschauen.

Ja, für eine präzisere Aussage müsste der TE mal auflisten was je Node an OSDs verfügbar ist.Naja, diese Aussage ist gar nichts wert.

Am Ende kommt es auf die Anzahl der Nodes und OSDs an.

Wenn du das so pauschal sagen willst dann wäre 66% richtig.

Aber 1/3 ist generell schon mal falsch, zumindest wenn es um die Anzeige geht, vom Screenshot.

Und selbst wenn man 1/3 vom Brutto benutzt ist man bei klassischem Poolsetting zu 100% voll.

Mit Erasure Coding sieht das wieder anders aus, aber da hat man auch mehr als 3 Nodes.

Und selbst wenn man 1/3 vom Brutto benutzt ist man bei klassischem Poolsetting zu 100% voll.

Mit Erasure Coding sieht das wieder anders aus, aber da hat man auch mehr als 3 Nodes.

Mach ich in den nächsten Tagen...Ja, für eine präzisere Aussage müsste der TE mal auflisten was je Node an OSDs verfügbar ist.

Wenn das ein 3 Node Setup ist, dann ist ja alles fein.

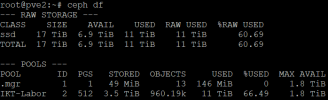

Du hast 3,8 TB Nutzdaten mit 3fach Replikation 11TB verbraucht und noch 6,4 TB von 17TB frei. Ist die Meldung mit dem .mgr Pool noch da?

Last edited:

Entweder ein Monitoringsystem wie Checkmk oder Zabbix nutzen oder du guckst selbst regelmäßig auf die GUI.Wie kann man den Ceph Storage, überwachen damit man frühzeitig gewarnt wird?

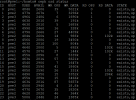

ID und Host ist ja klar.

Used, ist die Befüllung in GB und Avail genauso wieviel frei ist.

WR OPS sind die derzeitigen Write I/O und daneben wie viel Daten das sind.

RD OPS sind die Read I/O und Datenmenge.

State ist einfach der Status.

Used, ist die Befüllung in GB und Avail genauso wieviel frei ist.

WR OPS sind die derzeitigen Write I/O und daneben wie viel Daten das sind.

RD OPS sind die Read I/O und Datenmenge.

State ist einfach der Status.

Das sieht doch gut ausbalanciert aus.

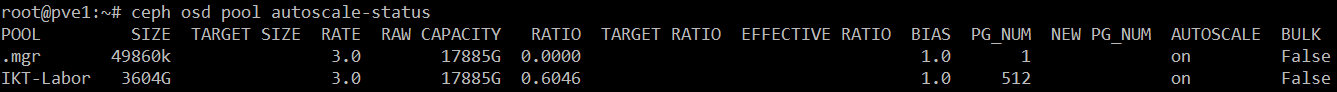

Eine Empfehlung noch: Verdoppele die Anzahl der PGs für den Pool IKT-Labor. Momentan sind es weniger als 70 PGs pro OSD. SSDs können gerne 200 - 400 PGs pro OSD halten. Dann kann der Algorithmus die Daten noch besser verteilen, weil die einzelnen PGs nicht so groß sind.

Was sagt "ceph osd pool autoscale-status"?

Eine Empfehlung noch: Verdoppele die Anzahl der PGs für den Pool IKT-Labor. Momentan sind es weniger als 70 PGs pro OSD. SSDs können gerne 200 - 400 PGs pro OSD halten. Dann kann der Algorithmus die Daten noch besser verteilen, weil die einzelnen PGs nicht so groß sind.

Was sagt "ceph osd pool autoscale-status"?