Hi zusammen,

ich habe mal wieder eine Frage an die Community...

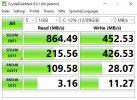

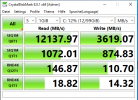

Ich hab mir jetzt ja mein kleines Homelab aufgebaut und wollte als Speicherlösung auf CEPH setzen. Generell hat alles geklappt, nur sehe ich von der Performance extrem schlechte zahlen. Ich hab mal in einer Windows VM einen Crystal Disk Test ausgeführt und auf meinen SSDs welche ich als CEPH OSDs nutze bekomme ich nur ein fünftel der Performance als wenn ich die lokalen SAS Platten im ZFS RAID 1 nehme...

Aufgebaut ist alles wie hier beschrieben nach Methode 1 (Broadcast). Dazu nutze ich die Onboard 10GB Schnittstellen ohne einen Switch dazwischen.

https://pve.proxmox.com/wiki/Full_Mesh_Network_for_Ceph_Server#Method_2

Damit ich überhaupt mal sehe ob sich das was im Netzwerk tut, hab ich die Broadcast Konfig mal aufgelöst und je Server einen Port direkt an einen Switch gehängt. Dieser Port war mit der IP Adresse des CEPH Netzwerks konfiguriert. Allerdings hat da laut Switch überhaupt keine Kommunikation stattgefunden.

Kann mir jemand einen Tipp geben wo ich noch schauen könnte. Irgendwie hab ich das Gefühl das Netzwerk will noch nicht so richtig...

Vielen Dank

Joe

ich habe mal wieder eine Frage an die Community...

Ich hab mir jetzt ja mein kleines Homelab aufgebaut und wollte als Speicherlösung auf CEPH setzen. Generell hat alles geklappt, nur sehe ich von der Performance extrem schlechte zahlen. Ich hab mal in einer Windows VM einen Crystal Disk Test ausgeführt und auf meinen SSDs welche ich als CEPH OSDs nutze bekomme ich nur ein fünftel der Performance als wenn ich die lokalen SAS Platten im ZFS RAID 1 nehme...

Aufgebaut ist alles wie hier beschrieben nach Methode 1 (Broadcast). Dazu nutze ich die Onboard 10GB Schnittstellen ohne einen Switch dazwischen.

https://pve.proxmox.com/wiki/Full_Mesh_Network_for_Ceph_Server#Method_2

Damit ich überhaupt mal sehe ob sich das was im Netzwerk tut, hab ich die Broadcast Konfig mal aufgelöst und je Server einen Port direkt an einen Switch gehängt. Dieser Port war mit der IP Adresse des CEPH Netzwerks konfiguriert. Allerdings hat da laut Switch überhaupt keine Kommunikation stattgefunden.

Kann mir jemand einen Tipp geben wo ich noch schauen könnte. Irgendwie hab ich das Gefühl das Netzwerk will noch nicht so richtig...

Vielen Dank

Joe