Moin zusammen

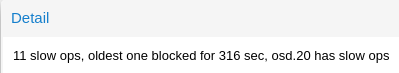

Ich mache jetzt hier mal einen Thread auf, weil es schon der zweite Server ist, auf dem eine OSD "abgestürzt" ist mit der gleichen Kernel Fehlermeldung.

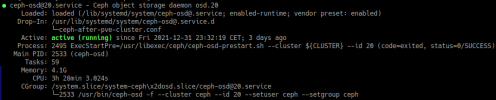

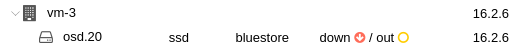

Bei beiden Vorfällen, habe ich ein NULL Pointer derefence im Kernel Log gefunden. Wenn das passiert ist eine OSD down und out und ceph-osd.x lässt sich nicht mehr starten.

Das Device ist noch vorhanden, es gibt keine Hinweise auf read oder write error und drauf schreiben und lesen kann ich auch.

Der Prozess für osd.x ist jetzt ein Zombie, weshalb ich die OSD dann auch nicht wieder hoch fahren kann. Leider ist PID 1 parent des OSD Prozesses, so das ich auch den parent nicht killen kann.

Ich kann leider den Server auch nicht einfach neu starten, da wir zur Zeit aufm Cluster etwas zu knapp mit dem RAM sind (Aufrüstung ist gleich Anfang nächsten Jahres, da haben wir neues Budget)

Was tun?

Achso, bevor ich es vergesse:

Hier die Versionen:

Ich mache jetzt hier mal einen Thread auf, weil es schon der zweite Server ist, auf dem eine OSD "abgestürzt" ist mit der gleichen Kernel Fehlermeldung.

Code:

[Dec24 02:28] BUG: kernel NULL pointer dereference, address: 0000000000000000

[ +0.000039] #PF: supervisor instruction fetch in kernel mode

[ +0.000036] #PF: error_code(0x0010) - not-present page

[ +0.000017] PGD 8000001094911067 P4D 8000001094911067 PUD 1094912067 PMD 0

[ +0.000024] Oops: 0010 [#1] SMP PTI

[ +0.000013] CPU: 34 PID: 290278 Comm: ngs-pulsar Tainted: P O 5.11.22-4-pve #1

[ +0.000027] Hardware name: Supermicro X10DRi/X10DRi, BIOS 2.0 12/28/2015

[ +0.000020] RIP: 0010:0x0

[ +0.000013] Code: Unable to access opcode bytes at RIP 0xffffffffffffffd6.

[ +0.000021] RSP: 0018:ffffa4648c6efb00 EFLAGS: 00010246

[ +0.000017] RAX: 0000000000000000 RBX: ffffa4648c6efb88 RCX: 0000000000000002

[ +0.000022] RDX: 0000000000000001 RSI: 0000000000000000 RDI: ffff88e1c4b1f400

[ +0.000021] RBP: ffffa4648c6efb08 R08: 0000000000000000 R09: 0000000000000015

[ +0.000021] R10: 0000000000000655 R11: 000000000000000a R12: ffff88e1c4b1f400

[ +0.000021] R13: ffff88e1ce2d6400 R14: 0000000000000000 R15: 0000000000000001

[ +0.000022] FS: 00007fab40d0ff38(0000) GS:ffff88e17fd80000(0000) knlGS:0000000000000000

[ +0.000042] CS: 0010 DS: 0000 ES: 0000 CR0: 0000000080050033

[ +0.000019] CR2: ffffffffffffffd6 CR3: 00000019f329e004 CR4: 00000000003726e0

[ +0.000039] DR0: 0000000000000000 DR1: 0000000000000000 DR2: 0000000000000000

[ +0.000022] DR3: 0000000000000000 DR6: 00000000fffe0ff0 DR7: 0000000000000400

[ +0.000023] Call Trace:

[ +0.000012] blk_mq_put_rq_ref+0x47/0x60

[ +0.000021] bt_iter+0x54/0x90

[ +0.000013] blk_mq_queue_tag_busy_iter+0x1a2/0x2d0

[ +0.000018] ? blk_add_rq_to_plug+0x50/0x50

[ +0.000017] ? blk_add_rq_to_plug+0x50/0x50

[ +0.000018] blk_mq_in_flight+0x38/0x60

[ +0.000016] diskstats_show+0x159/0x300

[ +0.000017] seq_read_iter+0x2c6/0x4b0

[ +0.000016] proc_reg_read_iter+0x51/0x80

[ +0.000017] new_sync_read+0x10d/0x190

[ +0.000018] vfs_read+0x15a/0x1c0

[ +0.000014] ksys_read+0x67/0xe0

[ +0.000014] __x64_sys_read+0x1a/0x20

[ +0.000032] do_syscall_64+0x38/0x90

[ +0.000015] entry_SYSCALL_64_after_hwframe+0x44/0xa9

[ +0.000035] RIP: 0033:0x47dd7b

[ +0.000012] Code: e8 2a 98 fe ff eb 88 cc cc cc cc cc cc cc cc e8 bb dd fe ff 48 8b 7c 24 10 48 8b 74 24 18 48 8b 54 24 20 48 8b 44 24 08 0f 05 <48> 3d 01 f0 ff ff 76 20 48 c7>

[ +0.000049] RSP: 002b:000000c00226b4e8 EFLAGS: 00000212 ORIG_RAX: 0000000000000000

[ +0.000022] RAX: ffffffffffffffda RBX: 000000c00004a000 RCX: 000000000047dd7b

[ +0.000022] RDX: 0000000000001000 RSI: 000000c001c63000 RDI: 000000000000006d

[ +0.000021] RBP: 000000c00226b538 R08: 0000000000000001 R09: 000000c001e7c840

[ +0.000021] R10: 000000c0006ea0b8 R11: 0000000000000212 R12: 000000c00226b728

[ +0.000021] R13: 0000000000000000 R14: 000000c00050e4e0 R15: ffffffffffffffff

[ +0.000022] Modules linked in: nfnetlink_queue nft_queue nf_tables tcp_diag inet_diag veth rpcsec_gss_krb5 auth_rpcgss nfsv4 nfsv3 nfs_acl nfs lockd grace nfs_ssc fscache ebta>

[ +0.000083] libiscsi_tcp libiscsi scsi_transport_iscsi drm sunrpc ip_tables x_tables autofs4 btrfs blake2b_generic xor raid6_pq dm_thin_pool dm_persistent_data dm_bio_prison >

[ +0.000404] CR2: 0000000000000000

[ +0.000014] ---[ end trace 7095f43d1d4ee59d ]---

[ +1.418120] RIP: 0010:0x0

[ +0.000026] Code: Unable to access opcode bytes at RIP 0xffffffffffffffd6.

[ +0.000041] RSP: 0018:ffffa4648c6efb00 EFLAGS: 00010246

[ +0.002345] RAX: 0000000000000000 RBX: ffffa4648c6efb88 RCX: 0000000000000002

[ +0.002404] RDX: 0000000000000001 RSI: 0000000000000000 RDI: ffff88e1c4b1f400

[ +0.001598] RBP: ffffa4648c6efb08 R08: 0000000000000000 R09: 0000000000000015

[ +0.001266] R10: 0000000000000655 R11: 000000000000000a R12: ffff88e1c4b1f400

[ +0.001279] R13: ffff88e1ce2d6400 R14: 0000000000000000 R15: 0000000000000001

[ +0.001805] FS: 00007fab40d0ff38(0000) GS:ffff88e17fd80000(0000) knlGS:0000000000000000

[ +0.002303] CS: 0010 DS: 0000 ES: 0000 CR0: 0000000080050033

[ +0.002240] CR2: ffffffffffffffd6 CR3: 00000019f329e004 CR4: 00000000003726e0

[ +0.002223] DR0: 0000000000000000 DR1: 0000000000000000 DR2: 0000000000000000

[ +0.002207] DR3: 0000000000000000 DR6: 00000000fffe0ff0 DR7: 0000000000000400Das Device ist noch vorhanden, es gibt keine Hinweise auf read oder write error und drauf schreiben und lesen kann ich auch.

Der Prozess für osd.x ist jetzt ein Zombie, weshalb ich die OSD dann auch nicht wieder hoch fahren kann. Leider ist PID 1 parent des OSD Prozesses, so das ich auch den parent nicht killen kann.

Ich kann leider den Server auch nicht einfach neu starten, da wir zur Zeit aufm Cluster etwas zu knapp mit dem RAM sind (Aufrüstung ist gleich Anfang nächsten Jahres, da haben wir neues Budget)

Was tun?

Achso, bevor ich es vergesse:

Hier die Versionen:

proxmox-ve: 7.0-2 (running kernel: 5.11.22-4-pve)

pve-manager: 7.0-11 (running version: 7.0-11/63d82f4e)

pve-kernel-helper: 7.1-2

pve-kernel-5.11: 7.0-7

pve-kernel-5.4: 6.4-5

pve-kernel-5.11.22-4-pve: 5.11.22-8

pve-kernel-5.4.128-1-pve: 5.4.128-2

ceph: 16.2.6-pve2

ceph-fuse: 16.2.6-pve2

corosync: 3.1.5-pve1

criu: 3.15-1+pve-1

glusterfs-client: 9.2-1

ifupdown: residual config

ifupdown2: 3.1.0-1+pmx3

ksm-control-daemon: 1.4-1

libjs-extjs: 7.0.0-1

libknet1: 1.22-pve1

libproxmox-acme-perl: 1.3.0

libproxmox-backup-qemu0: 1.2.0-1

libpve-access-control: 7.0-4

libpve-apiclient-perl: 3.2-1

libpve-common-perl: 7.0-9

libpve-guest-common-perl: 4.0-2

libpve-http-server-perl: 4.0-2

libpve-storage-perl: 7.0-11

libqb0: 1.0.5-1

libspice-server1: 0.14.3-2.1

lvm2: 2.03.11-2.1

lxc-pve: 4.0.9-4

lxcfs: 4.0.8-pve2

novnc-pve: 1.2.0-3

proxmox-backup-client: 2.0.9-2

proxmox-backup-file-restore: 2.0.9-2

proxmox-mini-journalreader: 1.2-1

proxmox-widget-toolkit: 3.3-6

pve-cluster: 7.0-3

pve-container: 4.0-10

pve-docs: 7.0-5

pve-edk2-firmware: 3.20200531-1

pve-firewall: 4.2-3

pve-firmware: 3.3-1

pve-ha-manager: 3.3-1

pve-i18n: 2.5-1

pve-qemu-kvm: 6.0.0-4

pve-xtermjs: 4.12.0-1

qemu-server: 7.0-14

smartmontools: 7.2-pve2

spiceterm: 3.2-2

vncterm: 1.7-1

zfsutils-linux: 2.0.5-pve1

pve-manager: 7.0-11 (running version: 7.0-11/63d82f4e)

pve-kernel-helper: 7.1-2

pve-kernel-5.11: 7.0-7

pve-kernel-5.4: 6.4-5

pve-kernel-5.11.22-4-pve: 5.11.22-8

pve-kernel-5.4.128-1-pve: 5.4.128-2

ceph: 16.2.6-pve2

ceph-fuse: 16.2.6-pve2

corosync: 3.1.5-pve1

criu: 3.15-1+pve-1

glusterfs-client: 9.2-1

ifupdown: residual config

ifupdown2: 3.1.0-1+pmx3

ksm-control-daemon: 1.4-1

libjs-extjs: 7.0.0-1

libknet1: 1.22-pve1

libproxmox-acme-perl: 1.3.0

libproxmox-backup-qemu0: 1.2.0-1

libpve-access-control: 7.0-4

libpve-apiclient-perl: 3.2-1

libpve-common-perl: 7.0-9

libpve-guest-common-perl: 4.0-2

libpve-http-server-perl: 4.0-2

libpve-storage-perl: 7.0-11

libqb0: 1.0.5-1

libspice-server1: 0.14.3-2.1

lvm2: 2.03.11-2.1

lxc-pve: 4.0.9-4

lxcfs: 4.0.8-pve2

novnc-pve: 1.2.0-3

proxmox-backup-client: 2.0.9-2

proxmox-backup-file-restore: 2.0.9-2

proxmox-mini-journalreader: 1.2-1

proxmox-widget-toolkit: 3.3-6

pve-cluster: 7.0-3

pve-container: 4.0-10

pve-docs: 7.0-5

pve-edk2-firmware: 3.20200531-1

pve-firewall: 4.2-3

pve-firmware: 3.3-1

pve-ha-manager: 3.3-1

pve-i18n: 2.5-1

pve-qemu-kvm: 6.0.0-4

pve-xtermjs: 4.12.0-1

qemu-server: 7.0-14

smartmontools: 7.2-pve2

spiceterm: 3.2-2

vncterm: 1.7-1

zfsutils-linux: 2.0.5-pve1