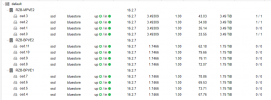

Nachdem ich nun meine Auslastung im Pool durch hinzunahme weiterer OSD auf 60% runter gebracht habe (von 80), bin ich versucht den autoscaler zu aktivieren.

Nur habe ich irgendwo auf einer Seite gelesen, dass der Autoscaler die Anzahl der PG pro OSD identisch setzt.

Da ich 1 TB und 2 TB SSD´s gemixed habe (allerdings so, dass jede der 3 Nodes identisch ist), wäre es wohl nciht so optimal wenn jede OSD dann die selbe Zahl PG´s vom Autoscaler bekommt.

Oder habe ich es falsch verstanden?

Ich möchte vermeiden, dass der Autoscaler Daten so verschiebt, dass CEPH nachher die 1TB Platten versucht zu befüllen wie die 2TB Platten.

Im Moment behelfe ich mir mit einem CRON : ceph osd reweight-by-utilization - autoscaler fände ich irgendwie eleganter

Könnt Ihr mir mit Rat & Wissen helfen?

Nur habe ich irgendwo auf einer Seite gelesen, dass der Autoscaler die Anzahl der PG pro OSD identisch setzt.

Da ich 1 TB und 2 TB SSD´s gemixed habe (allerdings so, dass jede der 3 Nodes identisch ist), wäre es wohl nciht so optimal wenn jede OSD dann die selbe Zahl PG´s vom Autoscaler bekommt.

Oder habe ich es falsch verstanden?

Ich möchte vermeiden, dass der Autoscaler Daten so verschiebt, dass CEPH nachher die 1TB Platten versucht zu befüllen wie die 2TB Platten.

Im Moment behelfe ich mir mit einem CRON : ceph osd reweight-by-utilization - autoscaler fände ich irgendwie eleganter

Könnt Ihr mir mit Rat & Wissen helfen?