Hallo zusammen,

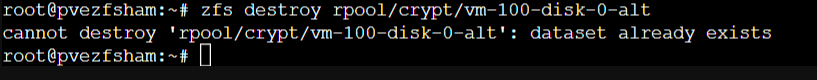

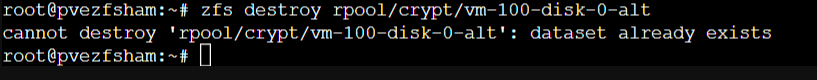

nach einem mißglückten Sync mit zfs-autobackup kann ich auf meinem Target-Server die ZFS-Datasets nicht löschen.

Das merkwürdigste daran ist, dass ich vorher alle Snapshots der Datasets gelöscht habe, aber trotzdem bei USEDCHILD Daten angezeigt werden, obwohl keine Children mehr existieren. Die Datasets sind encrypted unter rpool/crypt und entsperrt/mounted. Es gibt keine VM auf dem Proxmox-Server, der Proxmox-Server dient also nur als Backup-Target, daher ist es ausgeschlossen, dass sie evt. in Nutzung sind. Umbenennen konnte ich die Datasets, die es betrifft. Aber Löschen geht einfach nicht. Ich habe jetzt mal einen Scrub auf dem Pool gestartet, der dauert allerdings 2-3 Tage, und ich gehe auch nicht davon aus, dass Datenfehler vorliegen, denn eine Test-Einbindung der Datasets in einer VM zeigten dass sie lauffähig und nicht korrupt sind. Aber woher kommt die Angabe in USEDCHILD und wie werde ich das wieder los, damit ich sie löschen kann? Clones der Datasets existieren auch keine.

Hier markiert die USEDCHILD-Angaben, obwohl keine Snapshots mehr existieren.

Dass ich die gesamte Replikation der betreffenden Datasets neu starten muss, ist mir klar, als Full-Sync. Aber wie werde ich die alten Datasets los und bringe ZFS bei, dass es keine CHILD-Daten mehr gibt. Ich würde ungerne den ganzen Pool killen, weil dann alles neu synchronisiert werden muss.

Neu gestartet habe ich natürlich den Proxmox-Server auch schon ein paarmal, aber es bleibt dabei, ich kann die Datasets nicht löschen. Einen neuen Snapshot der Datasets kann ich auch erstellen, und diesen auch löschen, aber das Dataset nicht.

Wäre toll, wenn hier jemand einen Tipp hätte.

nach einem mißglückten Sync mit zfs-autobackup kann ich auf meinem Target-Server die ZFS-Datasets nicht löschen.

Das merkwürdigste daran ist, dass ich vorher alle Snapshots der Datasets gelöscht habe, aber trotzdem bei USEDCHILD Daten angezeigt werden, obwohl keine Children mehr existieren. Die Datasets sind encrypted unter rpool/crypt und entsperrt/mounted. Es gibt keine VM auf dem Proxmox-Server, der Proxmox-Server dient also nur als Backup-Target, daher ist es ausgeschlossen, dass sie evt. in Nutzung sind. Umbenennen konnte ich die Datasets, die es betrifft. Aber Löschen geht einfach nicht. Ich habe jetzt mal einen Scrub auf dem Pool gestartet, der dauert allerdings 2-3 Tage, und ich gehe auch nicht davon aus, dass Datenfehler vorliegen, denn eine Test-Einbindung der Datasets in einer VM zeigten dass sie lauffähig und nicht korrupt sind. Aber woher kommt die Angabe in USEDCHILD und wie werde ich das wieder los, damit ich sie löschen kann? Clones der Datasets existieren auch keine.

Hier markiert die USEDCHILD-Angaben, obwohl keine Snapshots mehr existieren.

Dass ich die gesamte Replikation der betreffenden Datasets neu starten muss, ist mir klar, als Full-Sync. Aber wie werde ich die alten Datasets los und bringe ZFS bei, dass es keine CHILD-Daten mehr gibt. Ich würde ungerne den ganzen Pool killen, weil dann alles neu synchronisiert werden muss.

Neu gestartet habe ich natürlich den Proxmox-Server auch schon ein paarmal, aber es bleibt dabei, ich kann die Datasets nicht löschen. Einen neuen Snapshot der Datasets kann ich auch erstellen, und diesen auch löschen, aber das Dataset nicht.

Wäre toll, wenn hier jemand einen Tipp hätte.

Last edited: