Hallo,

ich habe ein CephFS-Storage (aktuell ca. 18T Daten), welches ich auf dem PBS gemountet hab. Ich will hier nun regelmäßig den Datenbestand sichern, im besten Fall jeweils über einen konsistenten CephFS-Snapshot.

Das Ceph läuft noch auf HDDs und die serielle Sicherung des kompletten CephFS Verzeichnisbaums mit dem proxmox-backup-client dauert so >1 Woche.

Meine Idee war nun, einzelne Unterverzeinisse unabhängig voneinander parallel (die Ceph-Performance skaliert "in die Breite" deutlich besser) zu sichern.

Da der Client auf einem Host nicht mehrfach parallel gestartet werden kann, hab ich nun ein kleines Docker-Image mit dem Tool gebaut, welches ich mehrfach parallel starten kann; dem Container wird jeweils der aktuellste Snapshot des zu sichernden Unterverzeichnisses in das jeweilige Unterverzeichnus durchgereicht (z.B.

Das Konzept scheint auch vom Prinzip her relativ gut zu funktionieren, hat allerdings scheinbar ein Problem. Meine aktuelle Testverzeichnisse ändern sich nicht (alte Daten) und doch sichert er laut der Zusammenfassung immer >90% neu, statt die vorhandenen Chunks wiederzuverwenden:

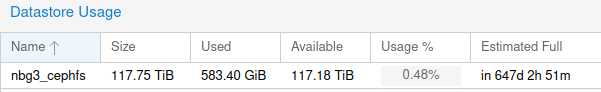

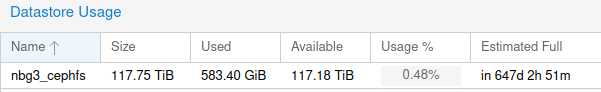

So würde natürlich mein Backupserver sehr schnell volllaufen, da ich ja immer quasi ein Fullbackup machen würde. Trotzdem zeigt er jetzt nach 3 Durchläufen nicht mehr Verbrauch an wie nach dem Ersten:

Meine Fragen nun:

- Welcher Aussage kann ich jetzt vertrauen? Der Ausgabe des proxmox-backup-client oder der Speicherbelegunganzeige im GUI?

- Woran kann es liegen, dass er bei gleichen Daten trotzdem quasi keine Chunks re-used? Wenn ich die Doku hierzu richtig verstanden habe, müsste er das bei gleichem Content doch tun? Liegt es am Docker-Container? Oder eher am CephFS-Snapshot?

- Wäre es möglich, eine parallele Sicherung mehrere Archive direkt in den Client einzubauen? Oder im besten Fall sogar eine komplett verwaltete CephFS-Sicherung mit Snapshots?

ich habe ein CephFS-Storage (aktuell ca. 18T Daten), welches ich auf dem PBS gemountet hab. Ich will hier nun regelmäßig den Datenbestand sichern, im besten Fall jeweils über einen konsistenten CephFS-Snapshot.

Das Ceph läuft noch auf HDDs und die serielle Sicherung des kompletten CephFS Verzeichnisbaums mit dem proxmox-backup-client dauert so >1 Woche.

Meine Idee war nun, einzelne Unterverzeinisse unabhängig voneinander parallel (die Ceph-Performance skaliert "in die Breite" deutlich besser) zu sichern.

Da der Client auf einem Host nicht mehrfach parallel gestartet werden kann, hab ich nun ein kleines Docker-Image mit dem Tool gebaut, welches ich mehrfach parallel starten kann; dem Container wird jeweils der aktuellste Snapshot des zu sichernden Unterverzeichnisses in das jeweilige Unterverzeichnus durchgereicht (z.B.

Graphite/.snap/currentsnaptimestap -> Graphite).Das Konzept scheint auch vom Prinzip her relativ gut zu funktionieren, hat allerdings scheinbar ein Problem. Meine aktuelle Testverzeichnisse ändern sich nicht (alte Daten) und doch sichert er laut der Zusammenfassung immer >90% neu, statt die vorhandenen Chunks wiederzuverwenden:

Code:

had to backup 152.88 GiB of 158.66 GiB (compressed 145.74 GiB) in 2769.58s

average backup speed: 56.52 MiB/s

backup was done incrementally, reused 5.78 GiB (3.6%)

Reused 1642 from 43400 chunks.

Average chunk size was 3.74 MiB.

Average time per request: 63815 microseconds.

Code:

had to backup 481.93 GiB of 525.04 GiB (compressed 430.37 GiB) in 11299.93s

average backup speed: 43.67 MiB/s

backup was done incrementally, reused 43.12 GiB (8.2%)

Reused 18575 from 148151 chunks.

Average chunk size was 3.63 MiB.

Average time per request: 76273 microseconds.So würde natürlich mein Backupserver sehr schnell volllaufen, da ich ja immer quasi ein Fullbackup machen würde. Trotzdem zeigt er jetzt nach 3 Durchläufen nicht mehr Verbrauch an wie nach dem Ersten:

Meine Fragen nun:

- Welcher Aussage kann ich jetzt vertrauen? Der Ausgabe des proxmox-backup-client oder der Speicherbelegunganzeige im GUI?

- Woran kann es liegen, dass er bei gleichen Daten trotzdem quasi keine Chunks re-used? Wenn ich die Doku hierzu richtig verstanden habe, müsste er das bei gleichem Content doch tun? Liegt es am Docker-Container? Oder eher am CephFS-Snapshot?

- Wäre es möglich, eine parallele Sicherung mehrere Archive direkt in den Client einzubauen? Oder im besten Fall sogar eine komplett verwaltete CephFS-Sicherung mit Snapshots?