ja danke, ich bin gerade dabei ein paar (simple) beispiele in die doku aufzunehmen, da ist dieses setup auch dabeiDanke, ich probiere das aus.

Aber vielleicht sollte man so ein Beispiel tatsächlich mal in das Wiki schreiben, weil ich mir vorstellen könnte, dass die Variante doch bei vielen kleineren Installationen zum Einsatz kommt. In diesem Fall bei einem Arzt, der das zweite Backup nicht zwingend in eine Cloud sondern auf Band schreiben möchte, um es mit außer Haus zu nehmen.

Bänder durcheinander

- Thread starter schloegel-edv

- Start date

You are using an out of date browser. It may not display this or other websites correctly.

You should upgrade or use an alternative browser.

You should upgrade or use an alternative browser.

scheinbar gibt es kein freies oder abgelaufenes tape mehr? wie ist denn alles konfiguriert?

der output von

wäre interessantCode:proxmox-tape media list proxmox-tape pool list proxmox-tape backup-job list

proxmox-tape media list

┌────────────┬───────────┬──────────────────────────┬────────┬────────┬──────────────────────┬─────────┬──────────────────────────────────────┬──────────────────────────────────────┐

│ label-text │ pool │ media-set-name │ seq-nr │ status │ location │ catalog │ uuid │ media-set-uuid │

╞════════════╪═══════════╪══════════════════════════╪════════╪════════╪══════════════════════╪═════════╪══════════════════════════════════════╪══════════════════════════════════════╡

│ │ pbs-bnetd │ Sun Feb 27 14:13:56 2022 │ 0 │ full │ online-archive-bnetd │ ok │ deb8e7d7-57bf-4987-87a2-0d9b5e1c1926 │ 46bf8116-e01d-457a-ac92-b16ed0a1ebb9 │

└────────────┴───────────┴──────────────────────────┴────────┴────────┴──────────────────────┴─────────┴──────────────────────────────────────┴──────────────────────────────────────┘

proxmox-tape pool list

┌───────────┬────────────┬───────────┬──────────┬─────────┐

│ name │ allocation │ retention │ template │ encrypt │

╞═══════════╪════════════╪═══════════╪══════════╪═════════╡

│ pbs-bnetd │ continue │ keep │ │ yes │

├───────────┼────────────┼───────────┼──────────┼─────────┤

│ pbs_bnetd │ continue │ keep │ │ yes │

└───────────┴────────────┴───────────┴──────────┴─────────┘

proxmox-tape backup-job list

┌──────┬───────────┬───────────┬────────┬──────────┬──────────────────────────┬──────────────────┬─────────┐

│ id │ store │ pool │ drive │ schedule │ next-run │ next-media-label │ comment │

╞══════╪═══════════╪═══════════╪════════╪══════════╪══════════════════════════╪══════════════════╪═════════╡

│ job2 │ pbs-bnetd │ pbs-bnetd │ drive0 │ yearly │ Sun Jan 1 00:00:00 2023 │ │ │

└──────┴───────────┴───────────┴────────┴──────────┴──────────────────────────┴──────────────────┴─────────┘

@Darius koissi what doesshow ?Code:proxmox-tape status

root@pbs3:~# proxmox-tape status

Error: unable to get (default) drive name

root@pbs3:~#

ok then please with '--drive drive0' and make sure that tape is inserted there

edit: sorry wir sind hier eigentlich im deutsche forum ^^

bitte nochmal versuchen mit '--drive drive0' am ende und bitte das tape vorher einlegen

edit: sorry wir sind hier eigentlich im deutsche forum ^^

bitte nochmal versuchen mit '--drive drive0' am ende und bitte das tape vorher einlegen

Last edited:

root@pbs3:~# proxmox-tape status --drive drive0

┌────────────────┬──────────────────────────┐

│ Name │ Value │

╞════════════════╪══════════════════════════╡

│ blocksize │ 0 │

├────────────────┼──────────────────────────┤

│ density │ LTO7 │

├────────────────┼──────────────────────────┤

│ compression │ 1 │

├────────────────┼──────────────────────────┤

│ buffer-mode │ 1 │

├────────────────┼──────────────────────────┤

│ alert-flags │ (empty) │

├────────────────┼──────────────────────────┤

│ file-number │ 0 │

├────────────────┼──────────────────────────┤

│ block-number │ 0 │

├────────────────┼──────────────────────────┤

│ manufactured │ Thu Jun 3 00:00:00 2021 │

├────────────────┼──────────────────────────┤

│ bytes-written │ 225 MiB │

├────────────────┼──────────────────────────┤

│ bytes-read │ 71 MiB │

├────────────────┼──────────────────────────┤

│ medium-passes │ 192 │

├────────────────┼──────────────────────────┤

│ medium-wearout │ 1.20% │

├────────────────┼──────────────────────────┤

│ volume-mounts │ 10 │

└────────────────┴──────────────────────────┘

root@pbs3:~#

┌────────────────┬──────────────────────────┐

│ Name │ Value │

╞════════════════╪══════════════════════════╡

│ blocksize │ 0 │

├────────────────┼──────────────────────────┤

│ density │ LTO7 │

├────────────────┼──────────────────────────┤

│ compression │ 1 │

├────────────────┼──────────────────────────┤

│ buffer-mode │ 1 │

├────────────────┼──────────────────────────┤

│ alert-flags │ (empty) │

├────────────────┼──────────────────────────┤

│ file-number │ 0 │

├────────────────┼──────────────────────────┤

│ block-number │ 0 │

├────────────────┼──────────────────────────┤

│ manufactured │ Thu Jun 3 00:00:00 2021 │

├────────────────┼──────────────────────────┤

│ bytes-written │ 225 MiB │

├────────────────┼──────────────────────────┤

│ bytes-read │ 71 MiB │

├────────────────┼──────────────────────────┤

│ medium-passes │ 192 │

├────────────────┼──────────────────────────┤

│ medium-wearout │ 1.20% │

├────────────────┼──────────────────────────┤

│ volume-mounts │ 10 │

└────────────────┴──────────────────────────┘

root@pbs3:~#

ok then please with '--drive drive0' and make sure that tape is inserted there

edit: sorry wir sind hier eigentlich im deutsche forum ^^

bitte nochmal versuchen mit '--drive drive0' am ende und bitte das tape vorher einlegen

I did a first tape backup job last week and it ended. I removed the tape but I have the impression that the server has kept the uuid of the tape in memory and still displays the online statusok then please with '--drive drive0' and make sure that tape is inserted there

edit: sorry wir sind hier eigentlich im deutsche forum ^^

bitte nochmal versuchen mit '--drive drive0' am ende und bitte das tape vorher einlegen

ok, do you have a changer or is this a standalone drive?

what is the output of the following commands:

did you mark the drive as full? if yes no more backups will be attempted on it.

try to clear the status in the webui under 'Tape Backup' -> 'Inventory' -> 'Set Status'

according to the media pool settings, the drive should be writable (so the backups can continue there)

what is the output of the following commands:

Code:

proxmox-tape drive list --output-format json

proxmox-tape changer list --output-format-jsondid you mark the drive as full? if yes no more backups will be attempted on it.

try to clear the status in the webui under 'Tape Backup' -> 'Inventory' -> 'Set Status'

according to the media pool settings, the drive should be writable (so the backups can continue there)

root@pbs3:~# proxmox-tape drive list --output-format json

[{"changer":"archive-bnetd","model":"Ultrium_7-SCSI","name":"drive0","path":"/dev/tape/by-id/scsi-CZ21500DTT-sg","serial":"CZ21500DTT","vendor":"HP"}]

root@pbs3:~#

root@pbs3:~# proxmox-tape changer list --output-format json

[{"export-slots":"15,16","model":"1x8_G2_AUTOLDR","name":"archive-bnetd","path":"/dev/tape/by-id/scsi-DEC1480865","serial":"DEC1480865","vendor":"HP"}]

root@pbs3:~#

the message after set the status:

2022-03-04T11:01:10+00:00: Starting tape backup job 'pbs-bnetd bs-bnetd:drive0:job2'

bs-bnetd:drive0:job2'

2022-03-04T11:01:10+00:00: update media online status

2022-03-04T11:01:10+00:00: media set uuid: 46bf8116-e01d-457a-ac92-b16ed0a1ebb9

2022-03-04T11:01:23+00:00: found 40 groups (out of 91 total)

2022-03-04T11:01:23+00:00: skip snapshot vm/143/2022-02-03T18:10:13Z

2022-03-04T11:01:23+00:00: backup snapshot vm/143/2022-02-04T18:14:33Z

2022-03-04T11:01:36+00:00: allocated new writable media ''

2022-03-04T11:01:36+00:00: loading media '' into drive 'drive0'

2022-03-04T11:02:15+00:00: found media label cart-002-04032022 (8829987c-345c-4001-ae8c-fe3bd9bb68c8)

2022-03-04T11:02:15+00:00: TASK ERROR: read label failed (please label all tapes first)

-----> 46bf8116-e01d-457a-ac92-b16ed0a1ebb9 : UUID old tape backup

----> 8829987c-345c-4001-ae8c-fe3bd9bb68c8 : UUID new tape backup

Thank

[{"changer":"archive-bnetd","model":"Ultrium_7-SCSI","name":"drive0","path":"/dev/tape/by-id/scsi-CZ21500DTT-sg","serial":"CZ21500DTT","vendor":"HP"}]

root@pbs3:~#

root@pbs3:~# proxmox-tape changer list --output-format json

[{"export-slots":"15,16","model":"1x8_G2_AUTOLDR","name":"archive-bnetd","path":"/dev/tape/by-id/scsi-DEC1480865","serial":"DEC1480865","vendor":"HP"}]

root@pbs3:~#

the message after set the status:

2022-03-04T11:01:10+00:00: Starting tape backup job 'pbs-bnetd

2022-03-04T11:01:10+00:00: update media online status

2022-03-04T11:01:10+00:00: media set uuid: 46bf8116-e01d-457a-ac92-b16ed0a1ebb9

2022-03-04T11:01:23+00:00: found 40 groups (out of 91 total)

2022-03-04T11:01:23+00:00: skip snapshot vm/143/2022-02-03T18:10:13Z

2022-03-04T11:01:23+00:00: backup snapshot vm/143/2022-02-04T18:14:33Z

2022-03-04T11:01:36+00:00: allocated new writable media ''

2022-03-04T11:01:36+00:00: loading media '' into drive 'drive0'

2022-03-04T11:02:15+00:00: found media label cart-002-04032022 (8829987c-345c-4001-ae8c-fe3bd9bb68c8)

2022-03-04T11:02:15+00:00: TASK ERROR: read label failed (please label all tapes first)

-----> 46bf8116-e01d-457a-ac92-b16ed0a1ebb9 : UUID old tape backup

----> 8829987c-345c-4001-ae8c-fe3bd9bb68c8 : UUID new tape backup

Thank

did you read the tape documentation? https://pbs.proxmox.com/docs/tape-backup.html

did you label the tapes correctly? how many tapes do you have and how are you labeled?

don't confuse 'media-set' uuid with 'tape uuid. a media-set can contain multiple tapes...

did you label the tapes correctly? how many tapes do you have and how are you labeled?

-----> 46bf8116-e01d-457a-ac92-b16ed0a1ebb9 : UUID old tape backup

----> 8829987c-345c-4001-ae8c-fe3bd9bb68c8 : UUID new tape backup

don't confuse 'media-set' uuid with 'tape uuid. a media-set can contain multiple tapes...

I inserted two moors. one is called cart-002-04032022 and the second is cart-003. I labeled with sticky paper.

I also tagged on the graphic interface

I also tagged on the graphic interface

did you read the tape documentation? https://pbs.proxmox.com/docs/tape-backup.html

did you label the tapes correctly? how many tapes do you have and how are you labeled?

don't confuse 'media-set' uuid with 'tape uuid. a media-set can contain multiple tapes...

Hallo,

es wird nix. Irgendwas läuft schief. Mit der Anleitung funktionerte es wieder die erste Woche (weil ich auch jeweils vor der Sicherung die Bänder neu formatiert und entsprechend etikettiert habe). Spannend ist es ja dann 1 Woche später.

Gestern und heute geht er mit Fehler raus:

ich verstehe das nicht. Die Aufbewahrungszeit steht auf 6 days 23 hours. Zumindest scheint er nun mit den Bändern nicht durcheinander zu kommen.

es wird nix. Irgendwas läuft schief. Mit der Anleitung funktionerte es wieder die erste Woche (weil ich auch jeweils vor der Sicherung die Bänder neu formatiert und entsprechend etikettiert habe). Spannend ist es ja dann 1 Woche später.

Gestern und heute geht er mit Fehler raus:

Code:

2022-03-08T19:30:00+01:00: waiting for drive lock...

2022-03-08T19:30:00+01:00: Starting tape backup job 'DATA:Dienstag:TANDBERG:Dienstag'

2022-03-08T19:30:00+01:00: task triggered by schedule 'Tue 19:30'

2022-03-08T19:30:00+01:00: update media online status

2022-03-08T19:30:00+01:00: starting new media set - reason: policy CreateAt event triggered

2022-03-08T19:30:00+01:00: media set uuid: 9dc9a888-61a7-45dc-b2cc-1fb2f24738ff

2022-03-08T19:30:00+01:00: found 4 groups

2022-03-08T19:30:00+01:00: backup snapshot vm/100/2022-01-29T18:30:02Z

2022-03-08T19:30:00+01:00: TASK ERROR: alloc writable media in pool 'Dienstag' failed: no usable media foundich verstehe das nicht. Die Aufbewahrungszeit steht auf 6 days 23 hours. Zumindest scheint er nun mit den Bändern nicht durcheinander zu kommen.

bitte mein edit lesen vom post:ich verstehe das nicht. Die Aufbewahrungszeit steht auf 6 days 23 hours. Zumindest scheint er nun mit den Bändern nicht durcheinander zu kommen.

jeder dieser pools hat dann eine retention policy overwrite und eine allocation policy : mon 20:00 für Montag, tue 20:00 für Dienstag, etc

dann für jeden Wochentag einen tape job jeweils kurz nach dem allocation policy trigger

so stellt man sicher dass immer nur die richtigen tapes verwendet werden (auch wenn ein Wochentag mal mehr als ein tape braucht)

edit: hab mich schon wieder bei der retention policy verschrieben^^, die richtige ist overwrite

Sooo... Also, es funktioniert jetzt. Aber eh ich das verstanden habe... Nochmals zur Zusammenfassung:

Für jeden Tag wurde 1 Mediaset angelegt. Allocation Pol. habe ich auf 19:00 Uhr festgelegt, die Aufbewahrungs Pol. auf 6 Tage /n 23 Std. Dadurch gehen die 7 Tage später um 18 Uhr in einen beschreibbaren Zustand. Der Backupjob auf Band dieses Mediasets wird an diesem Tag um 18 Uhr gestartet und dauert etwa reichlich 45min. Danach ist das Set wieder verschlossen. So funktioniert es.

4 Fragen sind noch entstanden:

Folgender Fehler erscheint in jedem Protokoll. Dieser Fehler erschien nicht, wenn ich die Sicherung zum Beispiel nachträglich oder per Hand gestartet habe:

Das Band kommt raus, die Sicherung ist beendet. Aber ist das auch ok so?

Für jeden Tag wurde 1 Mediaset angelegt. Allocation Pol. habe ich auf 19:00 Uhr festgelegt, die Aufbewahrungs Pol. auf 6 Tage /n 23 Std. Dadurch gehen die 7 Tage später um 18 Uhr in einen beschreibbaren Zustand. Der Backupjob auf Band dieses Mediasets wird an diesem Tag um 18 Uhr gestartet und dauert etwa reichlich 45min. Danach ist das Set wieder verschlossen. So funktioniert es.

4 Fragen sind noch entstanden:

- was bedeutet die Option "nur neueste"? Diese Option habe ich derzeit nicht aktiviert.

- was passiert, wenn mal 1 oder 2 Wochen das Band nicht zum Zeitpunkt eingelgt ist (Urlaub) ?

- das Laufwerk zeigt an: "TapeAlertFlags: FIRMWARE_FAILURE", scheint aber der Sache keinen Abbruch zu tun, es ist ein Tandberg LTO-6 HH SAS Drive KIT extern

Folgender Fehler erscheint in jedem Protokoll. Dieser Fehler erschien nicht, wenn ich die Sicherung zum Beispiel nachträglich oder per Hand gestartet habe:

Code:

Proxmox

Backup Server 2.1-5

()

2022-03-21T18:00:00+01:00: waiting for drive lock...

2022-03-21T18:00:00+01:00: Starting tape backup job 'DATA:Montag:TANDBERG:Montag'

2022-03-21T18:00:00+01:00: task triggered by schedule 'Mon 18:00'

2022-03-21T18:00:00+01:00: update media online status

2022-03-21T18:00:00+01:00: starting new media set - reason: policy CreateAt event triggered

2022-03-21T18:00:00+01:00: media set uuid: 086aee63-1e26-4757-a333-d8a235135349

2022-03-21T18:00:00+01:00: found 4 groups

2022-03-21T18:00:00+01:00: backup snapshot vm/100/2022-02-26T18:30:02Z

2022-03-21T18:00:00+01:00: allocated new writable media 'Montag'

2022-03-21T18:00:00+01:00: Checking for media 'Montag' in drive 'TANDBERG'

2022-03-21T18:00:15+01:00: found media label Montag (59af3c9c-8e2b-46b1-a1f4-dcfe91cb2ccc)

2022-03-21T18:00:15+01:00: TapeAlertFlags: FIRMWARE_FAILURE

2022-03-21T18:00:15+01:00: writing new media set label (overwrite '27546cca-f157-4d6e-b338-051b29ddf4c0/0')

2022-03-21T18:00:27+01:00: moving to end of media

2022-03-21T18:01:08+01:00: wrote 13898 chunks (4298.11 MB at 142.24 MB/s)

2022-03-21T18:01:10+01:00: wrote 202 chunks (392.95 MB at 167.87 MB/s)

2022-03-21T18:01:10+01:00: end backup DATA:vm/100/2022-02-26T18:30:02Z

2022-03-21T18:01:10+01:00: percentage done: 2.08% (0/4 groups, 1/12 snapshots in group #1)

2022-03-21T18:01:10+01:00: backup snapshot vm/100/2022-03-12T18:30:01Z

2022-03-21T18:01:18+01:00: wrote 1926 chunks (1234.44 MB at 168.68 MB/s)

2022-03-21T18:01:18+01:00: end backup DATA:vm/100/2022-03-12T18:30:01Z

2022-03-21T18:01:18+01:00: percentage done: 4.17% (0/4 groups, 2/12 snapshots in group #1)

2022-03-21T18:01:18+01:00: backup snapshot vm/100/2022-03-15T18:30:01Z

2022-03-21T18:01:25+01:00: wrote 1296 chunks (1153.43 MB at 168.90 MB/s)

2022-03-21T18:01:25+01:00: end backup DATA:vm/100/2022-03-15T18:30:01Z

2022-03-21T18:01:25+01:00: percentage done: 6.25% (0/4 groups, 3/12 snapshots in group #1)

2022-03-21T18:01:25+01:00: backup snapshot vm/100/2022-03-16T18:30:01Z

2022-03-21T18:01:31+01:00: wrote 867 chunks (1029.18 MB at 168.51 MB/s)

2022-03-21T18:01:31+01:00: end backup DATA:vm/100/2022-03-16T18:30:01Z

2022-03-21T18:01:31+01:00: percentage done: 8.33% (0/4 groups, 4/12 snapshots in group #1)

2022-03-21T18:01:31+01:00: backup snapshot vm/100/2022-03-17T18:30:02Z

2022-03-21T18:01:37+01:00: wrote 742 chunks (1043.60 MB at 168.74 MB/s)

2022-03-21T18:01:37+01:00: end backup DATA:vm/100/2022-03-17T18:30:02Z

2022-03-21T18:01:37+01:00: percentage done: 10.42% (0/4 groups, 5/12 snapshots in group #1)

2022-03-21T18:01:37+01:00: backup snapshot vm/100/2022-03-18T18:30:01Z

2022-03-21T18:01:44+01:00: wrote 837 chunks (1091.31 MB at 168.42 MB/s)

2022-03-21T18:01:44+01:00: end backup DATA:vm/100/2022-03-18T18:30:01Z

2022-03-21T18:01:44+01:00: percentage done: 12.50% (0/4 groups, 6/12 snapshots in group #1)

2022-03-21T18:01:44+01:00: backup snapshot vm/100/2022-03-19T11:00:02Z

2022-03-21T18:01:44+01:00: WARN: failed opening snapshot 'vm/100/2022-03-19T11:00:02Z': unable to open snapshot directory "/mnt/datastore/DATA/vm/100/2022-03-19T11:00:02Z" for locking - ENOENT: No such file or directory

2022-03-21T18:01:44+01:00: percentage done: 14.58% (0/4 groups, 7/12 snapshots in group #1)

2022-03-21T18:01:44+01:00: backup snapshot vm/100/2022-03-19T15:00:02Z

2022-03-21T18:01:44+01:00: WARN: failed opening snapshot 'vm/100/2022-03-19T15:00:02Z': unable to open snapshot directory "/mnt/datastore/DATA/vm/100/2022-03-19T15:00:02Z" for locking - ENOENT: No such file or directory

2022-03-21T18:01:44+01:00: percentage done: 16.67% (0/4 groups, 8/12 snapshots in group #1)

2022-03-21T18:01:44+01:00: backup snapshot vm/100/2022-03-19T18:30:02Z

2022-03-21T18:01:50+01:00: wrote 617 chunks (1047.27 MB at 168.73 MB/s)

2022-03-21T18:01:50+01:00: end backup DATA:vm/100/2022-03-19T18:30:02Z

........

2022-03-21T18:48:10+01:00: end backup DATA:vm/103/2022-03-12T23:00:02Z

2022-03-21T18:48:10+01:00: percentage done: 97.50% (3/4 groups, 9/10 snapshots in group #4)

2022-03-21T18:48:10+01:00: backup snapshot vm/103/2022-03-19T23:00:02Z

2022-03-21T18:48:10+01:00: wrote 27 chunks (34.08 MB at 360.44 MB/s)

2022-03-21T18:48:19+01:00: end backup DATA:vm/103/2022-03-19T23:00:02Z

2022-03-21T18:48:19+01:00: percentage done: 100.00% (4/4 groups)

2022-03-21T18:48:19+01:00: append media catalog

2022-03-21T18:48:19+01:00: standalone drive - ejecting media

2022-03-21T18:50:27+01:00: TASK ERROR: Tape backup finished with some errors. Please check the task log.Das Band kommt raus, die Sicherung ist beendet. Aber ist das auch ok so?

Last edited:

das nur die neuesten snapshots pro gruppe gesichert werden

- was bedeutet die Option "nur neueste"? Diese Option habe ich derzeit nicht aktiviert.

es wartet bis das tape eingelegt wird oder der task abgebrochen wird.

- was passiert, wenn mal 1 oder 2 Wochen das Band nicht zum Zeitpunkt eingelgt ist (Urlaub) ?

für so einen fall am besten die schedule löschen damit es nicht ausgeführt wird

hängt vermutlich vom tape drive ab was es heißt, bei ibm:

- das Laufwerk zeigt an: "TapeAlertFlags: FIRMWARE_FAILURE", scheint aber der Sache keinen Abbruch zu tun, es ist ein Tandberg LTO-6 HH SAS Drive KIT extern

https://www.ibm.com/docs/en/ts11xx-tape-drive?topic=STPRH6/com.ibm.storage.drives.doc/tapealert.html

Firmware failure Operation failed because of microcode problem. Call for service.

lief während dem tape backup auch ein prune oder löschvorgang? solche meldungen können passieren wenn während dem backup snapshots verschwindenFolgender Fehler erscheint in jedem Protokoll. Dieser Fehler erschien nicht, wenn ich die Sicherung zum Beispiel nachträglich oder per Hand gestartet habe:

was bedeutet das genau - ich möchte mit Hilfe der Bandsicherung den zuletzt gesicherten Stand der VMs komplett zurück sichern können (Disaster-Recovery). Also müsste demzufolge die Option nicht angehakt sein?das nur die neuesten snapshots pro gruppe gesichert werden

eigentlich nicht. Kann man sowas in einem Protokoll nachschauen?lief während dem tape backup auch ein prune oder löschvorgang? solche meldungen können passieren wenn während dem backup snapshots verschwinden

normalerweise werden alle snapshots einer backup gruppe aufs tape gesichert (also vm/100/2022-01-01T00:00:00Z + vm/100/2022-01-01T01:00:00Z usw) die noch nicht im tape backup enthalten sind.was bedeutet das genau - ich möchte mit Hilfe der Bandsicherung den zuletzt gesicherten Stand der VMs komplett zurück sichern können (Disaster-Recovery). Also müsste demzufolge die Option nicht angehakt sein?

ist die option an, wird nur der letzte (neueste) snapshot aufs tape gesichert, die älteren nicht. im pbs ist aber jeder snapshot vollkommen unabhängig von den anderen dh. auch diesen einen

snapshot kann man restoren.

im node task log (administration -> tasks) sollten sich solche tasks finden lasseneigentlich nicht. Kann man sowas in einem Protokoll nachschauen?

danke! Genau das war es.normalerweise werden alle snapshots einer backup gruppe aufs tape gesichert (also vm/100/2022-01-01T00:00:00Z + vm/100/2022-01-01T01:00:00Z usw) die noch nicht im tape backup enthalten sind.

ist die option an, wird nur der letzte (neueste) snapshot aufs tape gesichert, die älteren nicht. im pbs ist aber jeder snapshot vollkommen unabhängig von den anderen dh. auch diesen einen

snapshot kann man restoren.

im node task log (administration -> tasks) sollten sich solche tasks finden lassen

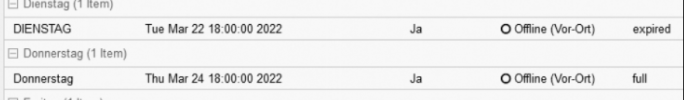

sorry, ich werd verrückt - das war es noch nicht. Nun ist nach der Erstellung des Planes / der Mediasets die 3. Woche angebrochen und nun funktioniert es wieder nicht. Wie ich in der 2. Woche gesehen hatte (und oben geschrieben hatte), geht das Mediaset in einen beschreibbaren Zustand (writable). Nun aber passiert nichts. Bis 18 Uhr erscheint "full". Danach erscheint "expired". Es wurde nichts verändert - wie gesagt, in den ersten beiden Wochen hat alles wunderbar funktioniert. Das richtige Band liegt auch drin, kann aber nun nicht beschrieben werden.danke! Genau das war es.

'expired' ist der normale zustand wenn die retention eines media-sets abgelaufen ist, das ist also so normal und gewollt in dem fall

was ist denn genau der fehler?

auch bitte nochmal den aktuellen output von folgenden dingen posten:

was ist denn genau der fehler?

auch bitte nochmal den aktuellen output von folgenden dingen posten:

Code:

proxmox-tape pool list

proxmox-tape media list

proxmox-tape backup-job list