Hallo,

ich habenatürlich beim Pool erstellen nicht richtig mitgedacht. Weder bei meinem Datenpool, noch bei meinem rpool.

Folgende Blocksizes habe ich mir jetzt über die devices anzeigen lassen:

Also die Festplatten sda, sdd, sde, sdf, sdg und sdh sind alle Seagate 6GB IronWolf mit 4K Sektogrößen. Dafür müsste ich den pool doch mit

Bei der Installation von PVE, meine ich, könnte man auch ne Size angeben. Hier würden zwei SSD sdb und sdc genommen. Hier (die wahrscheinlich schon oft gefragte) Frage: Haben die SSD wirklich 512 Blocksize oder ist das einfach ein gefakter Wert beim auslesen und ich muss die mal beim hersteller nachschauen.

Wenn ich wüsste mit welchen Einstellungen, dann würde ich die Daten backupen, die entsprechenden Pools neu erstellen und die Daten wieder zurückholen. Beim Datenpool klar, beim root-Pool muss ich noch grübeln, wie das am besten geht...

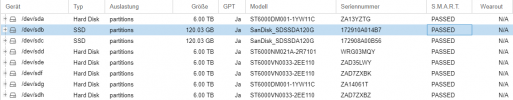

Ausserdem: Es sind Consumer SSDs. Kann ich das Wearout irgendwo nachvollziehen, ob die mir gerade schnell kaputt gehen und ich gegen Enterprise tauschen muss? Ich sehe unter DISKS nicht wirklich was. Wie stelle ich das "Schnelle Kaputtgehen" denn fest, was so oft zitiert wird.

ich habe

Folgende Blocksizes habe ich mir jetzt über die devices anzeigen lassen:

lsblk -o NAME,MOUNTPOINT,PHY-SEC

Bash:

NAME MOUNTPOINT PHY-SEC

sda 4096

├─sda1 4096

└─sda9 4096

sdb 512

├─sdb1 512

├─sdb2 512

└─sdb3 512

sdc 512

├─sdc1 512

├─sdc2 512

└─sdc3 512

sdd 4096

├─sdd1 4096

└─sdd9 4096

sde 4096

├─sde1 4096

└─sde9 4096

sdf 4096

├─sdf1 4096

└─sdf9 4096

sdg 4096

├─sdg1 4096

└─sdg9 4096

sdh 4096

├─sdh1 4096

└─sdh9 4096

zd0 8192

├─zd0p1 8192

├─zd0p2 8192

└─zd0p3 8192

zd16 8192

├─zd16p1 8192

├─zd16p2 8192

└─zd16p3 8192

zd32 8192

├─zd32p1 8192

└─zd32p2 8192

zd48 8192

├─zd48p1 8192

├─zd48p2 8192

└─zd48p5 8192zpool get all

Bash:

zpool get all

NAME PROPERTY VALUE SOURCE

rpool size 89G -

rpool capacity 4% -

rpool altroot - default

rpool health ONLINE -

rpool guid 7742339487758465282 -

rpool version - default

rpool bootfs rpool/ROOT/pve-1 local

rpool delegation on default

rpool autoreplace off default

rpool cachefile - default

rpool failmode wait default

rpool listsnapshots off default

rpool autoexpand off default

rpool dedupratio 1.00x -

rpool free 84.9G -

rpool allocated 4.13G -

rpool readonly off -

rpool ashift 12 local

rpool comment - default

rpool expandsize - -

rpool freeing 0 -

rpool fragmentation 6% -

rpool leaked 0 -

rpool multihost off default

rpool checkpoint - -

rpool load_guid 1987574620616317429 -

rpool autotrim off default

rpool feature@async_destroy enabled local

rpool feature@empty_bpobj active local

rpool feature@lz4_compress active local

rpool feature@multi_vdev_crash_dump enabled local

rpool feature@spacemap_histogram active local

rpool feature@enabled_txg active local

rpool feature@hole_birth active local

rpool feature@extensible_dataset active local

rpool feature@embedded_data active local

rpool feature@bookmarks enabled local

rpool feature@filesystem_limits enabled local

rpool feature@large_blocks enabled local

rpool feature@large_dnode enabled local

rpool feature@sha512 enabled local

rpool feature@skein enabled local

rpool feature@edonr enabled local

rpool feature@userobj_accounting active local

rpool feature@encryption enabled local

rpool feature@project_quota active local

rpool feature@device_removal enabled local

rpool feature@obsolete_counts enabled local

rpool feature@zpool_checkpoint enabled local

rpool feature@spacemap_v2 active local

rpool feature@allocation_classes enabled local

rpool feature@resilver_defer enabled local

rpool feature@bookmark_v2 enabled local

rpool feature@redaction_bookmarks enabled local

rpool feature@redacted_datasets enabled local

rpool feature@bookmark_written enabled local

rpool feature@log_spacemap active local

rpool feature@livelist enabled local

rpool feature@device_rebuild enabled local

rpool feature@zstd_compress enabled local

tank size 16.4T -

tank capacity 15% -

tank altroot - default

tank health ONLINE -

tank guid 7397998612028867886 -

tank version - default

tank bootfs - default

tank delegation on default

tank autoreplace off default

tank cachefile - default

tank failmode wait default

tank listsnapshots off default

tank autoexpand off default

tank dedupratio 1.00x -

tank free 13.9T -

tank allocated 2.48T -

tank readonly off -

tank ashift 0 default

tank comment - default

tank expandsize - -

tank freeing 0 -

tank fragmentation 1% -

tank leaked 0 -

tank multihost off default

tank checkpoint - -

tank load_guid 1698562018897266983 -

tank autotrim off default

tank feature@async_destroy enabled local

tank feature@empty_bpobj active local

tank feature@lz4_compress active local

tank feature@multi_vdev_crash_dump enabled local

tank feature@spacemap_histogram active local

tank feature@enabled_txg active local

tank feature@hole_birth active local

tank feature@extensible_dataset active local

tank feature@embedded_data active local

tank feature@bookmarks enabled local

tank feature@filesystem_limits enabled local

tank feature@large_blocks enabled local

tank feature@large_dnode enabled local

tank feature@sha512 enabled local

tank feature@skein enabled local

tank feature@edonr enabled local

tank feature@userobj_accounting active local

tank feature@encryption enabled local

tank feature@project_quota active local

tank feature@device_removal enabled local

tank feature@obsolete_counts enabled local

tank feature@zpool_checkpoint enabled local

tank feature@spacemap_v2 active local

tank feature@allocation_classes enabled local

tank feature@resilver_defer enabled local

tank feature@bookmark_v2 enabled local

tank feature@redaction_bookmarks enabled local

tank feature@redacted_datasets enabled local

tank feature@bookmark_written enabled local

tank feature@log_spacemap active local

tank feature@livelist enabled local

tank feature@device_rebuild enabled local

tank feature@zstd_compress enabled localashift=12 anlegen oder?Bei der Installation von PVE, meine ich, könnte man auch ne Size angeben. Hier würden zwei SSD sdb und sdc genommen. Hier (die wahrscheinlich schon oft gefragte) Frage: Haben die SSD wirklich 512 Blocksize oder ist das einfach ein gefakter Wert beim auslesen und ich muss die mal beim hersteller nachschauen.

Wenn ich wüsste mit welchen Einstellungen, dann würde ich die Daten backupen, die entsprechenden Pools neu erstellen und die Daten wieder zurückholen. Beim Datenpool klar, beim root-Pool muss ich noch grübeln, wie das am besten geht...

Ausserdem: Es sind Consumer SSDs. Kann ich das Wearout irgendwo nachvollziehen, ob die mir gerade schnell kaputt gehen und ich gegen Enterprise tauschen muss? Ich sehe unter DISKS nicht wirklich was. Wie stelle ich das "Schnelle Kaputtgehen" denn fest, was so oft zitiert wird.

Last edited: