Hallo,

wir möchten auf Proxmox umsteigen und haben eine POC aufgebaut

Aktuell laufen die VMs noch auf vSphere und Intel CPUs, das neue System basiert auf AMD CPUs.

Nun brauchen die Tests auf dem neuen System doppelt so lange als wie auf dem Alten.

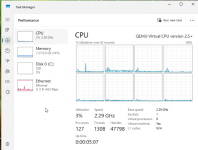

Meine aktuelle Konfiguration sieht folgendermaßen aus.

(Ich hatte die VM auch schon in einer RamDisk um das iSCSI Storage auszuschließen)

Danke!

Thomas

wir möchten auf Proxmox umsteigen und haben eine POC aufgebaut

Aktuell laufen die VMs noch auf vSphere und Intel CPUs, das neue System basiert auf AMD CPUs.

Nun brauchen die Tests auf dem neuen System doppelt so lange als wie auf dem Alten.

Meine aktuelle Konfiguration sieht folgendermaßen aus.

(Ich hatte die VM auch schon in einer RamDisk um das iSCSI Storage auszuschließen)

Code:

agent: 1

balloon: 0

bios: ovmf

boot: order=scsi0

cores: 4

cpu: host,flags=+aes

efidisk0: me5024_lvm_raid10:vm-105-disk-1,efitype=4m,pre-enrolled-keys=1,size=4M

ide2:

machine: pc-q35-10.0

memory: 16384

meta: creation-qemu=10.0.2,ctime=1763049569

name:

net0: virtio=BC:24:D3:C2:F3:E9,bridge=vmbr0,firewall=1,queues=4

numa: 1

numa0: cpus=0-3,memory=16384

ostype: win11

scsi0: me5024_lvm-thin_raid10:vm-105-disk-0,iothread=1,size=80G

scsi1: me5024_lvm_raid10:vm-105-disk-0,iothread=1,size=150G

scsihw: virtio-scsi-single

smbios1: uuid=ac9c82b9-b286-4cf3-8d54-1eb4e387b11a

sockets: 1

tpmstate0: me5024_lvm_raid10:vm-105-disk-2,size=4M,version=v2.0

vga: virtio,memory=64

vmgenid: 6f5de142-7938-4241-9d92-1ba68a2577a3Danke!

Thomas

Last edited: