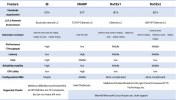

von blockbridge gibts auch einen interessanten vergleich. die sind ja nun spezialisiert auf NVMe. ich bin enttäuscht. nvme over tcp schneidet da nicht besonders herausragend ab. Scheint als hätten sie auch keine offloading functions aktiviert. Das wäre noch interessant gewesen. Die CPU-Auslastung haben sie auch nicht gemessen. https://kb.blockbridge.com/technote/proxmox-iscsi-vs-nvmetcp/

Ein weiterer Vergleich zu iscsi bietet DELL. Dort sieht man auch die CPU-Last. Überraschend ist der kleine Unterschied bei mtu 1500 und 9000.

https://www.delltechnologies.com/as...892-nvme-transport-performance-comparison.pdf

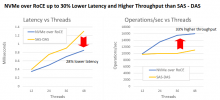

Hier ist noch ein Vergleich von NVMe over RoCE vs DAS - SAS SSD. Hier vergleicht man zwar NVMe mit SSD im Backround, aber allemal beeindruckend.

Ein weiterer Vergleich zu iscsi bietet DELL. Dort sieht man auch die CPU-Last. Überraschend ist der kleine Unterschied bei mtu 1500 und 9000.

https://www.delltechnologies.com/as...892-nvme-transport-performance-comparison.pdf

Hier ist noch ein Vergleich von NVMe over RoCE vs DAS - SAS SSD. Hier vergleicht man zwar NVMe mit SSD im Backround, aber allemal beeindruckend.

Last edited: