100G / 40G interne Netzstruktur mit schlechten iperf3 Resultaten

- Thread starter otherwisegg

- Start date

You are using an out of date browser. It may not display this or other websites correctly.

You should upgrade or use an alternative browser.

You should upgrade or use an alternative browser.

Also die Cross Verbindung ist ja nur für den Cluster, Live Migration und eventuell ZFS Replika.auto vmbr0

iface vmbr0 inet static

address 192.168.102.1/22

gateway 192.168.100.254

bridge-ports enp129s0f1np1

bridge-stp off

bridge-fd 0

auto vmbr1

iface vmbr1 inet static

address 192.168.233.1/24

bridge-ports enp129s0f0np0

bridge-stp off

bridge-fd 0

#Server Cross

auto vmbr2

iface vmbr2 inet static

address 192.168.240.1/24

bridge-ports enp161s0f0np0

bridge-stp off

bridge-fd 0

Da dann bitte keine vmbr nutzen, da diese deinen Traffic auf ca 40 GBit limitiert.

Bei den Migration Settings unter Datacenter hast du bestimmt das richtige Netzwerk angegeben, da bitte auf insecure setzen, da der Traffic bei einer Direktverbindung nicht verschlüsselt sein muss und die Verschlüsselung auch stark bremst, je nach Single Core Performance der CPU.

Da der Rest des setups sauber aussieht, schildere mal die Probleme mit den Windows Servern genauer. Eventuell fehlt uns nur ein Detail um auf die richtige Idee zu kommen.

Guten Morgen,

Erstmal Danke für die ganzen Empfehlungen.

Ab 12 bin ich beim Kunden bis 17-17:30 - Dann berichte ich!

Erstmal Danke für die ganzen Empfehlungen.

Ab 12 bin ich beim Kunden bis 17-17:30 - Dann berichte ich!

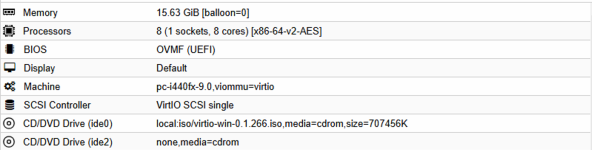

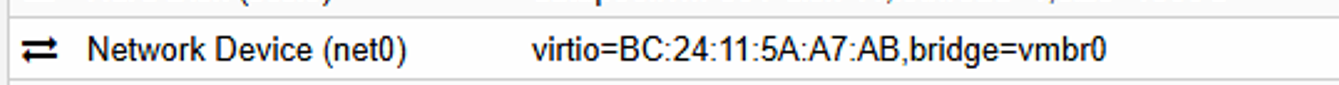

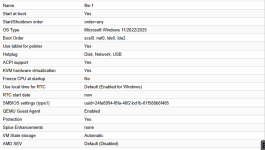

Wir haben einige Windows VMs. Als Beispiel nehmen wir jetzt den file-1, welcher bereits Daten migriert bekommen hat, aber noch nicht im Einsatz ist.Also die Cross Verbindung ist ja nur für den Cluster, Live Migration und eventuell ZFS Replika.

Da dann bitte keine vmbr nutzen, da diese deinen Traffic auf ca 40 GBit limitiert.

Bei den Migration Settings unter Datacenter hast du bestimmt das richtige Netzwerk angegeben, da bitte auf insecure setzen, da der Traffic bei einer Direktverbindung nicht verschlüsselt sein muss und die Verschlüsselung auch stark bremst, je nach Single Core Performance der CPU.

Da der Rest des setups sauber aussieht, schildere mal die Probleme mit den Windows Servern genauer. Eventuell fehlt uns nur ein Detail um auf die richtige Idee zu kommen.

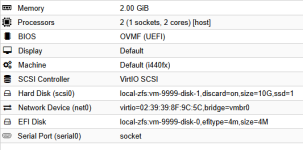

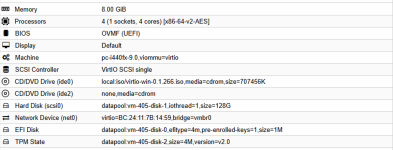

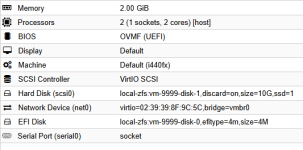

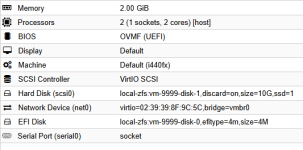

Folgende Konfiguration ist im Einsatz:

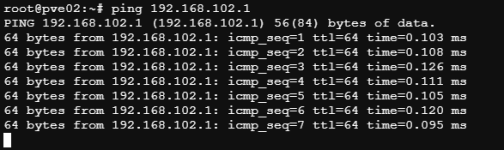

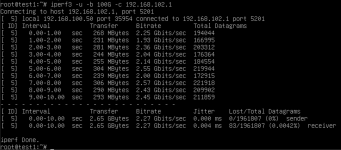

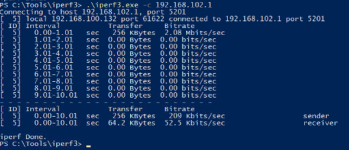

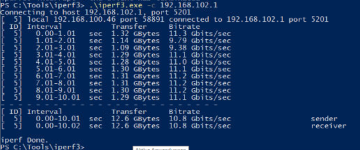

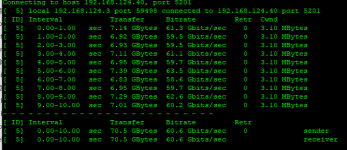

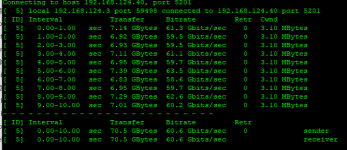

Hier haben wir folgende iperf Resultate wenn wir den eigenen pve01 Host (192.168.102.1) ansprechen:

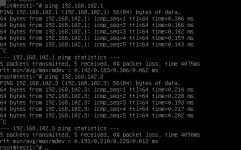

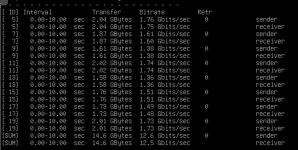

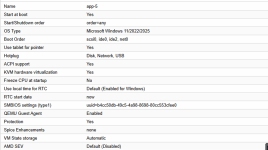

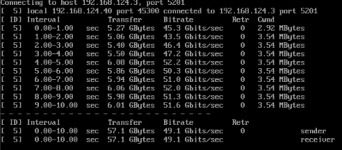

Kommen wir z.B zum Server app5:

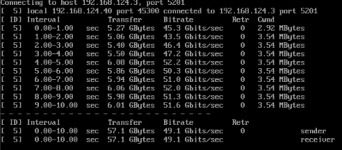

Hier erzielen wir beim gleichen iperf Test folgende Resultate:

Du meinst die vmbr für die Crossverkabelung? Da würde ich das Netzwerk ja nicht für VMs nutzen sondern für Replikation, korrekt?Da dann bitte keine vmbr nutzen, da diese deinen Traffic auf ca 40 GBit limitiert.

Den Mode von secure auf insecure, ist dafür nen Neustart nötig? Muss ja so wie ich es sehe via CLI passieren.

Tatsächlich ist unter Replikation kein Netzwerk angegeben, da würde ich jetzt die Crossverkabelung nutzen.

Last edited:

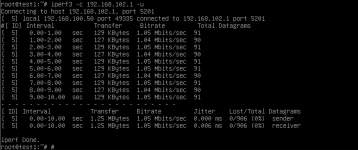

Das hatte ich glaub schon in einem Reply auf Seite 1 erwähnt, dass nach einem Tausch der MAC-Adressen (Also Test1 MAC bekommt Test2, und Test2 MAC bekommt Test1) wir Traffic auf beiden Maschinen durchbekommen. Leider nichtmal annähernd die Geschwindigkeiten von 100G die wir uns vorstellen.Unten die beiden SUM zeilen sind wichtig. Aber jetzt bekommst du doch Traffic mit TCP auf die Leitung. Für mich sieht eher nicht nach einem Problem in der Netzwerkstruktur aus, sondern nach einem Softwareproblem mit iperf3.

Das Problem besteht weiterhin bei den Windows Maschinen.

Kennst du alternativen für iperf?

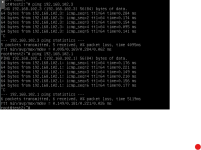

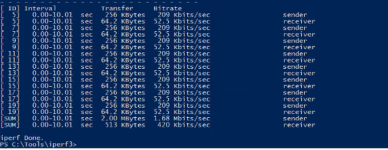

Habe jetzt mal bei mir eine debian 12 vm erstellt. Allerdings ohne Cluster und nur mit 10GB. Auf dem selben Gerät von test zu pve

und von pve zu test

Hilft jetzt zwar nicht direkt, aber hast du mal bei der test vm den Hostprozessor versucht. Ich kanns leider nicht testen, da Intel. Und wenn die VM auf dem selben Host läuft, dann sollte die Netzwerkgeschwindigkeit irrelevant sein. Die einzige Komponente, die bei mir annähernd diese Geschwindigkeiten erreicht, ist der RAM.

Was sagt denn

?

und von pve zu test

Hilft jetzt zwar nicht direkt, aber hast du mal bei der test vm den Hostprozessor versucht. Ich kanns leider nicht testen, da Intel. Und wenn die VM auf dem selben Host läuft, dann sollte die Netzwerkgeschwindigkeit irrelevant sein. Die einzige Komponente, die bei mir annähernd diese Geschwindigkeiten erreicht, ist der RAM.

Was sagt denn

Code:

iptables -L -vAttachments

Ich hab jetzt nicht den ganzen Thread durchgelesen, aber vielleicht hiflt der Hinweis:

Aus

Und wenn es um schnelle Netze geht, muss man da mitunter mit mehr als einem Thread testen. Deshalb vielleich auch mal mit

iperf3 in den Versionen wie man sie mit Proxmox VE 8 / Debian 12 bekommt, ist nicht multithreaded!Aus

man iperf3:-P, --parallel n

number of parallel client streams to run. Note that iperf3 is single threaded, so if you are CPU bound, this will not yield higher throughput.

Und wenn es um schnelle Netze geht, muss man da mitunter mit mehr als einem Thread testen. Deshalb vielleich auch mal mit

iperf (ohne 3) und dem -P Parameter mal testen.Wir haben jetzt noch einiges umgestellt, die Netzwerkkarten ausgetauscht mit neuen & die gesamte Infrastruktur neugestartet inklusive allen Clients und jetzt erreichen wir 60-80G. Woran es letzendlich lag, Sehr gute Frage. Wir testen die NICs jetzt seperat nochmal durch.

Ich bedanke mich bei euch für die fleißige Hilfe und vielleicht hätten wir uns das komplett erspart wenn wir die NICs schon früher eingebaut hätten, aber welcher Kunde bestätigt schon ~500€ ohne Troubleshooting vorher

Liebe Grüße mit ein bisschen Frust aus Hannover,

Benjamin

Ich bedanke mich bei euch für die fleißige Hilfe und vielleicht hätten wir uns das komplett erspart wenn wir die NICs schon früher eingebaut hätten, aber welcher Kunde bestätigt schon ~500€ ohne Troubleshooting vorher

Liebe Grüße mit ein bisschen Frust aus Hannover,

Benjamin

Für Windows 2022 und neuer empfehle ich nicht den x86-64 CPU Typ zu nutzen. Da zickt windows ab und zu, bei Server 2025 gibt#s noch deutlich mehr Probleme.

Am besten immer CPU Typ

host nutzen, außer du hast einen heterogenen Cluster und dann den kleinsten gemeinsamen Nenner der CPUs nutzen.Jupp.Du meinst die vmbr für die Crossverkabelung? Da würde ich das Netzwerk ja nicht für VMs nutzen sondern für Replikation, korrekt?

Nein einfach in der /etc/pve/datacenter.cfg ändern. Wenn du vorher in Der GUI das Netzwerk eingestellt hast, brauchst du nurDen Mode von secure auf insecure, ist dafür nen Neustart nötig? Muss ja so wie ich es sehe via CLI passieren.

in vor dem secure eintippen. Also unter Datacenter > Options > Migration Settings auswählen. Am besten die IP direkt vergeben ohne Bridge.Tatsächlich ist unter Replikation kein Netzwerk angegeben, da würde ich jetzt die Crossverkabelung nutzen.