Hallo Zusammen,

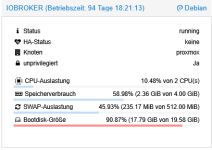

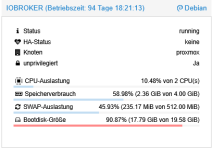

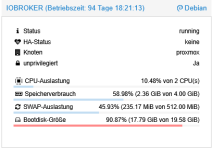

ich habe versucht,mich etwas mit der Thematik LVM auseinanderzusetzen, weil mir aufgefallen ist, das die Bootdisk-Größe von einem meiner Container recht voll zu sein scheint.

Jetzt habe ich aber,trotz Onkel Google, noch ein paar Fragezeichen.

Hier meine kurze Zusammenfassung von meinem bisherigen Verständnis:

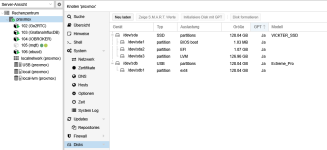

Ich habe eine 128GB SSD verbaut. Darauf läuft nur Proxmox mit seinen Containern. Ich bin mir ziemlich sicher, das ich beim Aufsetzen aus Unwissenheit nicht alles richtig eingestellt habe.

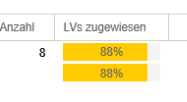

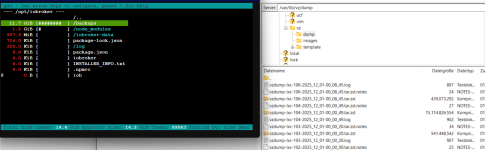

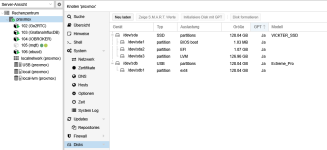

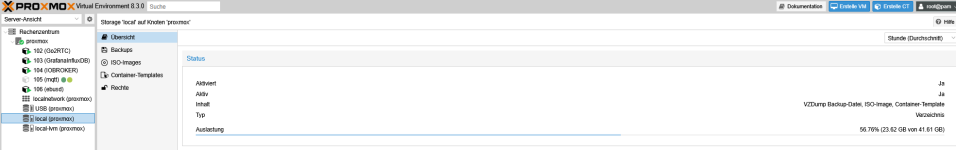

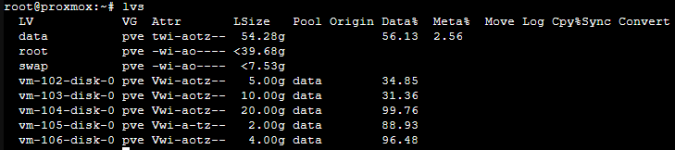

Sieht man hier, das "Proxmox" insgesamt 126,96GB zugewiesen ist und zur Verfügung steht?

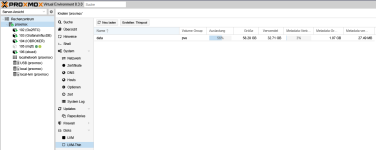

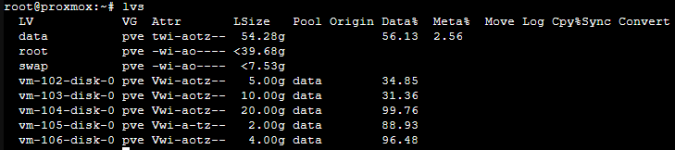

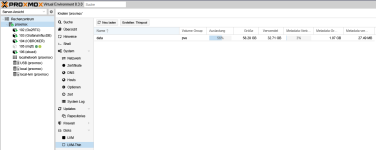

Diese Übersicht habe ich nicht ganz verstanden. Bedeutet das, das ich insgesamt, also mit allen Containern + Backups, usw, aktuell ca.110GB belegt habe?

Wenn ich die einzelnen Werte zusammenrechne, komme ich jedenfalls nicht auf die ca.110GB. Aber zugewiesen heißt nicht gleich belegt,oder?

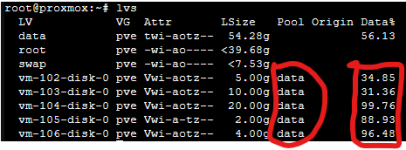

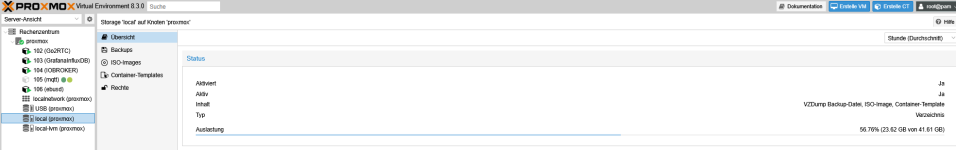

Jetzt komme ich zur Unterscheidung zwischen local und local-lvm

Hier bei local liegen die Backups,Templates der Container?

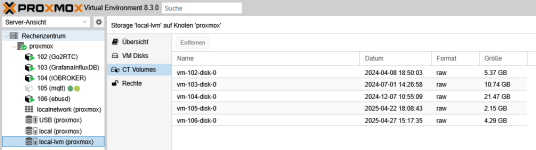

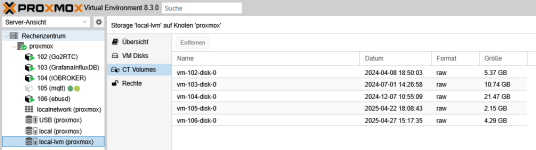

Hier bei local-lvm wird der Speicher für die einzelnen Container samt Inhalt belegt.

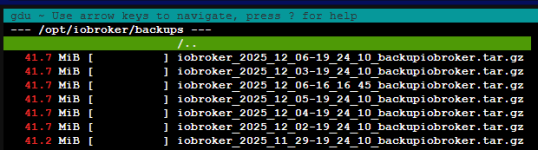

Und hier kommt jetzt ein weiteres Fragezeichen. Die Größenwerte aus dem Bild oben weichen von den werten ab, die ich beim erstellen der einzelen Containern zugewiesen habe:

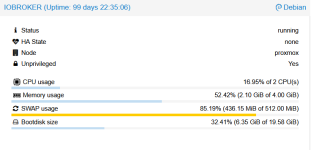

Z.B. mein IOBROKER Container 104. Da gibt es eine Abweichung von 1,47GB. Demnach würde ja mehr Speicher gerade genutzt, als eigentlich zur Verfügung steht. Ist das dann auch der Grund, warum meine Bootdisk-Größe schon rot ist?:

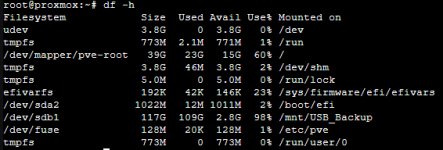

Ich versuche jetzt irgendwie zu verstehen, wieviel Speicher ich noch zur Verfügung hätte, um die Bootdsik-Größe des Containers zu erweitern und ob ich überhaupt noch Speicherplatz frei habe.

Ich hoffe ich habe Aussagekräftige Screenshots gemacht und das ioch mit meinen Annahmen zumindest nicht komplett daneben hänge

Vielen Dank schon einmal im Voraus und viele Grüße

ich habe versucht,mich etwas mit der Thematik LVM auseinanderzusetzen, weil mir aufgefallen ist, das die Bootdisk-Größe von einem meiner Container recht voll zu sein scheint.

Jetzt habe ich aber,trotz Onkel Google, noch ein paar Fragezeichen.

Hier meine kurze Zusammenfassung von meinem bisherigen Verständnis:

Ich habe eine 128GB SSD verbaut. Darauf läuft nur Proxmox mit seinen Containern. Ich bin mir ziemlich sicher, das ich beim Aufsetzen aus Unwissenheit nicht alles richtig eingestellt habe.

Sieht man hier, das "Proxmox" insgesamt 126,96GB zugewiesen ist und zur Verfügung steht?

Diese Übersicht habe ich nicht ganz verstanden. Bedeutet das, das ich insgesamt, also mit allen Containern + Backups, usw, aktuell ca.110GB belegt habe?

Wenn ich die einzelnen Werte zusammenrechne, komme ich jedenfalls nicht auf die ca.110GB. Aber zugewiesen heißt nicht gleich belegt,oder?

Jetzt komme ich zur Unterscheidung zwischen local und local-lvm

Hier bei local liegen die Backups,Templates der Container?

Hier bei local-lvm wird der Speicher für die einzelnen Container samt Inhalt belegt.

Und hier kommt jetzt ein weiteres Fragezeichen. Die Größenwerte aus dem Bild oben weichen von den werten ab, die ich beim erstellen der einzelen Containern zugewiesen habe:

Z.B. mein IOBROKER Container 104. Da gibt es eine Abweichung von 1,47GB. Demnach würde ja mehr Speicher gerade genutzt, als eigentlich zur Verfügung steht. Ist das dann auch der Grund, warum meine Bootdisk-Größe schon rot ist?:

Ich versuche jetzt irgendwie zu verstehen, wieviel Speicher ich noch zur Verfügung hätte, um die Bootdsik-Größe des Containers zu erweitern und ob ich überhaupt noch Speicherplatz frei habe.

Ich hoffe ich habe Aussagekräftige Screenshots gemacht und das ioch mit meinen Annahmen zumindest nicht komplett daneben hänge

Vielen Dank schon einmal im Voraus und viele Grüße