Hallo zusammen.

Wir haben den externen Speicher per iSCSI an den PBS angebunden.

Super Geschwindigkeit, zuverlässig usw.

Das lief die letzten Monate echt super, bis jetzt innerhalb von 1 Woche 2x kurz (unter einer Minute) der Strom weg war.

In diesem Fall heißt das, dass die Synology nur vom Netzwerk getrennt wurde, da der Switch nicht an einer USV hängt.

Jetzt zum eigentlichen Problem.

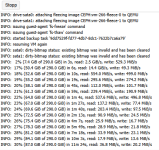

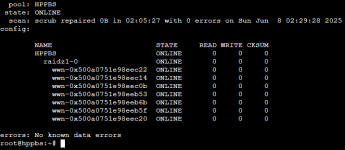

Nachdem alles wieder erreichbar war, war der iSCSI Speicher auf dem PVE nicht mehr verfügbar und im PBS war das ZFS weg.

Somit leider auch die Backups.

Hat jemand eine Idee wie man sowas vorbeugen kann, oder warum das iSCSI Laufwerk nicht mehr eingebunden werden kann?

Auch ein kompletter Neustart hat nichts gebracht.

Vielen Dank

Wir haben den externen Speicher per iSCSI an den PBS angebunden.

Super Geschwindigkeit, zuverlässig usw.

Das lief die letzten Monate echt super, bis jetzt innerhalb von 1 Woche 2x kurz (unter einer Minute) der Strom weg war.

In diesem Fall heißt das, dass die Synology nur vom Netzwerk getrennt wurde, da der Switch nicht an einer USV hängt.

Jetzt zum eigentlichen Problem.

Nachdem alles wieder erreichbar war, war der iSCSI Speicher auf dem PVE nicht mehr verfügbar und im PBS war das ZFS weg.

Somit leider auch die Backups.

Hat jemand eine Idee wie man sowas vorbeugen kann, oder warum das iSCSI Laufwerk nicht mehr eingebunden werden kann?

Auch ein kompletter Neustart hat nichts gebracht.

Vielen Dank