Moin Freunde!

Wir haben eine ganz komische Situation bei uns wie folgt:

Wir haben ein 2 Etagen Büro mit den Servern im 3. Stock + Büro mit 100G interne Anbindung (100G Mikrotik Switch & 100G SPF Module) und ein Büro im Erdgeschoss welches ein Uplink aus dem 3. Stock mit 100G bekommt.

Cluster aus 2 PVE's mit folgenden Stats:

pve01

- AMD EPYC 9124 16 Core (2 Sockets)

- 512GB DDR5 RAM

- NVMe SSD's

- BCM57508 NetXtreme-E 10Gb/25Gb/40Gb/50Gb/100Gb/200Gb Ethernet NIC

pve02

- AMD EPYC 9124 16 Core (2 Sockets)

- 512GB DDR5 RAM

- NVMe SSD's

- BCM57508 NetXtreme-E 10Gb/25Gb/40Gb/50Gb/100Gb/200Gb Ethernet NIC

Wir haben beide Server, trotz Cluster, aus Testgründen Crossverkabelt und jeweils auf beiden Servern eine Test Linux Maschine.

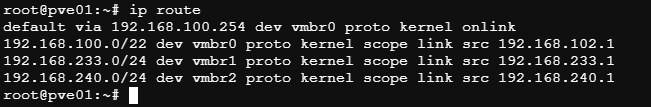

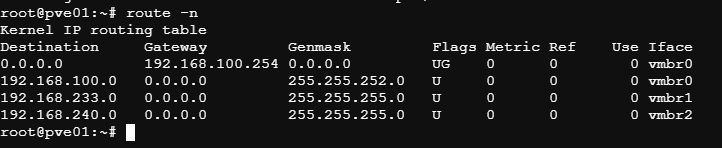

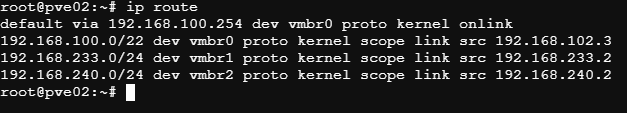

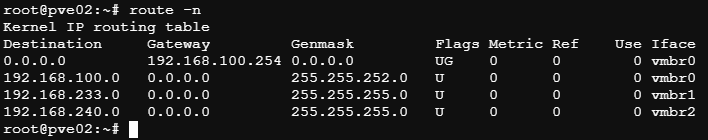

Unsere onboard NIC ist deaktiviert, es wird ausschließlich die nachinstallierte NIC benutzt. Dementsprechend sind auch die Bridges eingerichtet.

Wir haben die beiden PVEs mit jeweils 1x 100G an den 100G Switch angebunden, davon geht ein LWL Kabel als Uplink an 3. OG LAN Switch, und ein LWL Kabel als Uplink mit 100G ins EG.

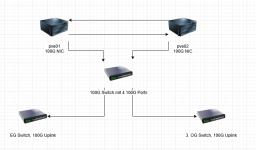

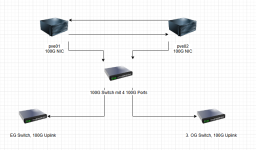

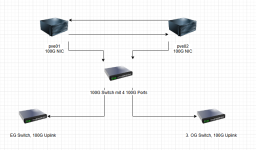

Ungefährer Aufbau:

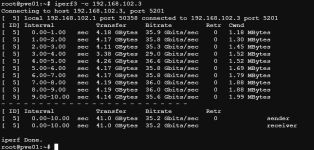

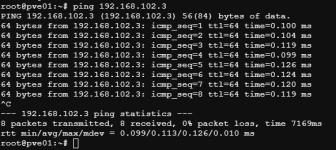

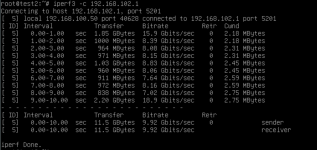

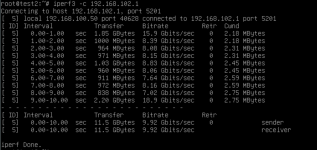

Auf den Linux Maschinen sieht das nochmal anders aus, Dabei bekommen wir von der Testmaschine auf pve02 mit einem iperf auf pve01 direkt:

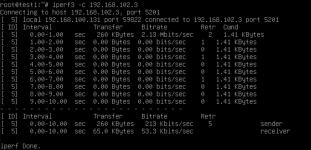

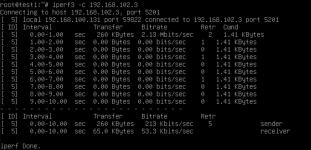

Auf dem pve01 TestVM, welche ein iperf zum pve02 Host macht:

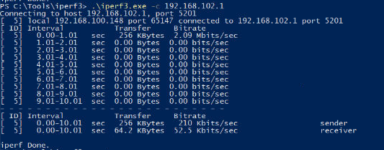

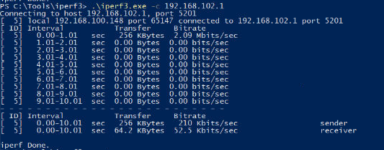

Windows VM auf seinen eigenen Host, gleiches auf den zweiten Host.

Wir haben bereits über alle Schnittstellen auch die Crossverkabelung alles probiert, mit der Negotiation rumgespielt, neuen 100G Switch zwischengebastelt.

Wenn wir die VMs miteinander Migrieren, also test1 auf pve02 und test2 auf pve01, bleibt das ganze genau gleich.

Wir wissen einfach nichtmehr weiter. Unser nächster Schritt wäre die NICs auszutauschen zu Mellanox NICs, aber bevor wir das machen dachten wir, wir fragen mal nach ob einer noch Ideen hat.

Falls irgendwelche Infos benötigt werden, sagt einfach Bescheid.

Danke euch schonmal für euren Input!

Liebe Grüße aus Hannover,

Benjamin

Wir haben eine ganz komische Situation bei uns wie folgt:

Wir haben ein 2 Etagen Büro mit den Servern im 3. Stock + Büro mit 100G interne Anbindung (100G Mikrotik Switch & 100G SPF Module) und ein Büro im Erdgeschoss welches ein Uplink aus dem 3. Stock mit 100G bekommt.

Cluster aus 2 PVE's mit folgenden Stats:

pve01

- AMD EPYC 9124 16 Core (2 Sockets)

- 512GB DDR5 RAM

- NVMe SSD's

- BCM57508 NetXtreme-E 10Gb/25Gb/40Gb/50Gb/100Gb/200Gb Ethernet NIC

pve02

- AMD EPYC 9124 16 Core (2 Sockets)

- 512GB DDR5 RAM

- NVMe SSD's

- BCM57508 NetXtreme-E 10Gb/25Gb/40Gb/50Gb/100Gb/200Gb Ethernet NIC

Wir haben beide Server, trotz Cluster, aus Testgründen Crossverkabelt und jeweils auf beiden Servern eine Test Linux Maschine.

Unsere onboard NIC ist deaktiviert, es wird ausschließlich die nachinstallierte NIC benutzt. Dementsprechend sind auch die Bridges eingerichtet.

Wir haben die beiden PVEs mit jeweils 1x 100G an den 100G Switch angebunden, davon geht ein LWL Kabel als Uplink an 3. OG LAN Switch, und ein LWL Kabel als Uplink mit 100G ins EG.

Ungefährer Aufbau:

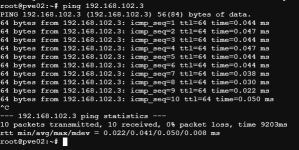

Auf den Linux Maschinen sieht das nochmal anders aus, Dabei bekommen wir von der Testmaschine auf pve02 mit einem iperf auf pve01 direkt:

Auf dem pve01 TestVM, welche ein iperf zum pve02 Host macht:

Windows VM auf seinen eigenen Host, gleiches auf den zweiten Host.

Wir haben bereits über alle Schnittstellen auch die Crossverkabelung alles probiert, mit der Negotiation rumgespielt, neuen 100G Switch zwischengebastelt.

Wenn wir die VMs miteinander Migrieren, also test1 auf pve02 und test2 auf pve01, bleibt das ganze genau gleich.

Wir wissen einfach nichtmehr weiter. Unser nächster Schritt wäre die NICs auszutauschen zu Mellanox NICs, aber bevor wir das machen dachten wir, wir fragen mal nach ob einer noch Ideen hat.

Falls irgendwelche Infos benötigt werden, sagt einfach Bescheid.

Danke euch schonmal für euren Input!

Liebe Grüße aus Hannover,

Benjamin

Last edited: