Hallo zusammen,

Heute habe ich mit Ceph in der shell gespielt und ein rbd image mit striping erstellt im pool "rbd"

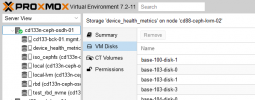

Plötzlich sehe ich in der Proxmox GUI alle Images die im Pool RBD sind doppelt im Pool "device_health_metrics" ?!

Wenn ich

ausführe dann sind dort keine images und der pool ist leer.

Irgendwie hat das commando

die GUI Proxmox Datenbank durcheinander gebracht.

Wenn ich über die GUI die Images lösche im Pool "device_health_metrics" dann werden die original Images im Pool RBD gelöscht.

Irgendwie schreit das doch nach einem Bug.

Hat das jemand schonmal gehabt?

Weiß jemand wie man das korrigieren kann?

danke im voraus für Antworten,

lightmans

Heute habe ich mit Ceph in der shell gespielt und ein rbd image mit striping erstellt im pool "rbd"

Code:

rbd create test_rbd_nvme/vm-105-disk-1 --size 102400 --stripe-unit 65536B --stripe-count 4Plötzlich sehe ich in der Proxmox GUI alle Images die im Pool RBD sind doppelt im Pool "device_health_metrics" ?!

Wenn ich

Code:

rbd ls -l device_health_metricsIrgendwie hat das commando

Code:

qm rescanWenn ich über die GUI die Images lösche im Pool "device_health_metrics" dann werden die original Images im Pool RBD gelöscht.

Irgendwie schreit das doch nach einem Bug.

Hat das jemand schonmal gehabt?

Weiß jemand wie man das korrigieren kann?

danke im voraus für Antworten,

lightmans