Hallo beisammen,

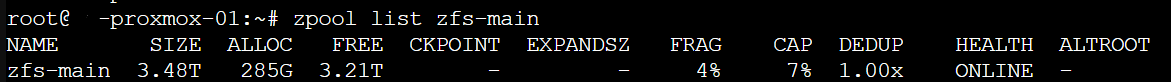

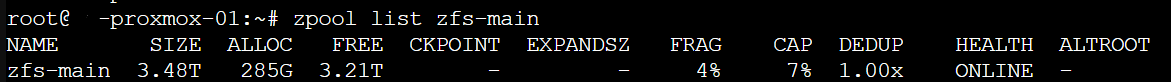

wir haben aus drei 1,92TB Platten ein ZFS-Pool erstellt. Pool Liste zeigt an, dass no 3,21 T frei sind:

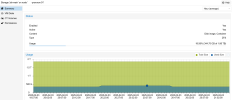

Bei Usage stehen allerdings nur 1,86T instgesamt:

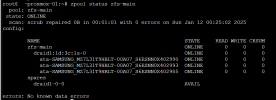

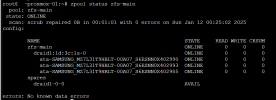

Das ist der Pool Status:

Warum gibt es hier ein Unterschied?

Kann man das korrigieren, dass man den kompletten speicher verwenden kann?

Vielen Dank im Voraus.

Gruß

ProAdmin

wir haben aus drei 1,92TB Platten ein ZFS-Pool erstellt. Pool Liste zeigt an, dass no 3,21 T frei sind:

Bei Usage stehen allerdings nur 1,86T instgesamt:

Das ist der Pool Status:

Warum gibt es hier ein Unterschied?

Kann man das korrigieren, dass man den kompletten speicher verwenden kann?

Vielen Dank im Voraus.

Gruß

ProAdmin