mount

sysfs on /sys type sysfs (rw,nosuid,nodev,noexec,relatime)

proc on /proc type proc (rw,relatime)

udev on /dev type devtmpfs (rw,nosuid,relatime,size=15574940k,nr_inodes=3893735,mode=755,inode64)

devpts on /dev/pts type devpts (rw,nosuid,noexec,relatime,gid=5,mode=620,ptmxmode=000)

tmpfs on /run type tmpfs (rw,nosuid,nodev,noexec,relatime,size=3121732k,mode=755,inode64)

/dev/mapper/pve-root on / type ext4 (rw,relatime,errors=remount-ro)

securityfs on /sys/kernel/security type securityfs (rw,nosuid,nodev,noexec,relatime)

tmpfs on /dev/shm type tmpfs (rw,nosuid,nodev,inode64)

tmpfs on /run/lock type tmpfs (rw,nosuid,nodev,noexec,relatime,size=5120k,inode64)

cgroup2 on /sys/fs/cgroup type cgroup2 (rw,nosuid,nodev,noexec,relatime)

pstore on /sys/fs/pstore type pstore (rw,nosuid,nodev,noexec,relatime)

bpf on /sys/fs/bpf type bpf (rw,nosuid,nodev,noexec,relatime,mode=700)

systemd-1 on /proc/sys/fs/binfmt_misc type autofs (rw,relatime,fd=30,pgrp=1,timeout=0,minproto=5,maxproto=5,direct,pipe_ino=19574)

hugetlbfs on /dev/hugepages type hugetlbfs (rw,relatime,pagesize=2M)

mqueue on /dev/mqueue type mqueue (rw,nosuid,nodev,noexec,relatime)

debugfs on /sys/kernel/debug type debugfs (rw,nosuid,nodev,noexec,relatime)

tracefs on /sys/kernel/tracing type tracefs (rw,nosuid,nodev,noexec,relatime)

sunrpc on /run/rpc_pipefs type rpc_pipefs (rw,relatime)

fusectl on /sys/fs/fuse/connections type fusectl (rw,nosuid,nodev,noexec,relatime)

configfs on /sys/kernel/config type configfs (rw,nosuid,nodev,noexec,relatime)

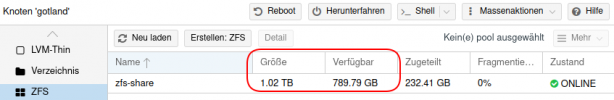

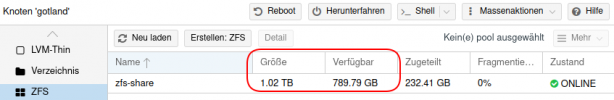

zfs-share on /zfs-share type zfs (rw,xattr,noacl)

lxcfs on /var/lib/lxcfs type fuse.lxcfs (rw,nosuid,nodev,relatime,user_id=0,group_id=0,allow_other)

/dev/fuse on /etc/pve type fuse (rw,nosuid,nodev,relatime,user_id=0,group_id=0,default_permissions,allow_other)

tmpfs on /run/user/0 type tmpfs (rw,nosuid,nodev,relatime,size=3121728k,nr_inodes=780432,mode=700,inode64)

zfs get mounted

NAME PROPERTY VALUE SOURCE

zfs-share mounted yes -

zfs-share/base-901-disk-0 mounted - -

zfs-share/base-901-disk-0@__base__ mounted - -

zfs-share/base-901-disk-1 mounted - -

zfs-share/base-901-disk-1@__base__ mounted - -

zfs-share/base-901-disk-2 mounted - -

zfs-share/base-901-disk-2@__base__ mounted - -

zfs-share/base-902-disk-0 mounted - -

zfs-share/base-902-disk-0@__base__ mounted - -

zfs-share/base-902-disk-1 mounted - -

zfs-share/base-902-disk-1@__base__ mounted - -

zfs-share/base-902-disk-2 mounted - -

zfs-share/base-902-disk-2@__base__ mounted - -

zfs-share/base-902-disk-3 mounted - -

zfs-share/base-902-disk-3@__base__ mounted - -

zfs-share/base-910-disk-0 mounted - -

zfs-share/base-910-disk-0@__base__ mounted - -

zfs-share/base-910-disk-1 mounted - -

zfs-share/base-910-disk-1@__base__ mounted - -

zfs-share/base-910-disk-2 mounted - -

zfs-share/base-910-disk-2@__base__ mounted - -

zfs-share/base-920-disk-0 mounted - -

zfs-share/base-920-disk-0@__base__ mounted - -

zfs-share/base-921-disk-0 mounted - -

zfs-share/base-921-disk-0@__base__ mounted - -

zfs-share/base-922-disk-0 mounted - -

zfs-share/base-922-disk-0@__base__ mounted - -

zfs-share/base-922-disk-1 mounted - -

zfs-share/base-922-disk-1@__base__ mounted - -

zfs-share/base-922-disk-2 mounted - -

zfs-share/base-922-disk-2@__base__ mounted - -

zfs-share/vm-105-disk-0 mounted - -

zfs-share/vm-108-disk-0 mounted - -

zfs-share/vm-108-disk-1 mounted - -

zfs-share/vm-108-disk-2 mounted - -

zfs-share/vm-109-disk-0 mounted - -

zfs-share/vm-109-disk-1 mounted - -

zfs-share/vm-109-disk-2 mounted - -

zfs-share/vm-110-disk-0 mounted - -

zfs-share/vm-110-disk-1 mounted - -

zfs-share/vm-110-disk-2 mounted - -

zfs-share/vm-111-disk-0 mounted - -

zfs-share/vm-111-disk-1 mounted - -

zfs-share/vm-111-disk-2 mounted - -

zfs-share/vm-111-disk-3 mounted - -

zfs-share/vm-112-disk-0 mounted - -

zfs-share/vm-112-disk-1 mounted - -

zfs-share/vm-112-disk-2 mounted - -

zfs-share/vm-113-disk-0 mounted - -

zfs-share/vm-113-disk-1 mounted - -

zfs-share/vm-114-disk-0 mounted - -

zfs-share/vm-114-disk-1 mounted - -

zfs-share/vm-114-disk-2 mounted - -

zfs-share/vm-115-disk-0 mounted - -

zfs-share/vm-117-disk-0 mounted - -

zfs-share/vm-119-disk-0 mounted - -

zfs-share/vm-119-disk-1 mounted - -

zfs-share/vm-121-disk-0 mounted - -

zfs-share/vm-121-disk-1 mounted - -

zfs-share/vm-121-disk-2 mounted - -

zfs-share/vm-122-disk-0 mounted - -

zfs-share/vm-122-disk-1 mounted - -

zfs-share/vm-122-disk-2 mounted - -

zfs-share/vm-123-disk-0 mounted - -

zfs-share/vm-123-disk-1 mounted - -

zfs-share/vm-123-disk-2 mounted - -

zfs-share/vm-124-disk-0 mounted - -

zfs-share/vm-124-disk-1 mounted - -

zfs-share/vm-124-disk-2 mounted - -

zfs-share/vm-900-disk-0 mounted - -

zfs-share/vm-900-disk-1 mounted - -