Hallo,

ich habe erst kürzlich proxmox installiert und beschäftige mich damit. Ich bin zwar durchaus IT-affin, aber sowas gab es "damals" noch nicht ... also alles Neuland.

Ich habe Proxmox aufgesetzt und verschiedene VMs und Container installiert. Vor allem wollte ich eine gute Basis für HA schaffen.

Mein Rechner ist zwar gut mit RAM ausgestattet, aber hat eine fest verbaute SSD die sehr schmal bemessen ist (alter iMac) und nicht aufgerüstet werden kann. So habe ich einen NVME-Speicher und Gehäuse gekauft und über Thunderbolt verbunden. Ausserdem hängt noch eine große HDD dran für Backups etc.

Disks-übersicht:

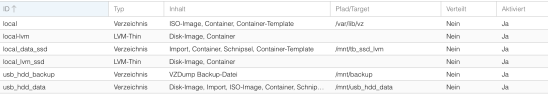

Der "Storage" Eintrag zeigt die Übersicht:

Soweit ich das sehen kann sind die Partitionen und Volumes zwar alle da - aber sie sind nicht miteinander verbunden. Sprich:

- local-lvm soll bestehen aus: local-lvm und local_lvm_ssd

- local soll bestehen aus: local, local_data_ssd und usb_hdd_data (wobei alles was man nicht für aktive Prozesse benötigt auf der HDD liegen soll).

- usb_hdd_backup ist eine eigene Partition nur für Backups

Wie verbinde ich diese zu den gemeinsamen Volumes? Eigentlich müsst ich doch local_lvm_ssd einfach zu local-lvm hinzufügen können und dann wird mir hier nur ein Eintrag gezeigt.

Wie kann ich nachträglich die Namen ändern? (Es war ein weiter Weg - try and error - bis hierhin und ich musste mehrfach die Namen ändern, weil die alten dann verbrannt waren - jetzt soll alles auf eine Logik gebracht werden).

Oder bin ich einen völlig falschen Weg gegangen diese Volumes separat anzulegen und es ist eigentlich viel einfacher zusätzlichen Speicherplatz zu bestehenden Volumes hinzuzufügen - nur kenne ich ihn nicht.

P.S.: auf den externen Speichern ist nichts drauf. Die kann ich problemlos platt machen wenn es sein soll. Und die VMs und Container sind zwar eingerichtet, aber auch das lässt sich alles nochmal neu aufsetzen - ich betreibe hier kein Raumfahrtprogramm und keine Atomforschung. Wirklich Arbeit steckt bisher nur in HomeAssistant und das kann ich aus einem Backup neu hochziehen.

ich habe erst kürzlich proxmox installiert und beschäftige mich damit. Ich bin zwar durchaus IT-affin, aber sowas gab es "damals" noch nicht ... also alles Neuland.

Ich habe Proxmox aufgesetzt und verschiedene VMs und Container installiert. Vor allem wollte ich eine gute Basis für HA schaffen.

Mein Rechner ist zwar gut mit RAM ausgestattet, aber hat eine fest verbaute SSD die sehr schmal bemessen ist (alter iMac) und nicht aufgerüstet werden kann. So habe ich einen NVME-Speicher und Gehäuse gekauft und über Thunderbolt verbunden. Ausserdem hängt noch eine große HDD dran für Backups etc.

Disks-übersicht:

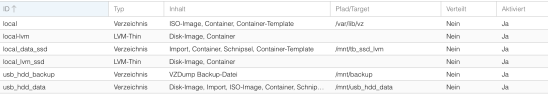

Der "Storage" Eintrag zeigt die Übersicht:

Soweit ich das sehen kann sind die Partitionen und Volumes zwar alle da - aber sie sind nicht miteinander verbunden. Sprich:

- local-lvm soll bestehen aus: local-lvm und local_lvm_ssd

- local soll bestehen aus: local, local_data_ssd und usb_hdd_data (wobei alles was man nicht für aktive Prozesse benötigt auf der HDD liegen soll).

- usb_hdd_backup ist eine eigene Partition nur für Backups

Wie verbinde ich diese zu den gemeinsamen Volumes? Eigentlich müsst ich doch local_lvm_ssd einfach zu local-lvm hinzufügen können und dann wird mir hier nur ein Eintrag gezeigt.

Wie kann ich nachträglich die Namen ändern? (Es war ein weiter Weg - try and error - bis hierhin und ich musste mehrfach die Namen ändern, weil die alten dann verbrannt waren - jetzt soll alles auf eine Logik gebracht werden).

Oder bin ich einen völlig falschen Weg gegangen diese Volumes separat anzulegen und es ist eigentlich viel einfacher zusätzlichen Speicherplatz zu bestehenden Volumes hinzuzufügen - nur kenne ich ihn nicht.

P.S.: auf den externen Speichern ist nichts drauf. Die kann ich problemlos platt machen wenn es sein soll. Und die VMs und Container sind zwar eingerichtet, aber auch das lässt sich alles nochmal neu aufsetzen - ich betreibe hier kein Raumfahrtprogramm und keine Atomforschung. Wirklich Arbeit steckt bisher nur in HomeAssistant und das kann ich aus einem Backup neu hochziehen.

Last edited: