Hallo,

ich stoße seit einiger zeit auf merkwürdige probleme, habe mich schon mit oomk usw auseinandergesetzt, schließe das aber eigentlich mittlerweile aus.

Erstmal das Problem:

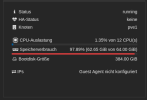

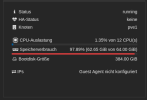

Ich habe so 1-2 VMs die wenn man sie startet regelmäßig einfach gekillt werden nach einer zeit (sieht man auch gut an den graphen, es waren keine shutdowns oder stops!)

in den stats der 2 vms sieht man das auf die woche gesehen nicht gut, da die vms nicht länger wie eine halbe stunden anbleiben und dann gekillt werden, es ist aber mittlerweile schon sehr oft aufgefallen, 10 mal oder mehr.

ich habe versucht nach oom logs zu suchen, mit einem einfachen `journalctl -x | grep *oom*`, dabei ist nichts rumgekommen. kein output, also kein match.

nebenbei versuche ich es wieder zu reproduzieren.

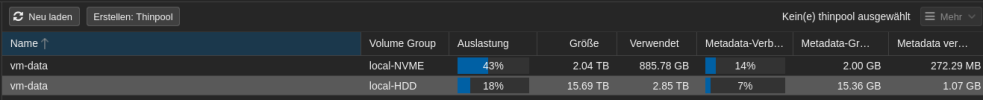

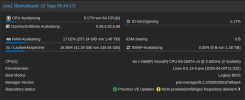

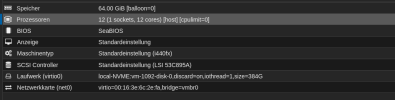

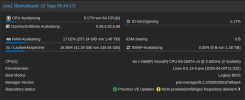

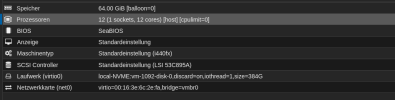

Ich möchte anmerken das ich kein problem mit RAM-Überbuchung usw habe, wie man sieht habe ich sehr viel ram frei, außerdem wird kein ZFS benutzt. ich benutze nur LVM-Thin für die VMs.

Das problem tritt erst nach migrationen auf, ich habe die vms vor ca. 2 wochen von einem node mit gleicher hardware auf diesen migriert, und davor hatte ich das gleiche spiel auch mal umgekehrt gemacht, da ich 2 von diesen servern 1 zu 1 habe und wartungen gemacht hatte. Das problem ist danach immer aufgetreten, egal auf welchem host die vms am ende waren. Anzumerken ist das nur Windows VMs bis jetzt das problem hatten (es sind wirklich nur diese, alle anderen haben bis jetzt keine probleme) und das ich kein Memory Balloning benutze, weil ich genug ram frei haben sollte (kein ZFS, sehr viel ram frei usw.). Das aktivieren von Memory Balloning hat nicht geholfen bei den betroffenen VMs. Dennoch denke ich nicht das es ein Windows Problem ist, der unterschied ist das Windows 100% des RAMs in jedem fall beanspruchen möchte, und linux das nur nach einer Zeit tut, und hier hatte ich glaube ich auch 1 mal einen Crash einer Debian VM, wo die RAM load der VM fast auf anschlag war.

falls einer weiß, was ich jetzt am besten zum lösen des problems machen soll, gerne her damit. gerne schaue ich mir weiter protokolle an.

Danke im vorraus!

ich stoße seit einiger zeit auf merkwürdige probleme, habe mich schon mit oomk usw auseinandergesetzt, schließe das aber eigentlich mittlerweile aus.

Erstmal das Problem:

Ich habe so 1-2 VMs die wenn man sie startet regelmäßig einfach gekillt werden nach einer zeit (sieht man auch gut an den graphen, es waren keine shutdowns oder stops!)

in den stats der 2 vms sieht man das auf die woche gesehen nicht gut, da die vms nicht länger wie eine halbe stunden anbleiben und dann gekillt werden, es ist aber mittlerweile schon sehr oft aufgefallen, 10 mal oder mehr.

ich habe versucht nach oom logs zu suchen, mit einem einfachen `journalctl -x | grep *oom*`, dabei ist nichts rumgekommen. kein output, also kein match.

nebenbei versuche ich es wieder zu reproduzieren.

Ich möchte anmerken das ich kein problem mit RAM-Überbuchung usw habe, wie man sieht habe ich sehr viel ram frei, außerdem wird kein ZFS benutzt. ich benutze nur LVM-Thin für die VMs.

Das problem tritt erst nach migrationen auf, ich habe die vms vor ca. 2 wochen von einem node mit gleicher hardware auf diesen migriert, und davor hatte ich das gleiche spiel auch mal umgekehrt gemacht, da ich 2 von diesen servern 1 zu 1 habe und wartungen gemacht hatte. Das problem ist danach immer aufgetreten, egal auf welchem host die vms am ende waren. Anzumerken ist das nur Windows VMs bis jetzt das problem hatten (es sind wirklich nur diese, alle anderen haben bis jetzt keine probleme) und das ich kein Memory Balloning benutze, weil ich genug ram frei haben sollte (kein ZFS, sehr viel ram frei usw.). Das aktivieren von Memory Balloning hat nicht geholfen bei den betroffenen VMs. Dennoch denke ich nicht das es ein Windows Problem ist, der unterschied ist das Windows 100% des RAMs in jedem fall beanspruchen möchte, und linux das nur nach einer Zeit tut, und hier hatte ich glaube ich auch 1 mal einen Crash einer Debian VM, wo die RAM load der VM fast auf anschlag war.

falls einer weiß, was ich jetzt am besten zum lösen des problems machen soll, gerne her damit. gerne schaue ich mir weiter protokolle an.

Danke im vorraus!