Hallo,

ich teste aktuell Proxmox 4.2 und bin dabei auf folgendes gestoßen:

Ich sehe in den lxc Containern den Traffic der zu diesem gehörenden Node über tcpdump.

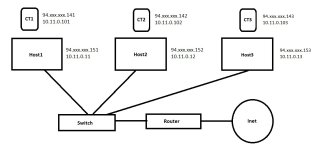

Beispiel (schaulbild siehe skizze2.jpg)

Host 1 /etc/network/interfaces (BRIDGED)

Host 2 /etc/network/interfaces (ROUTED)

Host 3 /etc/network/interfaces (ROUTED)

CT1 /etc/network/interfaces

CT2 /etc/network/interfaces

Wenn ich nun einen Ping von Host 2 auf Host 1 über das 10ner Netz mache, sehe ich diesen Ping auch in CT1. Auch wenn ich von Host2 auf Host3 Traffic erzeuge, ist dies ebenfalls in CT1 auf Host1 sichtbar. In CT2 und CT3 habe ich das Problem nicht, das hat vermutlich etwas mit Bridged/Routed zu tun?

In einer Hosting-Umgebung ist es natürlich fatal, dass ein Container den Traffic der anderen Container sieht.

Gibt es hierfür vielleicht eine Möglichkeit, im Container auch wirklich nur das an Traffic zu sehen, was diesen Container etwas "angeht"? Was müsste ich umstellen oder wie müsste mein Netzwerk aufgebaut sein?

Vielen Dank im Voraus.

ich teste aktuell Proxmox 4.2 und bin dabei auf folgendes gestoßen:

Ich sehe in den lxc Containern den Traffic der zu diesem gehörenden Node über tcpdump.

Beispiel (schaulbild siehe skizze2.jpg)

Host 1 /etc/network/interfaces (BRIDGED)

auto lo

iface lo inet loopback

iface eth0 inet manual

auto vmbr0

iface vmbr0 inet static

address 94.XXX.XXX.151

netmask 255.255.255.224

gateway 94.XXX.XXX.129

bridge_ports eth0

bridge_stp off

bridge_fd 0

auto vmbr0:1

iface vmbr0:1 inet static

address 10.11.0.11

netmask 255.255.0.0

iface lo inet loopback

iface eth0 inet manual

auto vmbr0

iface vmbr0 inet static

address 94.XXX.XXX.151

netmask 255.255.255.224

gateway 94.XXX.XXX.129

bridge_ports eth0

bridge_stp off

bridge_fd 0

auto vmbr0:1

iface vmbr0:1 inet static

address 10.11.0.11

netmask 255.255.0.0

Host 2 /etc/network/interfaces (ROUTED)

auto lo

iface lo inet loopback

auto eth0

iface eth0 inet static

address 94.XXX.XXX.152

netmask 255.255.255.224

pointopoint 94.XXX.XXX.129

gateway 94.XXX.XXX.129

# 1. Sub-Interface

auto eth0:1

iface eth0:1 inet static

address 10.11.0.12

netmask 255.255.0.0

iface lo inet loopback

auto eth0

iface eth0 inet static

address 94.XXX.XXX.152

netmask 255.255.255.224

pointopoint 94.XXX.XXX.129

gateway 94.XXX.XXX.129

# 1. Sub-Interface

auto eth0:1

iface eth0:1 inet static

address 10.11.0.12

netmask 255.255.0.0

Host 3 /etc/network/interfaces (ROUTED)

auto lo

iface lo inet loopback

auto eth0

iface eth0 inet static

address 94.XXX.XXX.153

netmask 255.255.255.224

pointopoint 94.XXX.XXX.129

gateway 94.XXX.XXX.129

# 1. Sub-Interface

auto eth0:1

iface eth0:1 inet static

address 10.11.0.13

netmask 255.255.0.0

iface lo inet loopback

auto eth0

iface eth0 inet static

address 94.XXX.XXX.153

netmask 255.255.255.224

pointopoint 94.XXX.XXX.129

gateway 94.XXX.XXX.129

# 1. Sub-Interface

auto eth0:1

iface eth0:1 inet static

address 10.11.0.13

netmask 255.255.0.0

CT1 /etc/network/interfaces

auto lo

iface lo inet loopback

auto eth0

iface eth0 inet static

address 94.XXX.XXX.141

netmask 255.255.255.224

gateway 94.XXX.XXX.129

iface lo inet loopback

auto eth0

iface eth0 inet static

address 94.XXX.XXX.141

netmask 255.255.255.224

gateway 94.XXX.XXX.129

CT2 /etc/network/interfaces

auto venet0

iface venet0 inet manual

up ifconfig venet0 up

up ifconfig venet0 127.0.0.2

up route add default dev venet0

down route del default dev venet0

down ifconfig venet0 down

iface venet0 inet6 manual

up route -A inet6 add default dev venet0

down route -A inet6 del default dev venet0

auto venet0:0

iface venet0:0 inet static

address 94.xxx.xxx.142

netmask 255.255.255.255

auto venet0:1

iface venet0:1 inet static

address 10.11.0.102

netmask 255.255.255.255

iface venet0 inet manual

up ifconfig venet0 up

up ifconfig venet0 127.0.0.2

up route add default dev venet0

down route del default dev venet0

down ifconfig venet0 down

iface venet0 inet6 manual

up route -A inet6 add default dev venet0

down route -A inet6 del default dev venet0

auto venet0:0

iface venet0:0 inet static

address 94.xxx.xxx.142

netmask 255.255.255.255

auto venet0:1

iface venet0:1 inet static

address 10.11.0.102

netmask 255.255.255.255

Wenn ich nun einen Ping von Host 2 auf Host 1 über das 10ner Netz mache, sehe ich diesen Ping auch in CT1. Auch wenn ich von Host2 auf Host3 Traffic erzeuge, ist dies ebenfalls in CT1 auf Host1 sichtbar. In CT2 und CT3 habe ich das Problem nicht, das hat vermutlich etwas mit Bridged/Routed zu tun?

In einer Hosting-Umgebung ist es natürlich fatal, dass ein Container den Traffic der anderen Container sieht.

Gibt es hierfür vielleicht eine Möglichkeit, im Container auch wirklich nur das an Traffic zu sehen, was diesen Container etwas "angeht"? Was müsste ich umstellen oder wie müsste mein Netzwerk aufgebaut sein?

Vielen Dank im Voraus.