Hallo Leute,

ich bitte um eure Hilfe.

Ich habe einen Proxmox Container den ich 1x im Monat über die Backupfunktion sichere, gesicht wird auf ein Syno Nas.

Das funktioniert alles einwandfrei!

Ich hab im Container Ändeurngen vorgenommen und benötige jetzt aus dem Backup diverse Daten um die wieder im laufenden ystem einzufügen, meine Idee war ich spiele Das Backup in einen neuen Container und exportiere die Daten.

Das will aber leider nciht so wie ich will

Ich hab jetzt mehrere versionen des Restores ausprobiet und bekomme immmer die Ffehlermeldung das nicht genug Platz ist um das Backup einzuspielen.

Es läuft Proxmox: 8.1.10

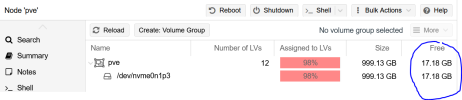

Die PVE sagt: HD space 23.50% (22.07 GiB of 93.93 GiB)

1 Versuch war:

Ich erstelle einen Container mit Plattengrösse mehr as das Backup benötigt, wenn ich dann aber beim gestoppten Container auf Backup gehe ist der Restore Button ausgegraut und ich kann da keine Datei auswählen.

2 Versuch:

Ich bin auf den Storage zweig 'NFS-Backup-Syno' on node 'pve' gegangen wo ich die Backups speichere und hab da dann unter Backups die gewünschte Datei ausgewählt und dann Restore geclickt, hier konnte ich dann in einem Popup noch die Containernummer ändern und den Namen überschreiben, weiters gibts noch den punkt storage, hier konnte ich zwischen local-lvm und NFS-Backup_Syno auswählen, ich hab beides ausprobiert, ergebnis it immer das selbe, und zwar bricht das Restor ab weil kein Speicherplatz vorhanden ist.

Ich hab hier immer einen neuen nicht vorhandenen Container genommen weil einen bestehenen kann ich nicht auswählen.

Hier das Log:

Letzte Variante war dann über die Konsole:

Auch hier war das Problem das selbe, der Restor hat igendwann abgebrochen.

Könnt ihr mir sagen was ich falsch mache?

Danke

ich bitte um eure Hilfe.

Ich habe einen Proxmox Container den ich 1x im Monat über die Backupfunktion sichere, gesicht wird auf ein Syno Nas.

Das funktioniert alles einwandfrei!

Ich hab im Container Ändeurngen vorgenommen und benötige jetzt aus dem Backup diverse Daten um die wieder im laufenden ystem einzufügen, meine Idee war ich spiele Das Backup in einen neuen Container und exportiere die Daten.

Das will aber leider nciht so wie ich will

Ich hab jetzt mehrere versionen des Restores ausprobiet und bekomme immmer die Ffehlermeldung das nicht genug Platz ist um das Backup einzuspielen.

Es läuft Proxmox: 8.1.10

Die PVE sagt: HD space 23.50% (22.07 GiB of 93.93 GiB)

1 Versuch war:

Ich erstelle einen Container mit Plattengrösse mehr as das Backup benötigt, wenn ich dann aber beim gestoppten Container auf Backup gehe ist der Restore Button ausgegraut und ich kann da keine Datei auswählen.

2 Versuch:

Ich bin auf den Storage zweig 'NFS-Backup-Syno' on node 'pve' gegangen wo ich die Backups speichere und hab da dann unter Backups die gewünschte Datei ausgewählt und dann Restore geclickt, hier konnte ich dann in einem Popup noch die Containernummer ändern und den Namen überschreiben, weiters gibts noch den punkt storage, hier konnte ich zwischen local-lvm und NFS-Backup_Syno auswählen, ich hab beides ausprobiert, ergebnis it immer das selbe, und zwar bricht das Restor ab weil kein Speicherplatz vorhanden ist.

Ich hab hier immer einen neuen nicht vorhandenen Container genommen weil einen bestehenen kann ich nicht auswählen.

Hier das Log:

Code:

recovering backed-up configuration from 'NFS-Backup-Syno:backup/vzdump-lxc-102-2025_01_01-00_00_30.tar.zst'

Logical volume "vm-106-disk-0" created.

Creating filesystem with 8126464 4k blocks and 2031616 inodes

Filesystem UUID: d20a6807-ad7d-412c-a70e-7dd16acffc35

Superblock backups stored on blocks:

32768, 98304, 163840, 229376, 294912, 819200, 884736, 1605632, 2654208,

4096000, 7962624

restoring 'NFS-Backup-Syno:backup/vzdump-lxc-102-2025_01_01-00_00_30.tar.zst' now..

extracting archive '/mnt/pve/NFS-Backup-Syno/dump/vzdump-lxc-102-2025_01_01-00_00_30.tar.zst'

tar: ./root/.npm/_cacache/content-v2/sha512/0a/ce/c2a5443a072ff4183d029261f2d4223191cea8d9f0e1219d4070ede1adc84ca6c9319325eedd6945a9be1a5b7cb37418283414a6d453bfcd932ebc1e6983: Wrote only 9728 of 10240 bytes

tar: ./root/.npm/_cacache/content-v2/sha512/5b: Cannot mkdir: No space left on device

tar: ./root/.npm/_cacache/content-v2/sha512/5b: Cannot mkdir: No space left on device

tar: ./root/.npm/_cacache/content-v2/sha512/5b/70: Cannot mkdir: No such file or directory

tar: ./root/.npm/_cacache/content-v2/sha512/5b: Cannot mkdir: No space left on device

tar: ./root/.npm/_cacache/content-v2/sha512/5b/70/71ea67644531ad9492123af543fe56ea8d394f3d40d33279576459d5c22f4d289ead88093a2d5765859326d7b5598acaa129c833a4ee56cfdd4f0ade5bd3: Cannot open: No such file or directory

tar: ./root/.npm/_cacache/content-v2/sha512/5b: Cannot mkdir: No space left on device

tar: ./root/.npm/_cacache/content-v2/sha512/5b/35: Cannot mkdir: No such file or directory

tar: ./root/.npm/_cacache/content-v2/sha512/5b: Cannot mkdir: No space left on device

tar: ./root/.npm/_cacache/content-v2/sha512/5b/35/9de6f2290f837c0048925775903594d142b983fb37c7ae699e4564770b15ecc7231e116f7cb207f1d758b0510b92209b044c4b58b2e051087fb82c138543: Cannot open: No such file or directory

tar: ./root/.npm/_cacache/content-v2/sha512/5b: Cannot mkdir: No space left on device

tar: ./root/.npm/_cacache/content-v2/sha512/5b/81: Cannot mkdir: No such file or directory

tar: ./root/.npm/_cacache/content-v2/sha512/5b: Cannot mkdir: No space left on device

tar: ./root/.npm/_cacache/content-v2/sha512/5b/81/9f2bedfd199faed26bf145551c545086ea0a68b1fcc49d2045db44ff354c1600a1b9f70413d5d51b4b5362c51200b11ba1a46738271eb9f5c12b1501f43e: Cannot open:

.......

hab hier alles rausgelöscht aufgrund der größe!

.......

Total bytes read: 30960220160 (29GiB, 590MiB/s)

tar: Exiting with failure status due to previous errors

Logical volume "vm-106-disk-0" successfully removed.

TASK ERROR: unable to restore CT 106 - command 'lxc-usernsexec -m u:0:100000:65536 -m g:0:100000:65536 -- tar xpf - --zstd --totals --one-file-system -p --sparse --numeric-owner --acls --xattrs '--xattrs-include=user.*' '--xattrs-include=security.capability' '--warning=no-file-ignored' '--warning=no-xattr-write' -C /var/lib/lxc/106/rootfs --skip-old-files --anchored --exclude './dev/*'' failed: exit code 2Letzte Variante war dann über die Konsole:

Auch hier war das Problem das selbe, der Restor hat igendwann abgebrochen.

Könnt ihr mir sagen was ich falsch mache?

Danke